GPT-X:GPT类模型介绍(附相关论文和github项目)

1. GPT介绍

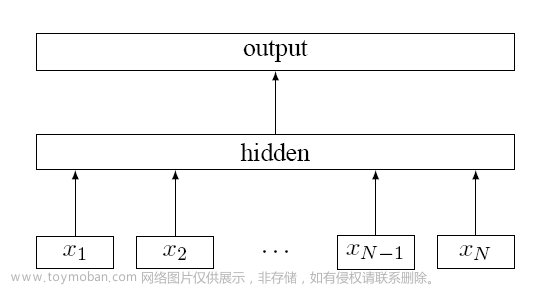

GPT(Generative Pre-trained Transformer)是一类基于Transformer架构的预训练语言模型。这一类模型采用自回归的方式进行训练,通过大规模的语料库预训练来学习语言的概率分布,从而能够用于各种自然语言处理任务。

2. GPT类模型介绍

(1)GPT-1

GPT-1是由OpenAI于2018年推出的第一代GPT模型,使用了12层Transformer架构,共有117M个参数。GPT-1在多项自然语言处理任务上均取得了较好的效果,例如文本生成、机器翻译、问答等。

论文:https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf

github链接:https://github.com/karpathy/minGPT

(2)GPT-2

GPT-2是在GPT-1的基础上进一步扩展和优化的模型,使用了更大的数据集和更多的参数。GPT-2采用了48层Transformer架构,共有1.5B个参数。GPT-2在多项自然语言处理任务上取得了SOTA的效果,例如文本生成、文本分类、语言推理等。GPT-2还引起了广泛的社会讨论,因为它能够生成高度逼真的文本,包括假新闻和有害内容。

论文:https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf

github链接:https://github.com/openai/gpt-2

(3)GPT-3

GPT-3是当前最大的预训练语言模型,由OpenAI于2020年推出。GPT-3使用了1750B个参数,比GPT-2大了一千倍以上。GPT-3在多项自然语言处理任务上取得了SOTA的效果,并能够完成一些常识推理和常识问答等任务。与GPT-2相比,GPT-3不仅参数更多,而且采用了更多的训练数据,以及更加复杂的预训练任务。

论文:https://arxiv.org/pdf/2005.14165.pdf

github链接:https://github.com/openai/gpt-3

(4)GPT-Neo

GPT-Neo是由EleutherAI推出的一个社区项目,旨在构建一个更加开放和透明的预训练语言模型。GPT-Neo使用了和GPT-3类似的训练数据和预训练任务,但是采用了更加分散的训练和模型分布式计算的方式,以此来避免依赖于单个GPU或TPU。GPT-Neo目前已经推出了多个版本,包括GPT-Neo 1.3B、2.7B和6B。

论文:https://pile.eleuther.ai/

github链接:https://github.com/EleutherAI/gpt-neo

(5)GShard-GPT

GShard-GPT是谷歌研究团队于2021年推出的一种基于GShard的高效分布式GPT预训练模型。与传统的GPT模型不同,GShard-GPT将Transformer架构的每个层都分割成了多个“分片”(Shard),并且每个分片都可以在不同的设备上并行处理。GShard-GPT使用了与GPT-3相同的训练数据和任务,并将模型的大小扩展到了600B个参数。

论文:https://arxiv.org/abs/2006.16668

(6)GPT-J

GPT-J是由EleutherAI团队于2021年推出的一个大型预训练语言模型,使用了6B个参数。GPT-J使用了和GPT-3类似的训练数据和预训练任务,并且采用了分布式的训练方式。GPT-J的主要目标是提供一个可访问、高质量的自然语言处理工具,以便开发人员和研究人员可以更容易地使用自然语言技术。

论文:https://arxiv.org/abs/2302.04761

github链接:https://github.com/kingoflolz/mesh-transformer-jax

(7)GPT-4

GPT-4是目前还未推出的一种预训练语言模型,但已经引起了广泛的关注。OpenAI的研究人员曾在2021年宣布正在研发GPT-4,而且计划将模型的大小扩展到数万亿个参数。但目前尚不清楚GPT-4何时推出以及具体的技术细节。

(8)PEGASUS

一种由谷歌研究团队开发的预训练模型,使用了Transformer架构,但不是采用自回归方式进行训练,而是采用了自编码器(autoencoder)架构。PEGASUS主要用于文本摘要任务。

论文:https://arxiv.org/pdf/1912.08777.pdf

github链接:https://github.com/google-research/pegasus

(9)T5

一种由谷歌研究团队推出的预训练模型,采用了与GPT类似的Transformer架构,但是可以用于多种自然语言处理任务,例如文本分类、命名实体识别等。T5也可以用于生成型任务,例如文本生成和文本摘要。

论文:https://arxiv.org/pdf/1910.10683.pdf

github链接:https://github.com/google-research/text-to-text-transfer-transformer

(10)GShard

一种由谷歌研究团队开发的分布式训练框架,可以用于训练大型的预训练语言模型。GShard的核心思想法是将模型分成多个分片(Shard),并且每个分片都可以在不同的设备上并行处理,从而加速模型训练。GShard已经应用于多个预训练模型中,例如T5和GPT-2。

论文:https://arxiv.org/pdf/2006.16668.pdf

(11)ELECTRA

一种由谷歌研究团队推出的预训练模型,采用了一种新的训练方式,称为“替代生成任务”(Replacing Token Detection),可以大大减少训练时间和计算资源的消耗。ELECTRA的性能与同等大小的BERT模型相当,但训练速度更快。

论文:https://arxiv.org/pdf/2003.10555.pdf

github链接:https://github.com/google-research/electra

(12)总结

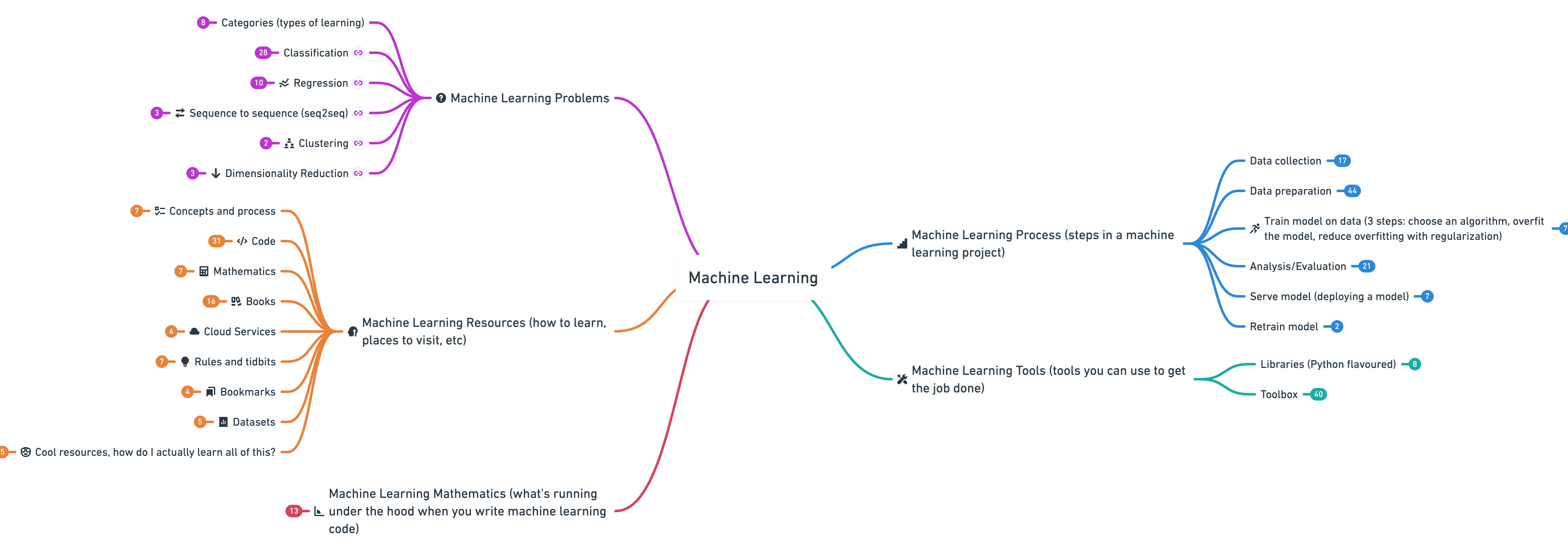

GPT类模型是自然语言处理领域的重要突破之一,其在多项自然语言处理任务上取得了优异的表现。随着技术的不断发展和研究的不断深入,GPT类模型的规模也越来越大,性能也越来越强。同时,也涌现出了许多不同的GPT变种和改进版,以满足不同应用场景和需求。未来,GPT类模型还有很大的发展空间和潜力,我们可以期待更多的创新和突破。

3. GPT类模型的区别和联系

-

模型规模:GPT、GPT-2和GPT-3的规模依次增大。GPT有117M个参数,GPT-2有1.5B个参数,GPT-3则有175B个参数。这意味着每个模型可以处理的任务和数据集越来越大。

-

数据集和训练方式:这三个模型都使用了大量的无标注数据进行训练,其中包括了网络上的大量文本和语言数据。GPT使用的数据集是WebText,GPT-2使用的数据集包括了WebText、BooksCorpus、Common Crawl等多个数据集,而GPT-3则使用了更多的数据集,包括Common Crawl、Wikipedia、Books等。

-

任务和应用:这三个模型都可以用于语言生成和相关的自然语言处理任务,如文本分类、摘要生成、对话系统等。但是,由于规模和训练数据集的不同,它们的性能和应用场景也有所不同。例如,GPT-3在机器翻译等任务上的表现要比GPT-2好得多,而GPT-2在文本生成方面则更加灵活和多样化。

-

论文和代码:这三个模型的论文和代码都是公开的,研究者和开发者可以在自己的任务上进行改进和优化。此外,一些变种的代码和论文也已经发布,例如GPT-Neo、GShard、GPT-J等。文章来源:https://www.toymoban.com/news/detail-428429.html

参考文献

[1] GPT-1/GPT-2/GPT-3简介 https://zhuanlan.zhihu.com/p/473001104

[2] 让ChatGPT长“手”!Meta爆火新论文,让语言模型学会自主使用工具 https://www.51cto.com/article/746420.html

[3] GPT-3没有亲自上手,不如展望一下GPT-4?https://baijiahao.baidu.com/s?id=1674342266465949516

[4] 帝国理工联手谷歌提出抽象文本摘要最佳模型|ICML 2020 https://baijiahao.baidu.com/s?id=1671531819242389224

[5] ICLR 2020|electra https://zhuanlan.zhihu.com/p/263010688文章来源地址https://www.toymoban.com/news/detail-428429.html

到了这里,关于【NLP相关】GPT-X合集:GPT类模型介绍(附相关论文和Github项目地址)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!