Hive介绍

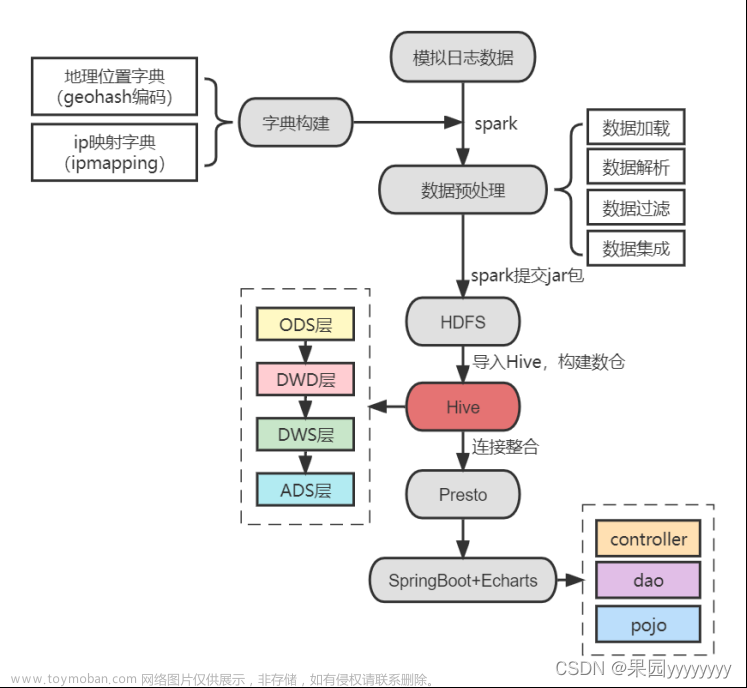

Hive是基于 Hadoop 的一个数据仓库工具,用于做OLAP 分析数据。Hive的数据存储在hadoop的hdfs中。

hive 提供了内置的derby存储元数据,不需要单独配置metastore 也不需要单独启动metastore服务,但一般适合单机。但是开发中一般使用远程模式,将元数据存储在外置的RDBMS中。这种模式下metastore服务单独配置,需要手动启动,且全局唯一。

Hive Driver驱动程序 是hive的核心,完成从接受HQL到编译成为MR程序的过程。

metadata 元数据存储。 描述性数据。对于hive来说,元数据指的是表和文件之间的映射关系。

Hive的第二代客户端启动

首先启动metastore服务 再启动hiveserver2服务

nohup /export/server/apache-hive-3.1.2-bin/bin/hive --service metastore &

nohup /export/server/apache-hive-3.1.2-bin/bin/hive --service hiveserver2 &

安全模式

有时候,无法启动hive,可能是Hadoop还处在安全模式中。

使用命令hdfs dfsadmin -safemode get查看安全模式

使用命令hdfs dfsadmin -safemode leave离开安全模式,使用hdfs dfsadmin -safemode forceExit强制退出安全模式。文章来源:https://www.toymoban.com/news/detail-446959.html

hive登录命令:beeline -u jdbc:hive2://hadoop01:10000 -n root -p 123456文章来源地址https://www.toymoban.com/news/detail-446959.html

到了这里,关于hadoop&Hive安全模式的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!