在Hadoop中,使用jps命令可以列出当前运行的Java进程,包括Hadoop的各个组件。如果jps命令没有显示namenode,那可能是以下几个原因之一:

-

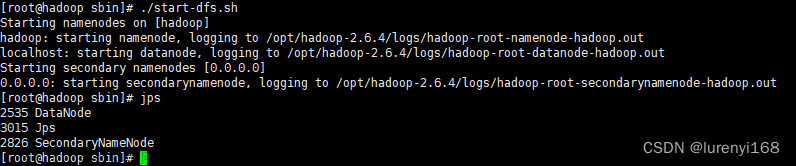

namenode进程没有启动。在运行Hadoop集群之前,需要确保启动了namenode进程,否则jps命令不会显示该进程。可以使用start-dfs.sh命令来启动Hadoop集群。文章来源:https://www.toymoban.com/news/detail-509792.html -

namenode进程已经停止或崩溃。如果namenode进程由于某些原因停止或崩溃了,那么jps命令将不会显示该进程。可以检查namenode的日志文件,查看是否有任何错误或异常信息。文章来源地址https://www.toymoban.com/news/detail-509792.html

到了这里,关于hadoop中jps命令后没有namenode的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!