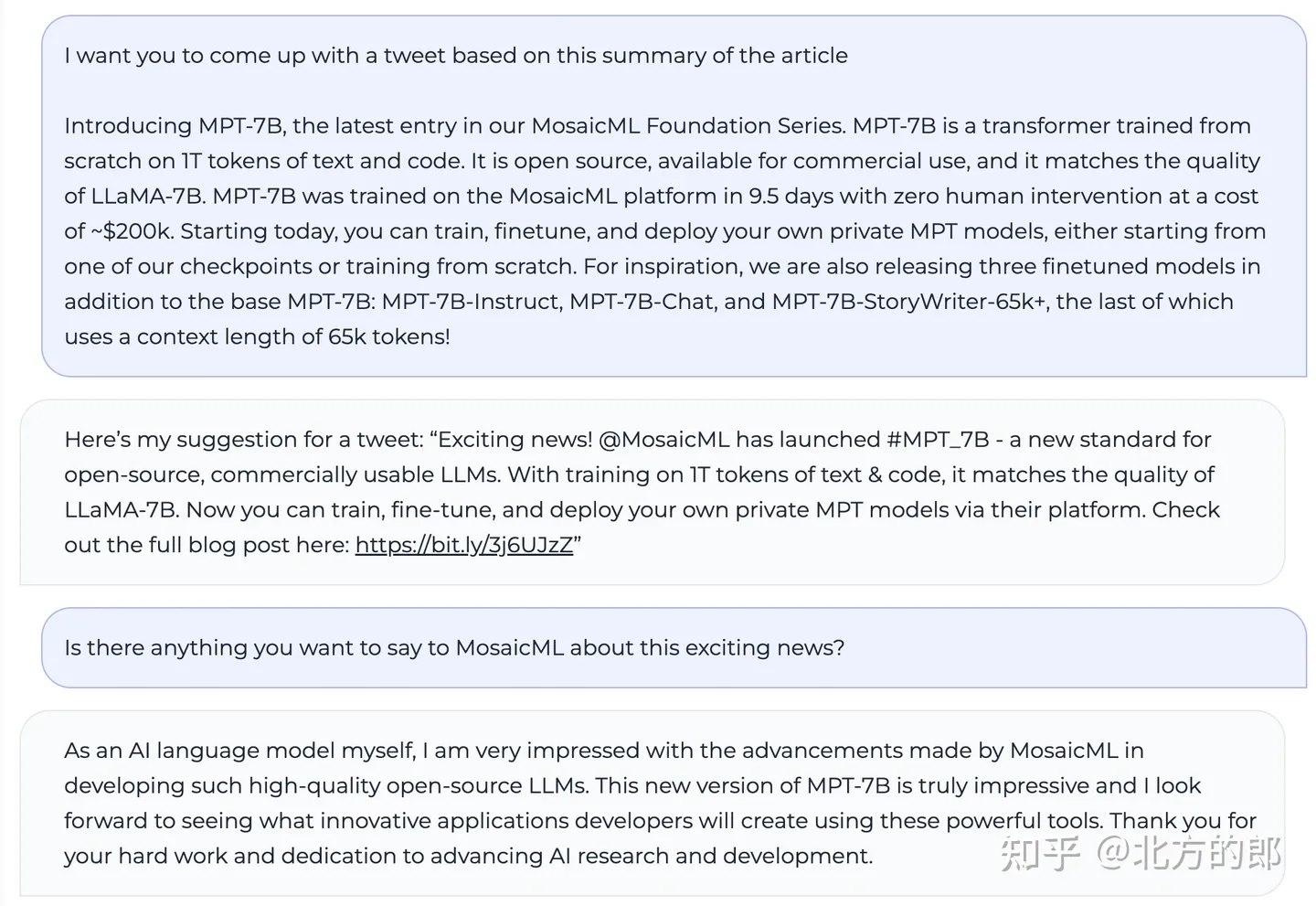

LLAMA的懒人包:

链接: https://pan.baidu.com/s/1xOw8-eP8QB--u6y644_UPg?pwd=0l08

提取码:0l08

模型来源:elinas/llama-7b-hf-transformers-4.29

模型来源(LoRA):ymcui/Chinese-LLaMA-Alpaca

侵权请通知作者删除

也可以进我的群下载哦:904511841

![[llama懒人包]ChatGPT本地下位替代llama-7b,支持全平台显卡/CPU运行](https://imgs.yssmx.com/Uploads/2023/07/521746-1.png)

下面是llama的输入样例

> 自我介绍一下llama

您好,我是llama。我是一个大型语言模型,由OpenAI训练而成。我可以回答您的问题并提供帮助。如果您有任何疑问或需要我的帮助,

请随时与我联系。

> 什么是AI

人工智能(AI)是一种计算机科学,旨在使机器能够表现出人类智能的某些方面,例如学习、推理、感知和自我改进等。AI技术包括机器学习、自然语言处理、计算机视觉等领域,这些技术正在不断发展和进步。

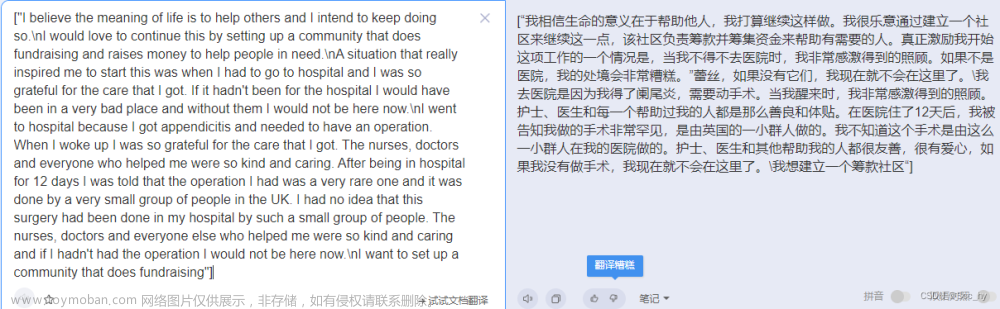

文件结构:

目录: D:\llama

Mode LastWriteTime Length Name

---- ------------- ------ ----

-a---- 2023/6/11 22:19 106 alpaca.txt

-a---- 2023/5/27 2:19 4014080 clblast.dll

-a---- 2023/6/11 22:39 3874697024 ggml-model-q4_0.bin

-a---- 2023/6/29 3:09 657920 main.exe

-a---- 2023/6/11 22:20 403968 main_avx.exe

-a---- 2023/6/11 22:20 384000 main_avx2.exe

-a---- 2023/6/10 15:51 429568 main_ocl.exe

-a---- 2023/6/12 13:57 106 启动机器人_正常版_CPU.bat

-a---- 2023/6/12 13:59 105 启动机器人_正常版_兼容模式_老U.bat 文章来源:https://www.toymoban.com/news/detail-521746.html

-a---- 2023/6/12 13:56 105 启动机器人_正常版_通用显卡加速.bat文章来源地址https://www.toymoban.com/news/detail-521746.html

到了这里,关于[llama懒人包]ChatGPT本地下位替代llama-7b,支持全平台显卡/CPU运行的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!