介绍

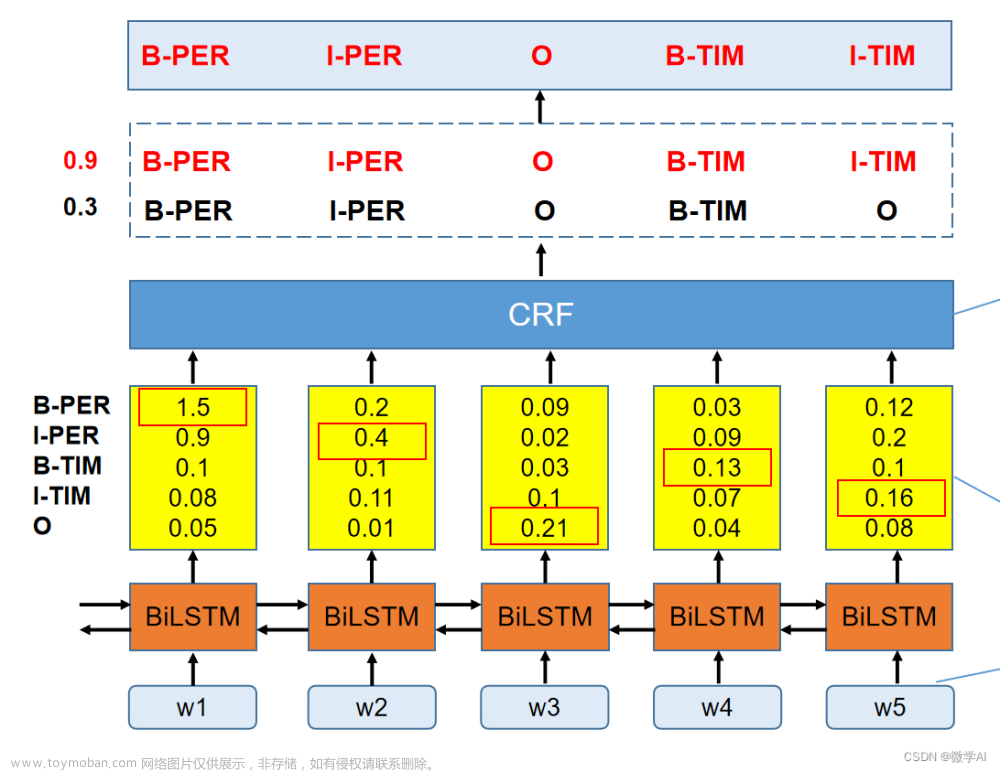

命名实体识别是自然语言处理(NLP)领域的一项主要任务。它用于检测文本中的实体,以便在下游任务中进一步使用,因为某些文本/单词对于给定上下文比其他文本/单词更具信息性和重要性。这就是 NER 有时被称为信息检索的原因,即从文本中提取相关关键词并将其分类为所需的类别。文章来源:https://www.toymoban.com/news/detail-675529.html

借助命名实体识别,我们可以从医疗记录中提取一般性和特定领域的人员、地点、组织等,例如临床术语、药物、疾病等,以便更好地诊断。文章来源地址https://www.toymoban.com/news/detail-675529.html

先决条件

- Python 的应用知识以及使用 Pytorch 训练神经网络

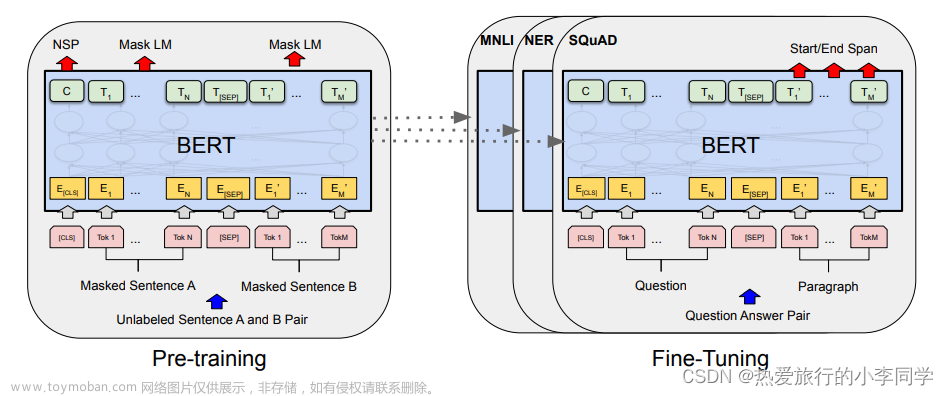

- 有关 Transformer 和 BERT 架构的知识

到了这里,关于在 Google Colab 中微调用于命名实体识别的 BERT 模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[oneAPI] 基于BERT预训练模型的命名体识别任务](https://imgs.yssmx.com/Uploads/2024/02/663158-1.png)