Spark 底层使用 Scala 开发有以下几个原因:

基于Scala的语言特性

-

集成性:Scala 是一种运行在 Java 虚拟机(JVM)上的静态类型编程语言,可以与 Java 代码无缝集成。由于 Spark 涉及到与大量 Java 生态系统的交互,例如 Hadoop、Hive 等,使用 Scala 可以方便地与这些组件进行集成和交互。

-

函数式编程支持:Scala 是一种面向函数式编程的语言,提供了丰富的函数式编程特性,如高阶函数、闭包等。这些特性使得编写复杂的数据处理逻辑变得更加简洁和灵活,而大规模数据处理正是 Spark 的核心任务之一。因此,Scala 为 Spark 提供了一种非常适合处理数据流的语言基础。

-

强类型系统:Scala 是一种静态类型语言,拥有强大的类型系统。通过静态类型检查,可以在编译期间捕获一些潜在的错误,提高代码的可靠性和稳定性。这对于 Spark 这样大规模数据处理的框架至关重要,因为它可以帮助开发人员尽早发现潜在的问题。

-

可扩展性:Scala 具有良好的可扩展性,可以轻松地扩展现有的代码库,以适应 Spark 框架不断增长的需求。同时,Scala 还提供了丰富的函数式编程特性,如类型推断、模式匹配等,使得代码的组织和重用更加方便。

-

并发性:Scala 提供了强大的并发编程特性,例如

Future、Actor等。这些特性使得在 Spark 中处理并发任务更加高效和简洁,从而提高了系统的性能和可伸缩性。

Scala 提供了强大的并发编程特性

Scala 提供了强大的并发编程特性,这主要基于以下几个方面:

-

Future和Promise:Scala 标准库提供了scala.concurrent.Future和scala.concurrent.Promise类,用于处理异步计算和并发操作。Future表示一个可能还未完成的计算结果,而Promise则是对Future的简单抽象,可以用来设置Future的结果。通过Future和Promise,可以方便地进行并行计算、异步操作和任务组合,提高代码的效率和性能。 -

Actor模型:Scala 通过Akka库提供了Actor模型的支持。Actor是并发和分布式计算中的基本单位,它是一种轻量级的并发原语,用于实现消息传递和并发任务的处理。Scala 中的Actor可以通过消息传递进行通信,每个Actor都有自己的状态和行为,并且可以相互之间进行消息的发送和接收。使用Actor模型,可以通过消息传递实现并发任务的解耦和灵活性,避免共享状态带来的并发问题。 -

并发集合(Concurrent Collections):Scala 提供了一系列并发集合类,如

ConcurrentHashMap、ConcurrentLinkedQueue等,它们是线程安全的,并且提供了并发访问和更新的方法。在多线程环境下,使用这些并发集合可以简化对共享数据的访问和管理,避免线程安全的问题,提高并发性能。 -

样本(Pattern)和不可变性:Scala 支持函数式编程风格,并鼓励使用不可变数据结构。不可变数据结构天然地支持并发,因为多个线程可以并发地读取不可变数据,而无需担心数据的修改。此外,Scala 的样本匹配机制(Pattern Matching)可以帮助开发者处理并发场景中的不同情况和消息,使得代码更加清晰和易于理解。

scala的Future与java多线程中的Future接口,他们之间有什么关系?

Scala 的 Future 类是基于 Java 的 Future 接口进行扩展和增强的,它们之间存在一定的关系。

在 Scala 中,scala.concurrent.Future 是一个非阻塞的、并发编程的核心类,它提供了以异步方式处理任务的功能。Future 类定义了一组操作符和组合方法,使得异步计算的编写和组合更加方便和灵活。

与此同时,Java 的 java.util.concurrent.Future 接口也用于表示可能还未完成的计算结果。它可以用于提交任务并获取最终结果,但相对于 Scala 的 Future,Java 的 Future 功能较为简单。Java 8 引入的 CompletableFuture 类提供了类似于 Scala Future 的操作符和组合功能,但仍然不如 Scala Future 强大。

Scala 的 Future 类库使用了 Java 的 ExecutorService 和 ScheduledExecutorService 类来执行异步任务,底层仍然是基于 Java 的线程池实现。

需要注意的是,Scala 的 Future 类和 Java 的 Future 接口之间并没有直接的继承关系,虽然它们都用于处理可能还未完成的计算结果。Scala 的 Future 更像是对 Java 的 Future 进行了扩展和增强,提供了更丰富的功能和操作符。

因此,尽管 Scala 的 Future 类与 Java 的 Future 接口有一定的关系,但它们是独立的并发编程模型,各自具有不同的特性和功能。

虽然它们的名称相似,但在功能和用法上有一些区别。下面是它们之间的主要区别:

-

Scala 的

Future是一个只读的、不可变的抽象类,它表示一个可能还未完成的计算结果。你可以将任务提交给Future,并在任务完成后获取到结果。它通常用于处理异步计算和并发操作。Java 的

Future接口也用于表示可能未来完成的计算结果,但它是一个可写的接口。通过调用cancel()方法可以取消任务的执行,而且还提供了一些其他方法如isDone()和get()来查询任务的状态和获取最终结果。 -

Scala 的

Future提供了更加丰富的操作符和组合功能,例如map、flatMap、filter等,可以对多个Future进行转换、组合和过滤,从而构建复杂的异步计算流程。Java 的

Future接口相对较为简单,没有提供类似的操作符和组合功能。虽然 Java 8 中引入了CompletableFuture类来提供类似的功能,但与 Scala 的Future相比,仍然较为有限。

总的来说,Scala 的 Future 更加强大和灵活,提供了更多的操作符和组合功能,使得异步编程更加方便和高效。在 Scala 中,你可以使用 Future 来处理并发任务、异步操作和任务的组合。

如何理解Scala中的Promise类?它的底层是怎么实现的?

在 Scala 中,Promise 是一个用于表示异步计算结果的类。它是对 Future 的一种补充,可以将值设置到 Promise 中,并且可以通过 Promise 来获取最终的结果。

Promise 的底层源码基于 Future 和 synchronization 实现。底层的原理如下:

-

Promise类包含了一个Future对象,用于保存最终的结果。 - 当你创建一个

Promise实例时,它会同时创建一个关联的Future对象。 - 你可以使用

Promise的success、failure或complete方法来设置Future的结果。-

success(value: T): Promise.this.type:将Future的结果标记为成功,并设置结果值为value。 -

failure(cause: Throwable): Promise.this.type:将Future的结果标记为失败,并设置失败原因为cause。 -

complete(result: Try[T]): Promise.this.type:根据Try对象的结果设置Future的结果。

-

- 在调用

success、failure或complete之后,关联的Future将会收到相应的通知并得到最终结果。 - 如果你需要获取

Promise关联的Future,可以使用future属性进行访问。

底层实现使用了同步机制来确保在多线程环境下的正确性。当调用 success、failure 或 complete 方法时,Promise 会检查当前的状态,如果状态尚未改变,则设置 Future 的结果,并通知正在等待的线程。

在使用 Promise 和 Future 时,你可以将异步计算任务提交给 Promise,并在其他地方通过关联的 Future 来获取最终的结果。这种方式可以更加灵活地进行异步计算和处理,并提供了更多的控制能力。

总的来说,Promise 是 Scala 中用于设置异步计算结果的类,它的底层源码利用了 Future 和同步机制来实现异步计算的处理。

如何理解Spark中的RDD抽象数据模型

RDD 是 Spark 中最基本的数据抽象和计算模型,它的实现涉及以下几个核心概念和原理:

-

数据分片(Partitioning):RDD 将数据集合切分为多个逻辑分片,每个分片代表了数据的一部分。分片的大小通常会根据数据的大小和集群的规模进行自动调整。

-

弹性分布式数据集(Resilient Distributed Dataset):RDD 将数据分布在集群中的多个节点上,每个节点上可以保存一个或多个数据分片。RDD 具有容错性,即在节点故障时可以恢复丢失的数据分片。

-

转换和动作(Transformations and Actions):RDD 提供了一组转换和动作操作,用于对数据集合进行处理和操作。转换操作(Transformations)是惰性计算的,只记录了要对 RDD 进行的转换操作,并不真正执行计算。动作操作(Actions)则触发实际的计算,并返回结果或副作用。

-

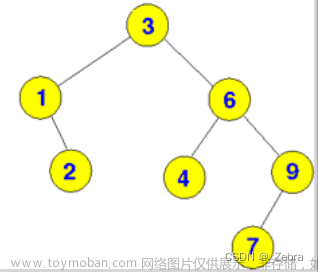

依赖关系(Dependency):RDD 之间的转换操作会构成依赖关系。每个 RDD 都记录了自己的父 RDD 的依赖关系,这样在执行计算时可以通过链式调用进行血缘追踪,以便在需要时重新计算丢失的数据分片。

-

宽依赖和窄依赖(Wide and Narrow Dependencies):依赖关系可以分为宽依赖和窄依赖。窄依赖表示每个父分区最多只被一个子分区使用,这种依赖关系允许并行计算。而宽依赖表示同一个父分区可能被多个子分区使用,这种依赖关系会导致数据的 shuffle 操作,降低了并行度和性能。

-

数据分片的计算和调度:Spark 使用任务调度器将 RDD 的转换操作划分为多个任务,并将这些任务分发到集群中的不同节点上进行计算。计算节点上的任务会根据 RDD 的依赖关系和分片信息进行数据的加载、转换和保存。

-

内存缓存(In-Memory Caching):RDD 可以选择将数据分片缓存在内存中,以便在后续迭代计算中更快地访问。缓存 RDD 可以避免重复计算和磁盘 I/O,提高计算性能。文章来源:https://www.toymoban.com/news/detail-693280.html

这些原理使得 RDD 具备了弹性、容错、并行计算和优化的特性,从而能够支持 Spark 的分布式计算和数据处理。通过对 RDD 的转换和动作操作的灵活组合,可以实现复杂的数据处理任务,并通过合理的调度和缓存策略提高计算性能。文章来源地址https://www.toymoban.com/news/detail-693280.html

到了这里,关于spark底层为什么选择使用scala语言开发的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!