视频版教程:一天掌握python爬虫【基础篇】 涵盖 requests、beautifulsoup、selenium

百度搜索请求地址:

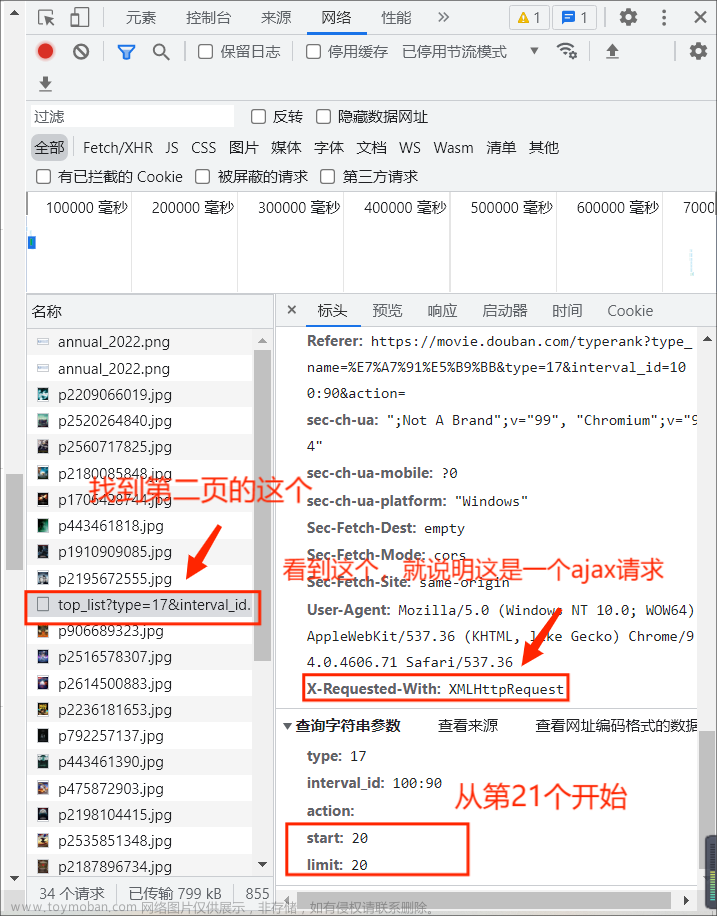

https://www.baidu.com/s?wd=宝马如果我们直接用requests.get()进行访问,发现没有返回内容,因为百度服务器通过headers头信息做了反爬手段,所以我们请求的时候,要带上headers头信息;以及requests支持请求参数key:value格式传递,我们可以通过url打印看结果。文章来源:https://www.toymoban.com/news/detail-722017.html

所以标准代码案例如下:文章来源地址https://www.toymoban.com/news/detail-722017.html

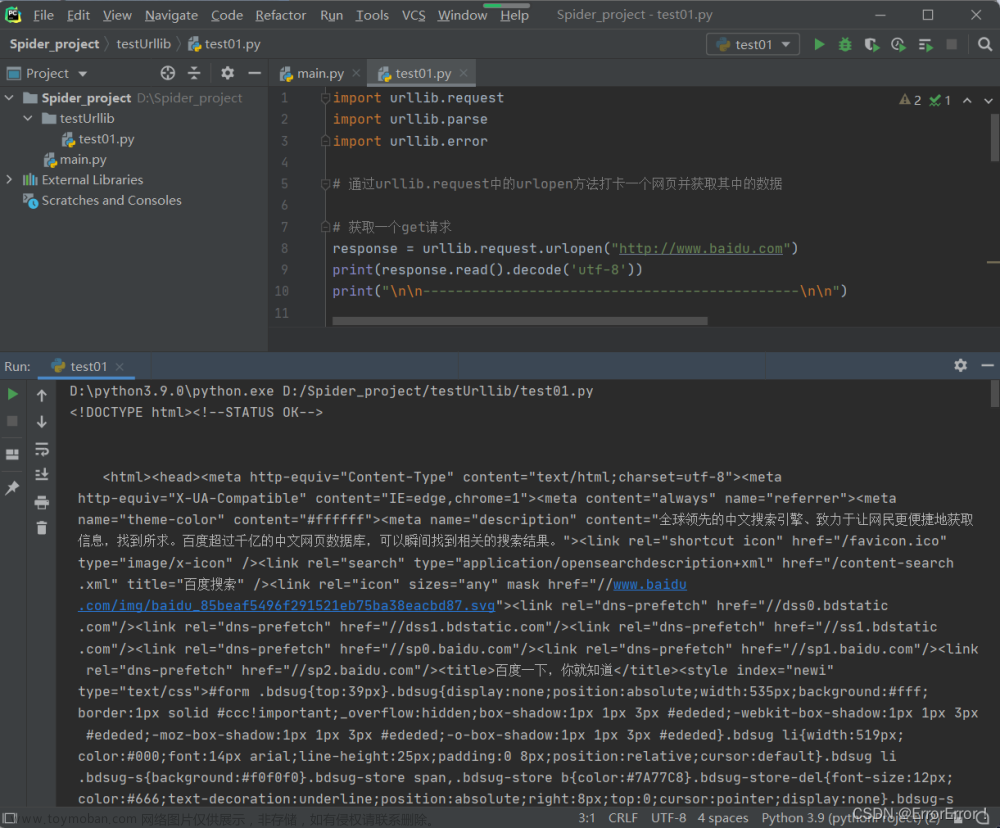

import requests

url = "https://www.baidu.com/s"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/117.0.0.0 Safari/537.36'

}

data = {

'wd': '宝马'

}

r = requests.get(url=url, params=data, headers=headers)

print(r.url)

print(r.status_code)

print(r.text)到了这里,关于requests之get请求实例-百度搜索的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!