| 实训课题 |

Hadoop集群安装配置和详细搭建过程 |

| 实验步骤: 一、虚拟机的安装部署 二、Linux系统安装部署 1.环境准备 2.系统安装 三、Centos系统安装 四、静态网络配置 五、虚拟机完整克隆配置 六、配置hosts文件和ssh免密登录 七、Hadoop集群配置 八、Hadoop集群测试 | |

(1)虚拟软件:VMware16 (2)VMMware版本:VMware Workstation 16 Pro (3)vmware官方下载地址:https://www.vmware.com/cn/products/workstation-pro/workstation-pro-evaluation.html (4)安装系统环境:Windows 10 | |

(1)配置环境准备

(2)系统安装 2.1新建虚拟机并且选择安装程序光盘映像文件(iso)

2.2虚拟机配置如下

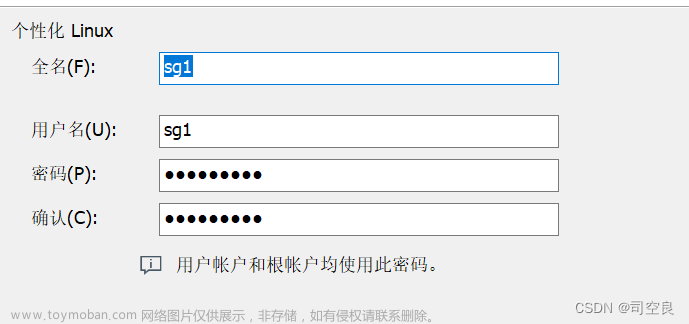

三、Centos7系统安装 3.1开启虚拟机 3.2安装Centos7系统

3.3进行配置

3.4进行登录

四、静态网络配置 4.1 检查网络的连通性 命令:ping www.baidu.com

4.2 打开ssh服务 4.2.1查看SSH是否安装 rpm -qa | grep ssh

Centos7 默认安装了ssh包 4.2.2安装缺失的包、并配置SSH yum install openssh*

完成!!!! 4.2.3注册使用服务,重启SSH服务

4.3配置虚拟机的网络

4.4修改网络配置文件(ifcfg-ens33) 命令:vi /etc/sysconfig/network-scripts/ifcfg-ens33

Ps:如果配置完成后无法连通网络,添加centos7的mac地址到ifcfg-ens33中。 4.5 重启网络服务,查看配置是否成功

4.6重启虚拟机后,查看是否连通网络 命令:重启reboot ;查看ifconfig;检查ping www.baidu.com 五、虚拟机完整克隆配置 5.1克隆虚拟机

5.2修改主机名

5.3修改网络配置文件

5.4重新启动网络配置

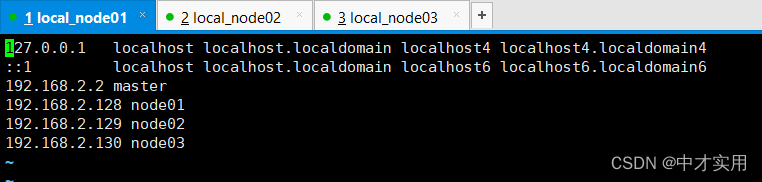

六、配置hosts文件和ssh免密登录 1.修改hosts配置文件(所有虚拟机都需要配置此文件,此处只列举一台虚拟机) 命令:vi /etc/hosts

2.生成秘钥文件(四次回车) 命令:ssh-keygen -t rsa

3.将本机公钥文件复制到其它虚拟机上(接收方需先开机) 命令:ssh-copy-id yangjian01 ssh-copy-id yangjian02 ssh-copy-id yangjian03 ssh-copy-id yangjian00

4.上一步的命令在虚拟机yangjian00 yangjian01 yangjian02,yangjian03都需要执行,保证三台主机都能够免密登录 5.测试是否免密登录成功(ssh yangjian01)

成功!!!! 七、Hadoop集群配置 1.在所有centos7虚拟机根目录下新建文件夹export,export文件夹中新建data、servers和software文件 命令: mkdir -p /export/data mkdir -p /export/servers mkdir -p /export/software 2.准备安装包

3.下载安装软件SecureCRT和FX 4.利用FX将安装包传输到centos7虚拟机根目录下/export/software文件夹内

5.安装JDK(所有虚拟机都要配置) 5.1 解压JDK cd /export/software tar -zxvf jdk-8u144-linux-x64.tar.gz -C /export/servers/ 5.2配置环境变量 编辑文件:vi /etc/profile #tip:在配置文件末尾追加 export JAVA_HOME=/export/servers/ jdk-1.8.4-144 export PATH=$PATH:$JAVA_HOME/bin export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export JAVA_HOME PATH CLASSPATH 5.3 使配置文件生效

5.4 查看是否配置成功

6.安装Hadoop(所有虚拟机都要配置) 6.1 解压hadoop cd /export/software tar -zxvf hadoop-2.7.3.tar.gz -C /export/servers/ 6.2 打开配置文件 vi/etc/profile 6.3 配置环境变量 #tip:在文件末尾追加 export HADOOP_HOME=/export/servers/hadoop-2.7.3 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

6.4 使配置文件生效

6.5查看是否配置成功

7.Hadoop集群配置 7.1 进入配置文件目录 命令:cd /export/servers/hadoop-2.7.3/etc/hadoop/

7.2 修改hadoop-env.sh文件 命令:vi hadoop-env.sh #tip:找到相应位置,添加这段话 export JAVA_HOME=/export/servers/jdk-1.8.4-144

7.3 修改core-site.xml文件(命令:vi core-site.xml) #tip:下图中乱码部分为注释代码,可以删掉,不影响 <configuration> <!--用于设置Hadoop的文件系统,由URI指定--> <property> <name>fs.defaultFS</name> <!--用于指定namenode地址在hadoop01机器上--> <value>hdfs://yangjian00:9000</value> </property> <!--配置Hadoop的临时目录,默认/tem/hadoop-${user.name}--> <property> <name>hadoop.tmp.dir</name> <value>/export/servers/hadoop-2.7.3/tmp</value> </property> </configuration>

7.4 修改hdfs-site.xml文件(命令:vi hdfs-site.xml) <configuration> <!--指定HDFS的数量--> <property> <name>dfs.replication</name> <value>3</value> </property> <!--secondary namenode 所在主机的IP和端口--> <property> <name>dfs.namenode.secondary.http-address</name> <value>yangjian01:50090</value> </property> </configuration>

7.5 修改mapred-site.xml文件(命令:vi mapred-site.xml) 7.5.1复制模板文件(命令:cp mapred-site.xml.template mapred-site.xml) 7.5.2编辑文件 <configuration> <!--指定MapReduce运行时的框架,这里指定在YARN上,默认在local--> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

7.6 修改yarn-site.xml文件(命令:vi yarn-site.xml) <configuration> <!--指定YARN集群的管理者(ResourceManager)的地址--> <property> <name>yarn.resourcemanager.hostname</name> <value>hadoop01</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration> | |

| 7.7修改slaves文件

7.8将主节点中配置好的文件和hadoop目录copy给子节点 #tip:这里主节点为yangjian00,子节点为yangjian01、yangjian02、yangjian03 scp /etc/profile yangjian01:/etc/profile scp /etc/profile yangjian02:/etc/profile scp /etc/profile yangjian03:/etc/profile scp -r /export/ yangjian01:/ scp -r /export/ yangjian02:/ scp -r /export/ yangjian03:/ 7.9使所有子节点的配置文件

7.10 在主节点格式化文件系统(successfully formatted 格式化成功)

八、Hadoop集群测试 1.启动集群服务 1.1在主节点启动所有HDFS服务进程(命令:start-dfs.sh) 1.2在主节点启动所有HDFS服务进程(命令:start-yarn.sh) 2.打开window下的C:\Windows\System32\drivers\etc打开hosts文件,在文件末添加三行代码: 192.168.220.20 yangjian00 192.168.220.21 yangjian01 192.168.220.22 yangjian02 192.168.220.23 yangjian03 3.通过UI界面查看Hadoop运行状态,在Windows系统下,访问http://hadoop01:50070,查看HDFS集群状态

| |

到了这里,关于Hadoop系统应用之安装---Hadoop集群安装配置和详细搭建过程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

文章来源:https://www.toymoban.com/news/detail-738508.html

文章来源:https://www.toymoban.com/news/detail-738508.html