前言

在人工智能技术的迅猛发展下,内容生成领域也迎来了一系列创新的突破。其中,使用扩散模型(如Stable Diffusion)从文字生成图片的AI技术备受瞩目。这一技术的出现,为我们创造栩栩如生的图像提供了全新的可能性。本文将带领读者使用免费云Colabt体验如何使用扩散模型生成图片。

前提

本文使用免费云,只要求读者拥有浏览器即可。

步骤

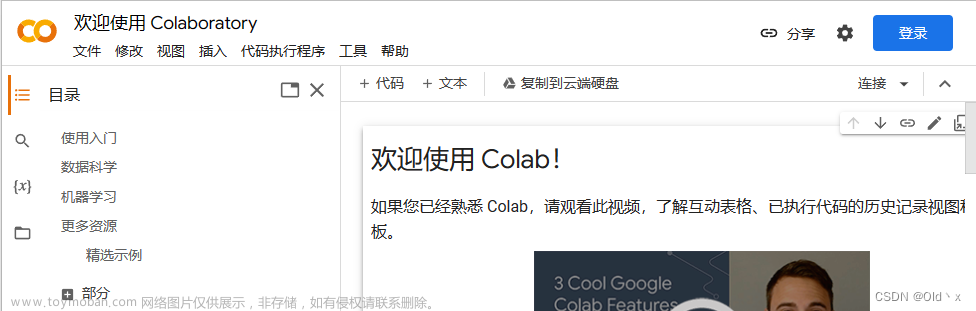

- 使用浏览器打开Colab的网页:https://colab.google/, 登录后,打开一个心得Notebook。

- 设置运行时为GPU(为了快速执行), 菜单栏->修改->笔记本设置。

- 安装使用的库。由于使用到了diffusion, 因此这里需要安装HuggingFace的diffusers, 和transformers库。

!pip install transformers diffusers

第一次执行可能需要点时间,因为Colab需要为我们初始化环境,然后才能执行安装。

4. 依赖安装后,就可以载入训练好的模型,并生成我们的图片了。文章来源:https://www.toymoban.com/news/detail-789726.html

from diffusers import AutoPipelineForText2Image # 导入pipeline

import torch # 导入pytorch,一个及其学习库

pipeline = AutoPipelineForText2Image.from_pretrained(

"kandinsky-community/kandinsky-2-2-decoder", torch_dtype=torch.float16

).to("cuda") # 导入公开的模型checkpoints

generator = torch.Generator("cuda").manual_seed(31) # 初始化生成器

image = pipeline("Astronaut in a jungle, cold color palette, muted colors, detailed, 8k", generator=generator).images[0] # 这里就是提示内容了,通过提示来控制我们生成的图形。

image # 展示图形。

执行过程可能需要几分钟,这个根据自己选择的模型有关,不同模型大小区别还是挺大的,比如上面的示例,可能看到执行过程中有多个几G的参数文件需要加载。 这里就是生成的图片。(图片通过扩散模型kandinsky生成)

这里就是生成的图片。(图片通过扩散模型kandinsky生成)

结论,以上就是使用扩散模型生成图片的过程,在上面过程中,文中只是简单示例,但是有很多的公开模型可以供我们使用,另外使用时也有众多的参数供我们灵活配置。文章来源地址https://www.toymoban.com/news/detail-789726.html

到了这里,关于如何在免费云Colab上使用扩散模型生成图片?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文精读] 使用扩散模型生成真实感视频 - 【李飞飞团队新作,文生视频 新基准】](https://imgs.yssmx.com/Uploads/2024/02/772295-1.png)