AI 大模型的部署与优化-8.1 模型压缩与加速-8.1.2 量化与剪枝

作者:禅与计算机程序设计艺术

8.1 模型压缩与加速

8.1.1 背景介绍

随着深度学习技术的不断发展,人工智能模型的规模越来越庞大。然而,这也带来了新的问题:大模型需要更多的计算资源和存储空间,同时在移动设备上运行效率较低。因此,模型压缩与加速成为了当前研究的热点。

8.1.2 核心概念与联系

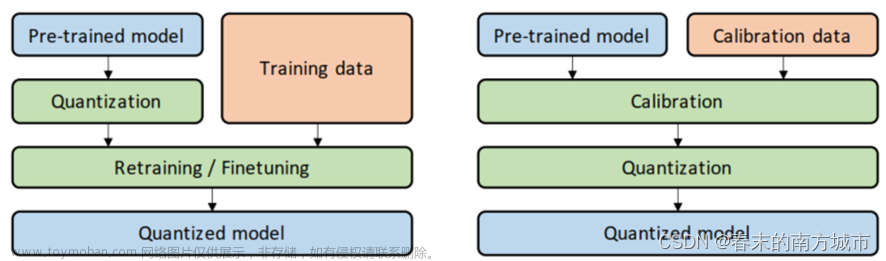

模型压缩通常包括以下几种技术:量化、剪枝、蒸馏和知识迁移。其中,量化和剪枝是最常用的两种技术。

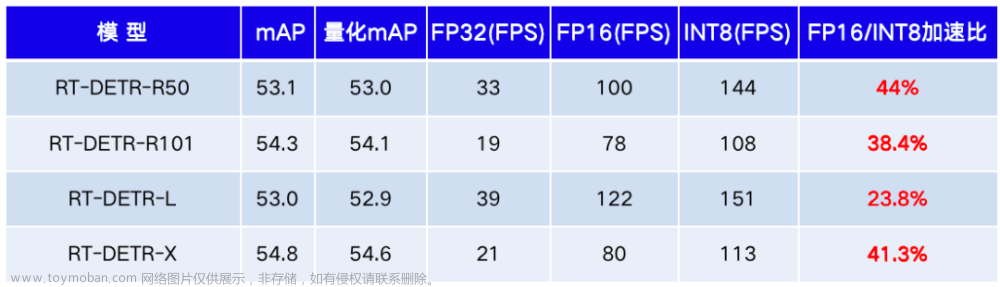

- 量化:将浮点数精度降低为整数精度,从而减小模型的存储空间。

- 剪枝:删除模型中无关紧要的权重或特征,从而减少模型的计算复杂度。

量化和剪枝技术通常结合起来使用,以获得更好的效果。

8.1.3 核心算法原理和具体操作步骤以及数学模型公式详细讲解

8.1.3.1 量化

量化是指将浮点数精度降低为整数精度,从而减小模型的存储空间。常见的量化方法包括线性量化和对数量化。

-

线性量化:将浮点数映射到离散整数集合上。具体操作如下:

$$q = \frac{r - z_{\min}}{z_{\max} - z_{\min}} \times (2^b - 1)$$文章来源:https://www.toymoban.com/news/detail-837362.html

其中,$r$ 表示输入浮点数,$z_{\m文章来源地址https://www.toymoban.com/news/detail-837362.html

到了这里,关于第八章:AI大模型的部署与优化8.1 模型压缩与加速8.1.2 量化与剪枝的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!