作者:萧炎 | 来源:3DCV

在公众号「3DCV」后台,回复「原论文」可获取论文pdf和代码链接

1、导读

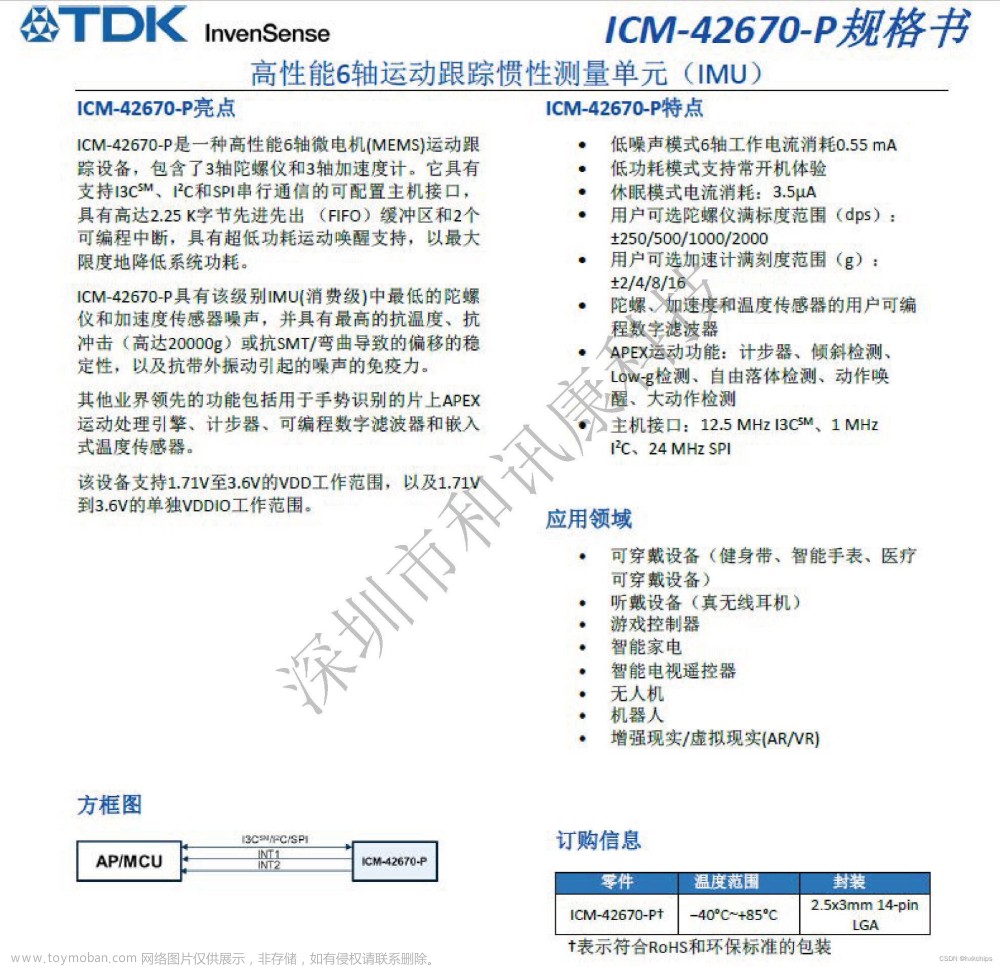

近年来,同步定位与建图(SLAM)技术在自动驾驶、智能机器人、增强现实(AR)、虚拟现实(VR)等领域得到广泛应用。使用最流行的三种类型传感器(例如视觉传感器、LiDAR传感器和 IMU)的多传感器融合在SLAM中变得无处不在,部分原因是互补的传感能力和不可避免的缺陷(例如低精度和长距离测量)。独立传感器在具有挑战性的环境中的术语漂移)。在本文中,我们全面调查了该领域的研究工作,并努力对相关工作提供简洁而完整的回顾。首先,简要介绍了SLAM中状态估计器的构成。其次,给出了不同多传感器融合算法的最新算法。然后我们分析与所审查的方法相关的缺陷并制定一些未来的研究考虑因素。本文可以认为是对新人的简要指南,也是经验丰富的研究人员和工程师探索新的有趣方向的综合参考。

2、状态估计器

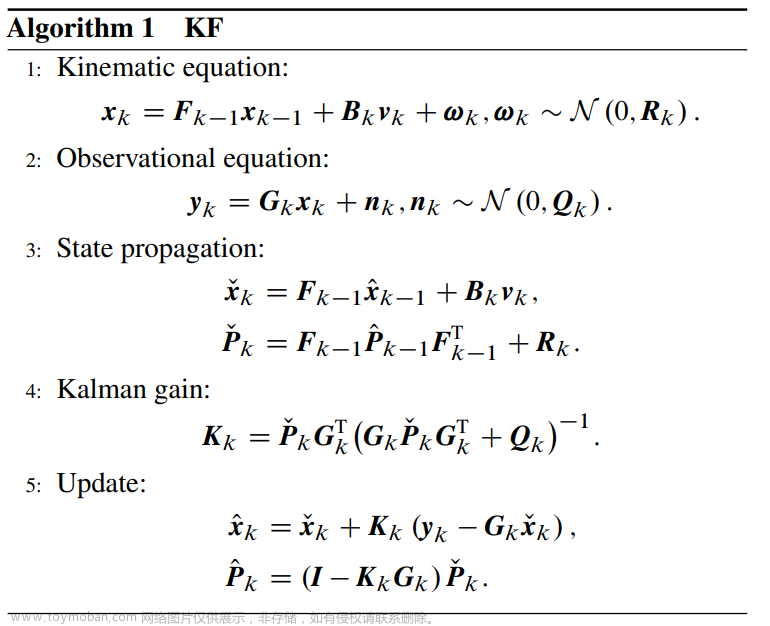

卡尔曼滤波器(KF)和滑动窗口优化是多传感器融合中最常用的状态估计器形式。在本节中,我们将对它们进行简要介绍。

2.1、KF

在SLAM中,先验值通常是从传感器(例如IMU和编码器)递归得出的。测量值通常从传感器获得,例如GPS、摄像头和激光雷达。后验值是融合结果,也是定位输出。在实际的机器人状态估计中,估计后验概率密度可以表示为:

2.2、算法1 KF

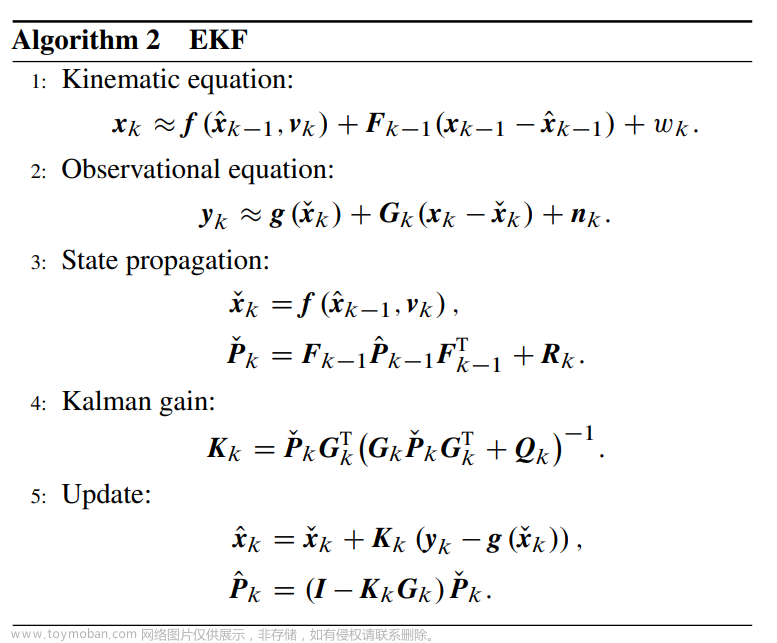

2.3、算法2 EKF

2.4、滑动窗口优化

滑动窗口优化对滑动窗口内的所有状态进行优化,由于其计算成本有限且精度相对足够的优点,已广泛应用于多传感器融合算法中。

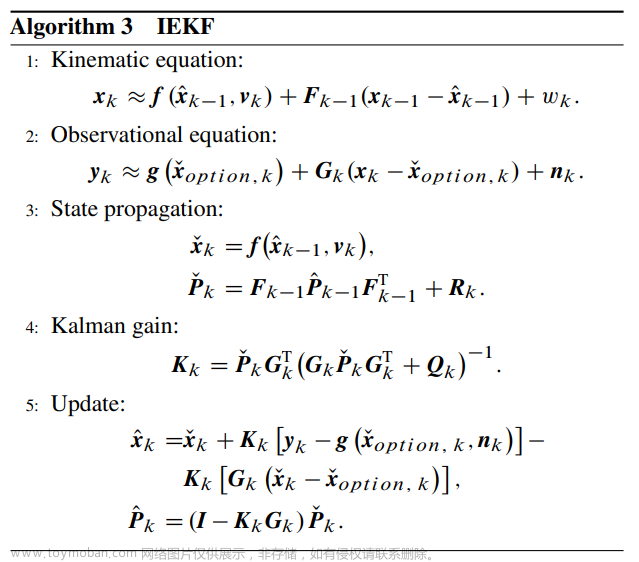

2.5、算法3 IEKF

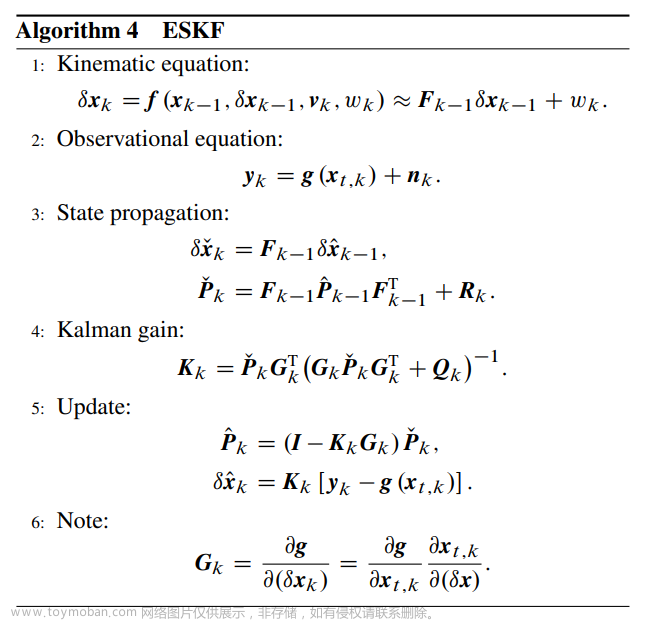

2.6、算法4 ESKF

3、多传感器融合算法

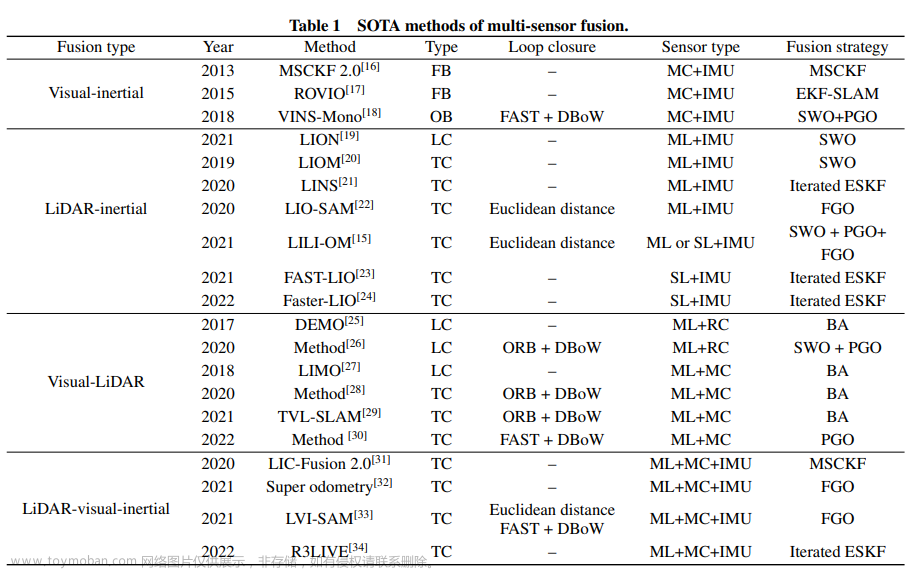

我们主要考虑三种传感器:单目相机、LiDAR和IMU。首先,我们将多传感器融合算法分为四类,即视觉-惯性、激光雷达-惯性、视觉-激光雷达、激光雷达-视觉-惯性融合算法。然后,我们详细描述了每个类别的最先进(SOTA)方法。每个类别的代表性方法如表1所示。

3.1 视觉惯性融合算法

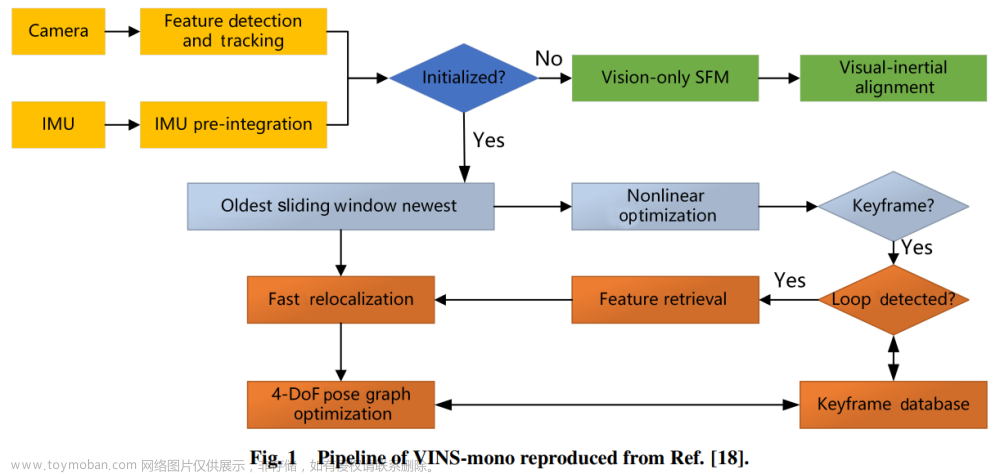

在导航系统中,我们想要估计传感平台的六个自由度(DOF)位姿(方向和位置)。IMU因其体积小、重量轻、成本低而被广泛应用于导航系统,最重要的是,能够测量其以高频刚性连接的传感平台的三轴角速度和线性加速度。然而,仅使用IMU的导航系统会因IMU测量与偏差和噪声的集成而产生无界误差,并且无法为长期导航提供可靠的位姿估计。需要额外的传感器来克服这个问题。小型轻量的单目相机可以提供良好的跟踪能力和有关传感平台周围环境的丰富地图信息,可以作为 IMU 的理想补充传感器之一。IMU 和相机的融合产生了视觉惯性导航系统(VINS),该系统在过去二十年中引起了极大的关注。一般来说,VINS算法根据数据融合的类型可以分为基于优化的方法和基于过滤的方法。

3.2 激光雷达-惯性融合算法

近年来,人们越来越关注激光雷达惯性融合算法,因为IMU测量高频瞬时运动,可用于从高动态运动失真中恢复点云并预测两个激光雷达帧之间的相对位姿。根据传感器融合类型,激光雷达惯性融合算法可以分为松耦合方法和紧耦合方法。松耦合方法注重运行时间,分别考虑LiDAR的估计和IMU的估计,导致信息丢失和估计不准确。而紧耦合方法则旨在准确估计,将点云和 IMU 测量融合在基于优化或基于过滤的框架中,计算成本较高。本部分将介绍两种融合类型的当前最先进的方法。

3.3 视觉-激光雷达融合算法

视觉传感器,例如单目相机,通常很便宜,并且视觉特征的提取可以实现闭环检测。然而,基于视觉的导航系统对光照变化和纹理缺陷很敏感。LiDAR作为一种主动传感器,对不断变化的环境表现出更好的准确性和鲁棒性,但即使存在丰富的纹理信息,也会遇到长走廊等无结构场景。由于这两类传感器的优势互补,已经提出了一些工作,这些工作可以分为两类:松耦合方法和紧耦合方法。有些工作侧重于前端集成,有些工作则关注后端优化,下面将对其进行详细讨论。

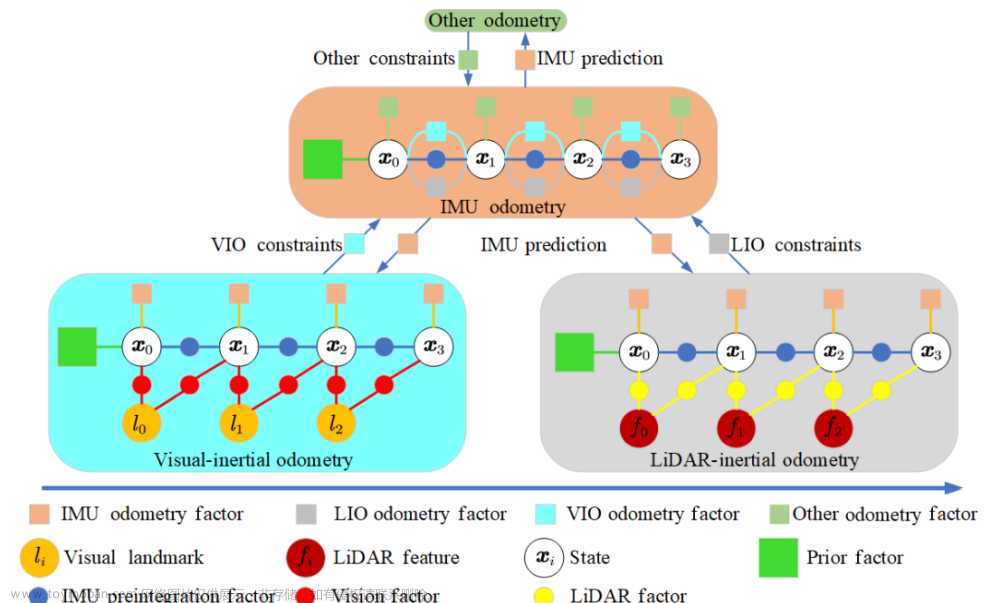

3.4 激光雷达-视觉-惯性融合算法

仅使用激光雷达的方法很容易受到退化几何形状的环境的影响,例如长隧道或开阔的空间。IMU 测量可能是对仅LiDAR方法的极好补充,但是它们只能在几秒钟内提供可靠的姿态估计。因此,激光雷达惯性方法也会遇到简并情况,特别是对于FOV较小的固态激光雷达。为了解决这些问题,与其他传感器,特别是提供丰富视觉信息的相机的融合是必要的,并且已经受到越来越多的关注。为了保持一致性,我们还将激光雷达视觉惯性方法分为上述两类。

4、未来研究方向

根据综述,我们提出了一些未来的研究方向:

-

多功能、高效的融合框架:当前最先进的算法通常是针对特定平台设计的,这使得它们很难部署在具有类似传感器的其他平台上。自动传感器到传感器校准至关重要,应保证准确的初始化,特别是对于配备视觉传感器的平台。此外,应利用有效的数据关联来确保实时性能。

-

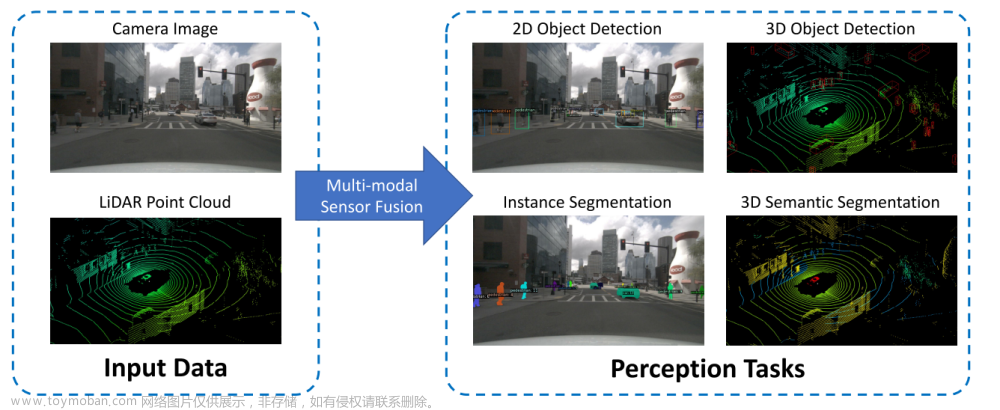

深度学习辅助方法:利用深度学习是多传感器融合框架中不断发展的领域,可用于特征提取、运动物体检测、环境呈现等。

-

分布式协作方法:对于同一SLAM 任务,不同的机器人配备不同的传感器将显着减轻单个机器人的负担,但这是一个相当具有挑战性的问题,而且相关文献很少。文章来源:https://www.toymoban.com/news/detail-843565.html

5、结论

近年来,多传感器融合技术在机器人领域受到越来越多的关注。本研究简要介绍了著名的状态估计形成方法,并对近十年来的多传感器融合方法进行了总结。我们首先根据传感器的组合将多传感器融合算法分为四类,然后根据数据融合进行分类。介绍了每种方法中最具代表性的技术。此外,还讨论了挑战和未来的研究方向,以使该技术具有通用性、稳健性和实质性。文章来源地址https://www.toymoban.com/news/detail-843565.html

到了这里,关于最新综述!基于相机、LiDAR和IMU的多传感器融合SLAM的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]BEVFusion——基于统一BEV特征的多任务多传感器融合](https://imgs.yssmx.com/Uploads/2024/02/734468-1.png)