最近的一项调查显示,74%的IT决策者对与大型语言模型(LLM)相关的网络安全风险表示担忧,特别是其传播误导信息的潜力。

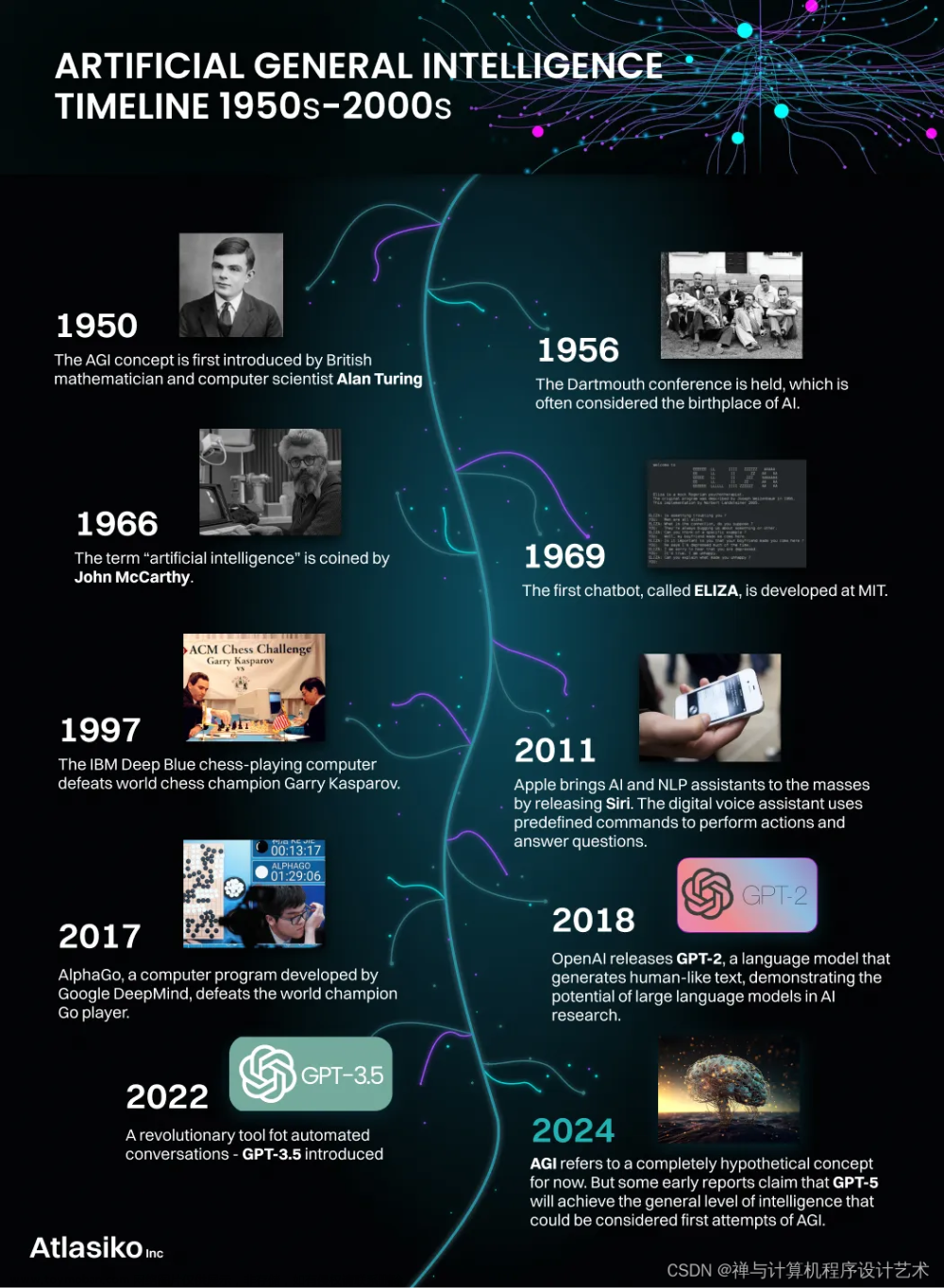

人工智能(AI)领域正因生成式AI及其热门子领域——大型语言模型(LLM)而蓬勃发展。

LLM已成为一个强大的工具,可以执行许多令人印象深刻的任务,如编码、撰写完美的内容、生成高质量图像等。然而,随着它们的功能迅速扩展,安全问题变得尤为重要。

早在2023年5月,三星采取了重要措施,禁止员工在公司设备上使用GPT和类似的AI工具,原因是存在安全漏洞,导致机密信息泄露给了语言模型。这一事件只是对组织可能遭受的损害的一个例子。

那么,企业如何在安全和利用LLM潜力之间取得平衡呢?让我们深入探讨LLM安全问题以寻找答案!

LLM的安全问题

尽管生成式LLM的应用潜力广泛且令人兴奋,但它们也带来了相应的安全风险。让我们深入研究一些最紧迫的问题:

产生可能的错误信息 众所周知,LLM可以使用其训练数据集生成类似人类的文本。但是,如果数据集本身被错误信息污染了,模型将继续传递这些错误信息。此外,LLM流畅地呈现信息使用户更难以区分事实与不准确的结果。

这可能会导致重大的现实问题,特别是当这些不准确的数据在大平台上传播,影响到广大观众。这里还出现了另一个问题,由于训练数据量巨大,人工事实核查员很难进行筛查。

偏见和道德问题 LLM的训练数据集还有一个重要缺陷。请考虑这样一种情况:该模型是在成千上万个网页的基础上进行训练的,几乎不可能确定长列表中是否包含任何偏见或仇恨言论。很自然地,LLM将吸收它们,并生成反映或放大现有刻板印象、偏见或歧视观点的内容,引发道德问题。

机密信息泄露 使用过像GPT 3.5之类的LLM的人都知道,当你向它提问时,会得到一个答案,以及一个大拇指向上或向下的反馈选项。这有助于模型学习哪些信息是相关或无关的。因此,LLM能够根据用户的交互进行有效的调整和改进。类似三星的案例中提到的情况,当员工或个人使用敏感信息与LLM对话时,模型很可能会将其存储在数据库中。此外,模型可能会生成意外地将这些敏感数据暴露给他人的文本。

防止LLM安全问题

虽然利用LLM会有一些普遍存在的安全问题,但采取预防措施可以帮助您走得更远。以下是几个应该遵守的事项,以安全地从LLM的强大功能中受益。

遵守道德使用准则 预防LLM中的安全问题的第一步是建立负责任使用的准则,并明确道德和法律边界。组织和个人必须远离生成有害内容、传播错误信息或侵犯隐私权等不当用途。负责任的使用包括检查输出是否存在不正确或有害的回答。清晰的规则和原则有助于用户、开发者和组织在使用LLM时理解自己的责任,促进道德和安全使用。

缓解偏见 缓解偏见是防止与LLM相关的安全问题的重要步骤。由于LLM通常会从训练数据中继承偏见,建议使用去偏算法和多样化的数据集整理技术来减少LLM回答中的偏见。对潜在偏见的持续改进和意识非常重要,以确保LLM提供公正和平等的信息。此外,在披露用于减少偏见的方法时透明度也是至关重要的,以维护对LLM输出的信任。

定期审核和监控 定期审核和监控LLM对于控制和预防安全问题至关重要。这包括持续评估LLM的输出是否符合负责使用准则、道德标准和法律要求。审核应包括偏见评估和有害内容的识别。此外,可以利用自动化工具、人工审核员和用户反馈来检测和及时处理问题。定期评估有助于维持LLM的质量和安全,确保其与不断发展的社会规范和价值观相一致。

人工审查 引入人工审查过程是确保LLM安全的另一个关键步骤。通过涉及人类专家来增强安全性,他们能够识别和纠正错误、减轻偏见、审核不当内容、确保合法和道德合规性、处理上下文细微差异并实时调整。这种人为监督增加了一层安全性,防止虚假或有害信息的传播

数据保护和隐私措施 保护数据的安全和隐私对于防止LLM安全问题至关重要。组织和个人应采取适当的数据加密、访问控制和身份验证措施来防止未经授权的访问和数据泄露。此外,必须遵守相关的数据保护法规,如GDPR(通用数据保护条例),以确保个人信息的合法收集、使用和存储。

持续更新和改进 LLM技术正处于快速发展和改进阶段,因此持续更新和改进是确保安全性的关键。开发者和研究人员应与学术界和行业专家保持沟通,及时了解新的安全风险和解决方案。同时,用户和组织也应保持警惕,并在使用LLM时采取最新的安全措施。

结论

虽然大型语言模型(LLM)具有强大的功能和潜力,但与之相关的安全风险不能被忽视。了解并解决这些安全问题对于企业和个人利用LLM的潜力至关重要。

通过遵守道德准则,缓解偏见,定期审核和监控,引入人工审查,实施数据保护措施以及持续更新和改进,可以最大程度地减少LLM的安全风险。文章来源:https://www.toymoban.com/diary/system/671.html

在利用LLM的同时,我们必须始终关注道德、法律和隐私的重要性,并确保其在正确的框架内使用。只有这样,我们才能充分利用LLM的潜力,同时确保信息安全和社会责任的平衡文章来源地址https://www.toymoban.com/diary/system/671.html

到此这篇关于探索大型语言模型的安全风险的文章就介绍到这了,更多相关内容可以在右上角搜索或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!