提示:个人学习所用,仅供参考

目录

前言

一、前提条件

二、安装Java1.8

1.使用wget将安装包下载到虚拟机中

2.将下载好的jdk安装包解压到local目录下

3.配置java环境变量

4.使环境变量生效:

5.测试java 是否安装成功:

6.如图即为安装成功:

7.将环境变量跟jdk安装包分发到子节点(此操作需要配置免密登录和本地主机名):

8.分发完之后使环境变量生效即可(每个节点都需要):

三、Hadoop3.1.3安装部署

1.将Hadoop安装包解压到local目录下

2.配置Hadoop环境变量

3.进入hadoop中的etc/hadoop目录下修改六个配置文件

1)workers添加两个子节点的主机名

2)输入vi core-stie.xml 添加以下内容:

3)输入vi hadoo-env.sh 添加以下内容:

4)输入vi mapred-site.xml,添加以下内容:

5)输入vi hdfs-site.xml 添加以下内容:

6)输入vi yarn-site.xml,添加以下内容:

4.将配置文件分发到子节点

5.将hadoop的配置文件修改完成后,在主节点上进行namenode格式化

6.到hadoop的bin目录下修改,在start-dfs.sh 和stop-dfs.sh添加以下内容

7.到hadoop的bin目录下修改,在start-yarn.sh 和 stop-yarn.sh添加以下内容

8.输入jps测试节点是否运行

总结

前言

本节文章讲述了如何安装Hadoop完全分布式部署,配置文件很多默认的端口并没有开放,可以自行去官网上参考配置文档进行配置

提示:以下是本篇文章正文内容,下面案例可供参考

一、前提条件

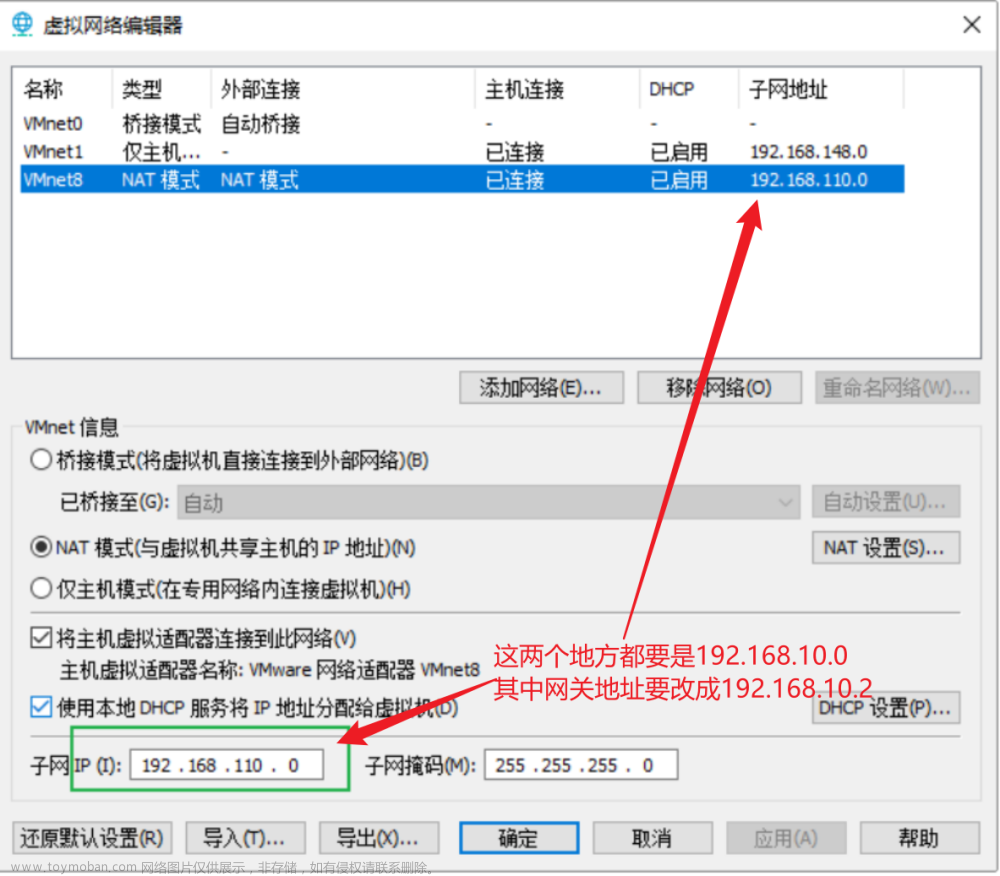

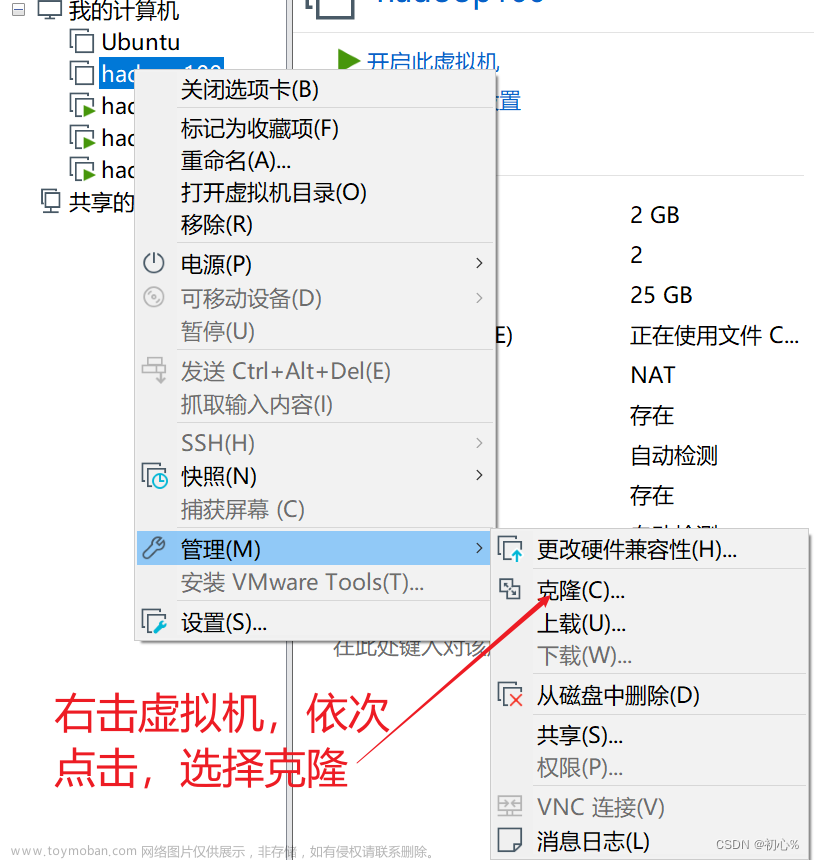

- 准备三台虚拟机:master、slave1、slave2,设置他们的静态ip分别为192.168.147.201、192.168.147.202、192.168.147.203.(可参考自己本地的虚拟机网段来设置)

| 主机名 | 静态ip |

| master | 192.168.147.201 |

| slave1 | 192.168.147.202 |

| slave2 | 192.168.147.203 |

二、安装Java1.8

1.使用wget将安装包下载到虚拟机中

使用命令如下(使用的是华为的镜像云网站,可自行修改其他镜像网站的安装包):

wget https://repo.huaweicloud.com/java/jdk/8u151-b12/jdk-8u151-linux-i586.tar.gz

2.将下载好的jdk安装包解压到local目录下

代码如下(解压完成之后可以将他重命名为java,方便配置环境变量):tar -zxvf jdk-8u151-linux-i586.tar.gz -C /usr/local

3.配置java环境变量

输入vi /etc/profile配置java环境变量,添加以下内容:

export JAVA_HOME=/usr/local/java

export PATH=$PATH:$JAVA_HOME/bin

4.使环境变量生效:

source /etc/profile

5.测试java 是否安装成功:

java -version

6.如图即为安装成功:

7.将环境变量跟jdk安装包分发到子节点(此操作需要配置免密登录和本地主机名):

scp -r /etc/profile slave1:/etc/ #分发环境变量

scp -r /etc/profile slave2:/etc/ #分发环境变量

scp -r /usr/local/java/ slave1:/usr/local/ #分发jdk安装包

scp -r /usr/local/java/ slave2:/usr/local/ #分发jdk安装包

8.分发完之后使环境变量生效即可(每个节点都需要):

source /etc/profile

三、Hadoop3.1.3安装部署

1.将Hadoop安装包解压到local目录下

tar -zxvf hadoop-3.1.3.tar.gz -C /usr/local/

2.配置Hadoop环境变量

| export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin export HADOOP_HOME=/usr/local/Hadoop |

3.进入hadoop中的etc/hadoop目录下修改六个配置文件

1)workers添加两个子节点的主机名

| slave1 slave2 |

2)输入vi core-stie.xml 添加以下内容:

| <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://master</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/usr/local/Hadoop/tmp</value> </property> </configuration> |

3)输入vi hadoo-env.sh 添加以下内容:

| export JAVA_HOME=/usr/local/java |

4)输入vi mapred-site.xml,添加以下内容:

| <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>yarn.app.mapreduce.am.env</name> <value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value> </property> <property> <name>mapreduce.map.env</name> <value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value> </property> <property> <name>mapreduce.reduce.env</name> <value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value> </property> </configuration> |

5)输入vi hdfs-site.xml 添加以下内容:

| <configuration> <property> <name>dfs.replication</name> <value>3</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/usr/local/hadoop/dfs/tmp/namenode</value> </property> <property> <name>dfs.datanode.dir</name> <value>/usr/local/hadoop/datanode</value> </property> </configuration> |

6)输入vi yarn-site.xml,添加以下内容:

| <configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.resourcemanager.hostname</name> <value>master</value> </property> </configuration> |

将Hadoop安装包分发到子节点

| scp -r /usr/local/hadoop/ slave1:/usr/local/ scp -r /usr/local/hadoop/ slave2:/usr/local/ |

4.将配置文件分发到子节点

| scp -r /etc/profile slave1:/etc/ scp -r /etc/profile slave2:/etc/ |

5.将hadoop的配置文件修改完成后,在主节点上进行namenode格式化

hdfs namenode -format

6.到hadoop的bin目录下修改,在start-dfs.sh 和stop-dfs.sh添加以下内容

| HDFS_DATANODE_USER=root HDFS_DATANODE_SECURE_USER=hdfs HDFS_NAMENODE_USER=root HDFS_SECONDARYNAMENODE_USER=root |

7.到hadoop的bin目录下修改,在 和 stop-yarn.sh添加以下内容

| YARN_RESOURCEMANAGER_USER=root HADOOP_SECURE_DN_USER=yarn YARN_NODEMANAGER_USER=root |

8.输入jps测试节点是否运行

文章来源:https://www.toymoban.com/news/detail-450842.html

文章来源:https://www.toymoban.com/news/detail-450842.html

总结

本章内容讲述了如何部署hadoop的基本步骤,前置条件需要靠自己完成,思路清晰,简单明了。文章来源地址https://www.toymoban.com/news/detail-450842.html

到了这里,关于Hadoop完全分布式部署3.1.3的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!