网页爬虫是一种自动化程序,可以自动地访问网页并提取其中的信息。它可以用于各种目的,例如搜索引擎的索引、数据挖掘、价格比较、舆情监测等。网页爬虫通常使用编程语言编写,例如Python、Java等。

以下是一个简单的示例,使用 Python 和 requests 库进行网页爬取:

import requests

url = 'http://www.example.com'

response = requests.get(url)

# 获取响应内容

content = response.text

# 获取响应状态码

status_code = response.status_code

# 获取请求头部信息

headers = response.headers

# 获取 cookies

cookies = response.cookies

# 输出结果

print(content)

在这个示例中,我们首先导入了 requests 库。然后指定目标网址 http://www.example.com,并使用 requests 库发起 GET 请求获取响应。随后,可以通过 response 对象获取响应内容、状态码、请求头部信息和 cookies 等信息,并进行处理或存储。最后,我们输出响应内容。

上另外一个代码

import requests

url = "https://www.example.com" # 指定要爬取的网页URL

response = requests.get(url) # 发送HTTP请求获取网页内容

if response.status_code == 200: # 判断请求是否成功

html = response.text # 获取网页HTML代码

print(html) # 输出网页HTML代码

else:

print("请求失败,状态码为:" + str(response.status_code))

学习python爬虫需要注意什么

学习Python爬虫需要注意以下几点:

1、确保你已经掌握了Python的基础语法和面向对象编程的基本概念。

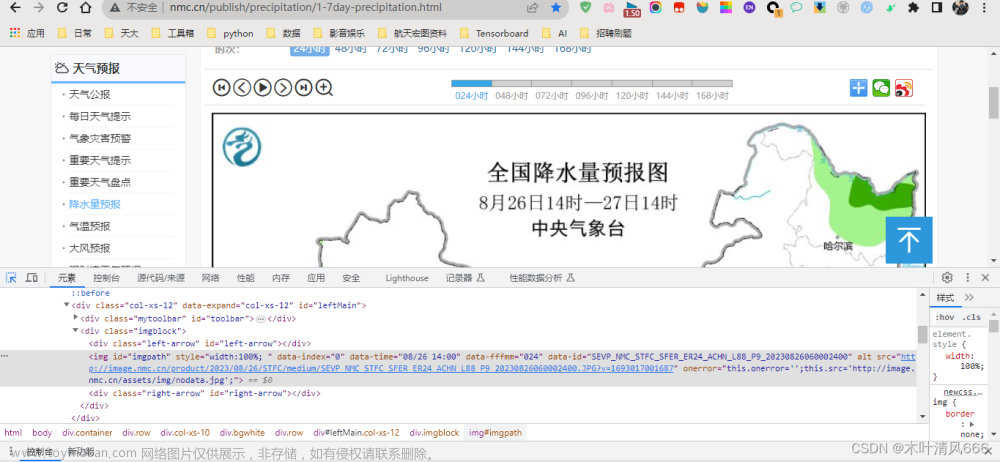

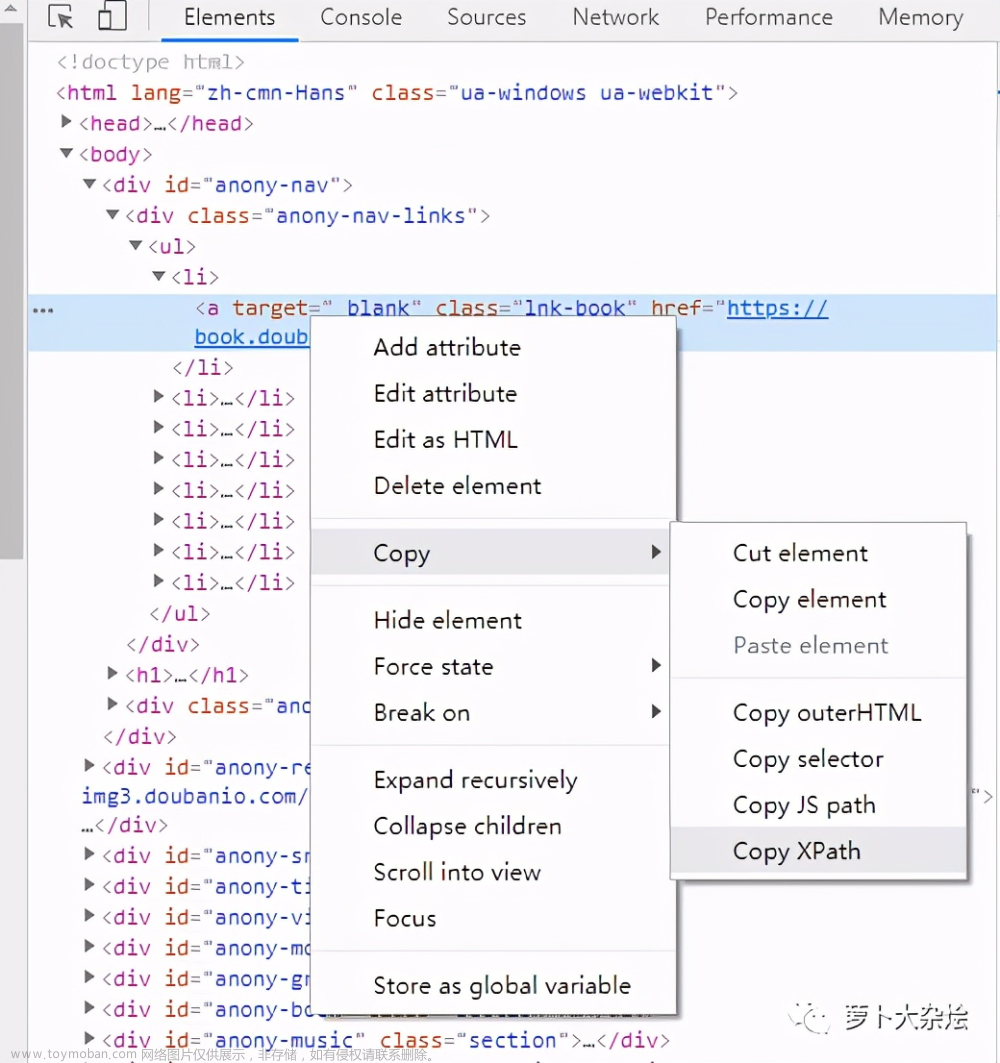

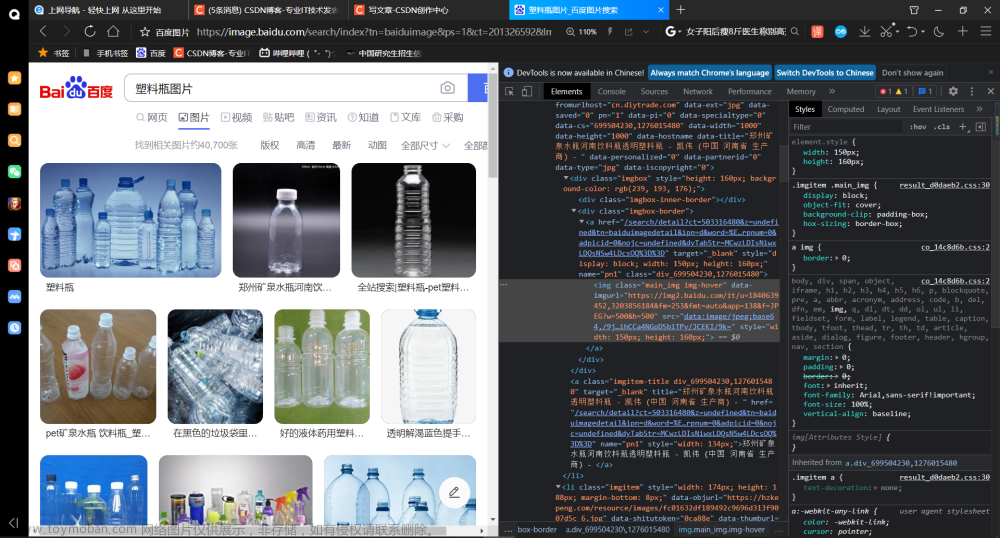

2、了解HTTP协议和HTML语言的基本知识,这是爬虫的基础。

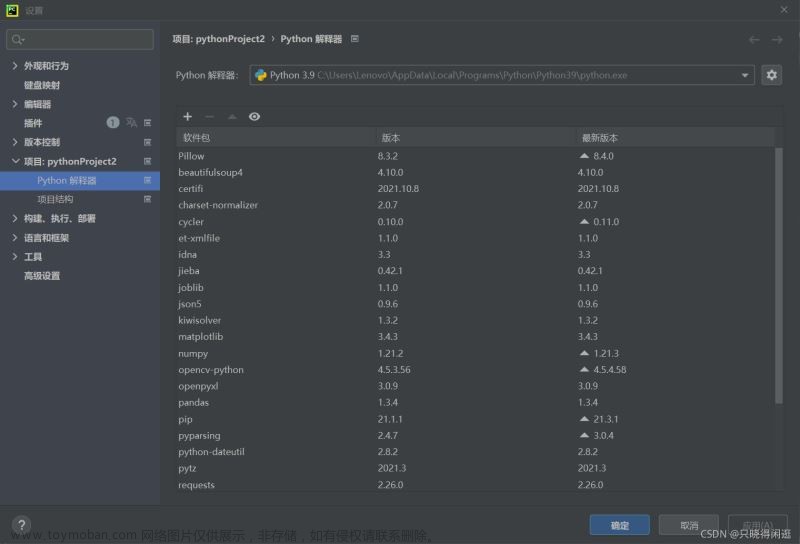

3、了解常见的爬虫框架和库,如Scrapy、BeautifulSoup、Requests等,选择一个适合自己的工具进行学习。

4、遵守网站的爬虫规则,不要过度频繁地访问同一个网站,以免被封IP或者被视为恶意攻击。

5、学会使用代理IP和User-Agent等技术,以避免被网站识别为爬虫。

6、学会数据清洗和数据存储,将爬取到的数据进行处理和保存。文章来源:https://www.toymoban.com/news/detail-613781.html

7、不要违反法律法规,不要爬取敏感信息或者侵犯他人隐私。文章来源地址https://www.toymoban.com/news/detail-613781.html

到了这里,关于Python网页爬虫代码的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[爬虫篇]Python爬虫之爬取网页音频_爬虫怎么下载已经找到的声频](https://imgs.yssmx.com/Uploads/2024/04/855397-1.png)