最近学习了scrapy爬虫框架,想要找个目标练练手。由于现在很多网页都是动态的,因此还需要配合selenium爬取。本文旨在记录这次学习经历,如有疑问或不当之处,可以在评论区指出,一起学习。

scrapy与selenium

对scrapy不了解的同学可以阅读这篇文章 爬虫框架 Scrapy 详解,对scrapy框架介绍的非常详尽。

Selenium简单来说就是一种用于测试Web应用程序的自动化工具。它可以模拟用户在浏览器中的各种操作,如点击、输入、选择、拖放等,以及对页面进行断言验证。在这里可以帮助我们获取到动态网页的数据。

准备工作

相关库以及chromedriver的安装

我们需要安装两个库,一个是selenium库,还有一个是scrapy库。

pip install selenium // 安装selenium库

pip install scrapy // 安装scrapy库

除此之外,还需要安装chromedriver.exe,如果电脑上没有谷歌浏览器就还需要安装谷歌浏览器。chromedriver.exe的安装可以看我的这篇文章python爬虫学习日志 使用selenium爬取动态网页数据

目标内容

获取某站目标视频的标题、播放量、发布日期、时长、点赞量、投币量、收藏量。

由于版权问题这里不能放出相应视频的图片,各位如有需要可以自行了解。

具体实现

准备工作完成之后就可以开始编写我们的代码啦~

创建项目

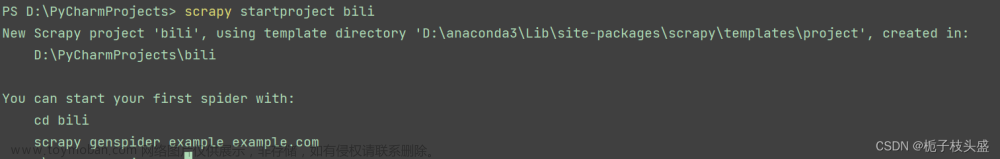

打开pycharm的终端或者cmd窗口,进入想要放置爬虫文件的目录,我这里是直接在pycharm的项目目录里创建的,然后输入以下命令

scrapy startproject bili //bili是自定义的爬虫项目名称

如果返回了以下信息,说明项目创建成功了。

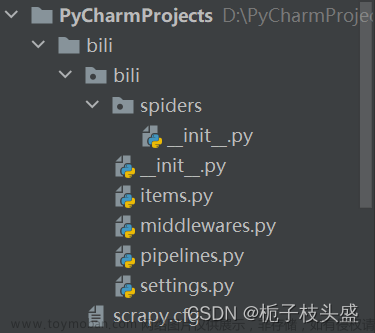

然后我们就可以在pycharm左侧的文件栏看到我们创建的爬虫项目里的文件了。

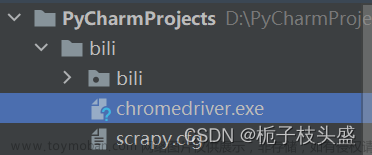

创建之后,我们需要把下载的chromedriver.exe文件移至和scrapy.cfg同目录下,如图所示。

编写items.py文件

items.py文件是用来定义我们需要爬取的数据的,首先编辑它可以帮我们完成数据建模,之后按照items.py中的变量来匹配我们的数据就行了。

import scrapy

class BiliItem(scrapy.Item):

// define the fields for your item here like:

// name = scrapy.Field()

// 这是scrapy提供给我们建模的格式,按照这个来就行

title = scrapy.Field() //视频标题

play = scrapy.Field() // 播放量

dianzan = scrapy.Field() //点赞量

toubi = scrapy.Field() //投币量

shoucang = scrapy.Field() //收藏量

date = scrapy.Field() //发布日期

time = scrapy.Field() //视频时长

这样一来,我们的items.py就文件就算编写完成了。

编写middlewares.py文件

接下来编写middlewares.py文件,也就是中间件。

中间件包括两种中间件,一种是爬虫中间件,还有一种是下载器中间件,每种中间件都有自己对应的功能,这里不再展开讲,想要了解的同学可以自己去查找相关信息。在这次实战中我们只需要通过编写下载器中间件对接selenium实现获取动态网页的源码这一功能。

代码如下:

from scrapy import signals

from selenium import webdriver

from scrapy.http import HtmlResponse

// 只需要修改下载器中间件,爬虫中间件不用管

class BiliDownloaderMiddleware:

// 当下载器中间件开始工作时,自动打开一个浏览器

def __init__(self):

self.driver = webdriver.Chrome()

@classmethod

def from_crawler(cls, crawler):

# This method is used by Scrapy to create your spiders.

s = cls()

crawler.signals.connect(s.spider_opened, signal=signals.spider_opened)

// 下面这一行需要手动添加,作用是调用关闭浏览器的函数

crawler.signals.connect(s.spider_closed, signal=signals.spider_closed)

return s

// 每当爬虫文件向目标网址发送一次请求都会调用这个函数,用处就是返回该网址的源码

def process_request(self, request, spider):

self.driver.get(request.url) // 使用浏览器打开请求的URL

body = self.driver.page_source // 获取网页HTML源码

return HtmlResponse(url=self.driver.current_url, body=body, encoding='utf-8', request=request)

def process_response(self, request, response, spider):

return response

def process_exception(self, request, exception, spider):

pass

def spider_opened(self, spider):

spider.logger.info("Spider opened: %s" % spider.name)

// 该函数需要手动添加,作用是关闭浏览器

def spider_closed(self, spider):

self.driver.close()

spider.logger.info("Spider closed: %s" % spider.name)

编写爬虫文件

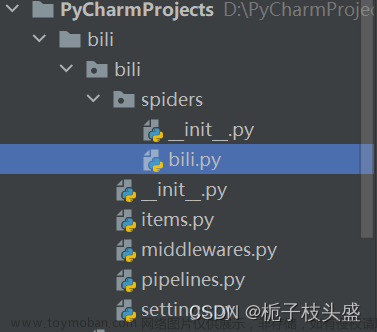

完成了中间件的编写之后就可以开始编写我们的爬虫文件了。爬虫文件需要我们手动创建。具体流程是在spiders目录下新建一个.py文件,文件名可以自拟。

创建之后,就可以编写爬虫文件了。代码如下

// 使用哪种解析库可以根据自己的习惯选择,只要能获得目标数据就行

import scrapy

from bs4 import BeautifulSoup

// 这里需要导入之前编写的items.py文件中的BiliItem类,[..]表示上一目录

from ..items import BiliItem

import re

from lxml import etree

class bilibili(scrapy.Spider): // 类名自拟,但是一定要在括号里写scrapy.Spider表示继承父类

name = 'bilibili' // 爬虫名,自拟

allowed_domains = ['space.bilibili.com'] // 定义域名,相当于是给爬虫规定了爬取的范围

start_urls = ['https://space.bilibili.com/1629347259/video'] // 定义开始爬取的网页

page = 1 // 如果想要爬取多页数据,需要定义爬取初始的页数,这里是1

// 后续页数的网址,需要自己观察翻页后网址的变化得出规律

base_url = 'https://space.bilibili.com/1629347259/video?tid=0&page={}'

// 重写父类方法,解析相应网页

def parse(self, response, **kwargs):

// 这里的response是下载器中间件返回给爬虫的网页源码,对此进行解析即可获得想要的数据

// 以下内容都是根据相应的网页源码选择合适的方法进行数据的提取,可以根据自己的需求编写。

bs = BeautifulSoup(response.text, 'lxml')

// tag_list是一个包括了很多个tag标签的列表,每个tag标签中都有视频的网址、标题、时长等数据

tag_list = bs.select('#submit-video-list > ul.clearfix.cube-list > li')

// 遍历取出每个tag标签

for index, j in enumerate(tag_list):

// 创建一个item实例,用于存储相应数据,它类似于字典

item = BilibiliItem()

// 获得网址,但这个网址不完整

video_url = j.a['href']

// 获得视频标题文本

video_title = j.find('a', class_='title').text

// 获得视频时长文本

video_time = j.find('span', class_="length").text

// 使用正则表达式把获得到的不完整的网址修改为正确的网址,之后可以进入这些网址再获取其他数据

pattern = r'//'

video_url = re.sub(pattern, 'https://', video_url)

// 将标题和时长以键值对的形式写进item实例中。

item['title'] = video_title

item['time'] = video_time

// 这里需要用yield将相应数据提交给引擎,由引擎分配后续工作

// url=video_url表示会将视频的网址提交给引擎,引擎会把这个网址转交给中间件,中间件又会将相应源码提供给爬虫文件

// callback表示获取到相应源码后会将它交给爬虫文件中哪个函数进行处理

// meta={'item': item}的作用是把目前的item实例转移给下一个函数使用或编辑。

// dont_fillter=True表示不过滤重复的请求。

yield scrapy.Request(url=video_url, callback=self.parse_detail, meta={'item': item}, dont_filter=True)

// 如果需要爬多页数据可以编写这一串代码,具体多少页可以根据自己的需求来

if self.page <= 3:

self.page += 1

new_url = self.base_url.format(self.page)

yield scrapy.Request(url=new_url, callback=self.parse)

// 这里是定义对视频网址信息的获取的函数,思路与parse()函数类似

def parse_detail(self, response):

html = etree.HTML(response.text)

play = html.xpath('//*[@id="viewbox_report"]/div/div/span[1]/text()')

date = html.xpath('//*[@id="viewbox_report"]/div/div/span[3]/span/span/text()')

dianzan = html.xpath('//*[@id="arc_toolbar_report"]/div[1]/span[1]/span/text()')

toubi = html.xpath('//*[@id="arc_toolbar_report"]/div[1]/span[2]/span/text()')

shoucang = html.xpath('//*[@id="arc_toolbar_report"]/div[1]/span[3]/span/text()')

item = response.meta['item']

item['play'] = play[0].strip()

item['date'] = date[0].strip()

item['dianzan'] = dianzan[0].strip()

item['toubi'] = toubi[0].strip()

item['shoucang'] = shoucang[0].strip()

// 所有数据都写入item实例后就可以向引擎提交了,每个item包括了一个视频的相关数据,之后引擎会把item交给pipeline处理。

yield item

编写pipelines.py文件

爬虫文件的作用是将爬取到的数据暂时保存在内存中,如果想要将数据保存至本地或者数据库中就需要通过编写pipelines.py文件来实现了。

这里我选择的是保存为excel文件,需要用到openyxl库,代码如下:

import openpyxl

class BiliPipeline:

def __init__(self):

print('开始写入')

self.wb = openpyxl.Workbook()

self.ws = self.wb.active # 获取活动表

self.ws.append(['视频标题', '视频播放量', '视频点赞量', '视频投币量', '视频收藏量', '视频发布日期', '视频时长']) # 添加表头

def process_item(self, item, spider):

print(f'正在保存:{item["title"]}')

line = [item['title'], item['play'], item['dianzan'], item['toubi'], item['shoucang'], item['date'], item['time']]

self.ws.append(line)

return item

def close_spider(self, spider):

self.wb.save('video.xlsx')

self.wb.close()

print('保存完毕')

编写setting.py文件

所有文件编写完成之后,我们还需要打开setting.py文件进行设置,确保所有功能能够正常进行。

以下是需要修改或取消注释的内容,没有写的默认即可。

// 不遵守robottxt协议,将True改为False

ROBOTSTXT_OBEY = False

// 在请求头中添加自己浏览器的UA信息

DEFAULT_REQUEST_HEADERS = {

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8",

"Accept-Language": "en",

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36 QIHU 360SE'

}

// 取消下载器中间件的注释

DOWNLOADER_MIDDLEWARES = {

"bili.middlewares.BiliDownloaderMiddleware": 543,

}

// 取消item_pipelines的注释

ITEM_PIPELINES = {

"bili.pipelines.BiliPipeline": 300,

}

// 设置一般日志不显示,只显示等级为警告以上的日志

LOG_LEVEL = "WARNING"

启动爬虫和查看数据

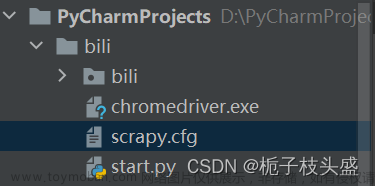

这样一来所有的代码都编写完成了,之后我们可以在爬虫项目的根目录下,通过pycharm新建一个start.py文件。

在该文件中,输入以下代码并执行:

from scrapy import cmdline

cmdline.execute('scrapy crawl bili'.split(' '))

也可以通过cmd窗口进入爬虫项目根目录下输入以下指令:

scrapy crawl bili

都可以启动我们的爬虫,启动完成之后等待爬虫程序自然关闭,就可以在根目录下看到我们爬取到的video.xlsx文件了。文章来源:https://www.toymoban.com/news/detail-469414.html

这样一来,本次的爬虫实战就圆满完成了。文章来源地址https://www.toymoban.com/news/detail-469414.html

到了这里,关于python爬虫实战 scrapy+selenium爬取动态网页的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!