大家好,我是python222小锋老师。

近日锋哥又卷了一波Python实战课程-批量爬取豆瓣电影排行信息,主要是巩固下Python爬虫基础

视频版教程:

Python爬虫实战-批量爬取豆瓣电影排行信息 视频教程_哔哩哔哩_bilibiliPython爬虫实战-批量爬取豆瓣电影排行信息 视频教程作者:小锋老师官网:www.python222.com, 视频播放量 344、弹幕量 0、点赞数 13、投硬币枚数 7、收藏人数 18、转发人数 0, 视频作者 java1234官方, 作者简介 公众号:java1234 微信:java9266,相关视频:Python爬虫实战-批量爬取下载网易云音乐,Python爬虫实战-批量爬取美女图片网下载图片 视频教程,这个视频可能会得罪很多人..终极爬虫JS逆向教程!突破反爬虫防御的终极指南,从入门到实战,就没有爬不了的网站!,【Python爬虫教程】你敢学我就敢发!300集从入门到入狱(完整版)胆小勿学!全程干货无废话,学完即可兼职接单!,2024 一天掌握python爬虫【基础篇】 涵盖 requests、beautifulsoup、selenium 【无废话版】,【Python爬虫】三分钟教你免费下载全网VIP音乐,音乐一键下载免费听,告别付费时代,小白也能学得会,附源码!,【Python爬虫】手把手教你爬取百度文库PPT文档,破解百度文库收费限制,下载PPT再也没花过钱!,【B站第一】清华大佬196小时讲完的Python入门学习教程!从小白到大神!整整300集,全干货无废话,学完即可就业!允许白嫖!!,【2023百度文库VIP文档PPT免费下载】Python白嫖百度文库付费VIP文档,破解百度文库收费限制,零基础白嫖教程!!!,【Python教程】一分钟轻松实现观影自由,教你用Python免费看电影,代码可分享 | Python爬虫教程https://www.bilibili.com/video/BV1aN411u7o5/

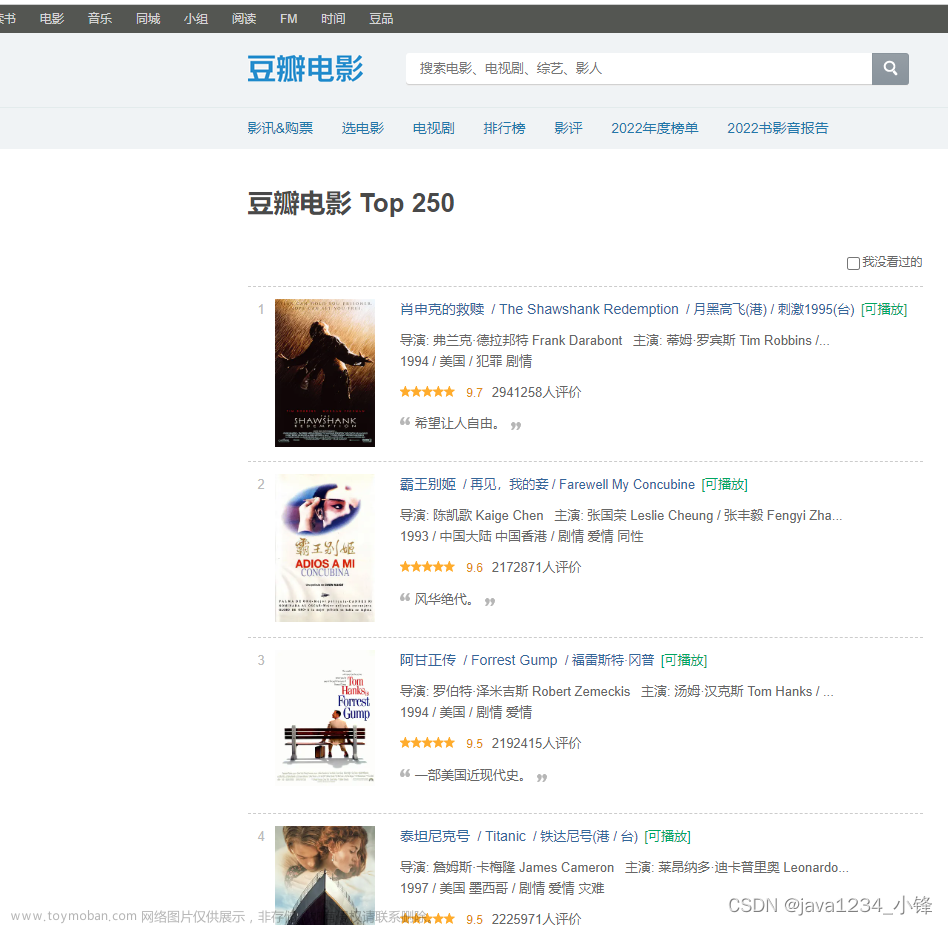

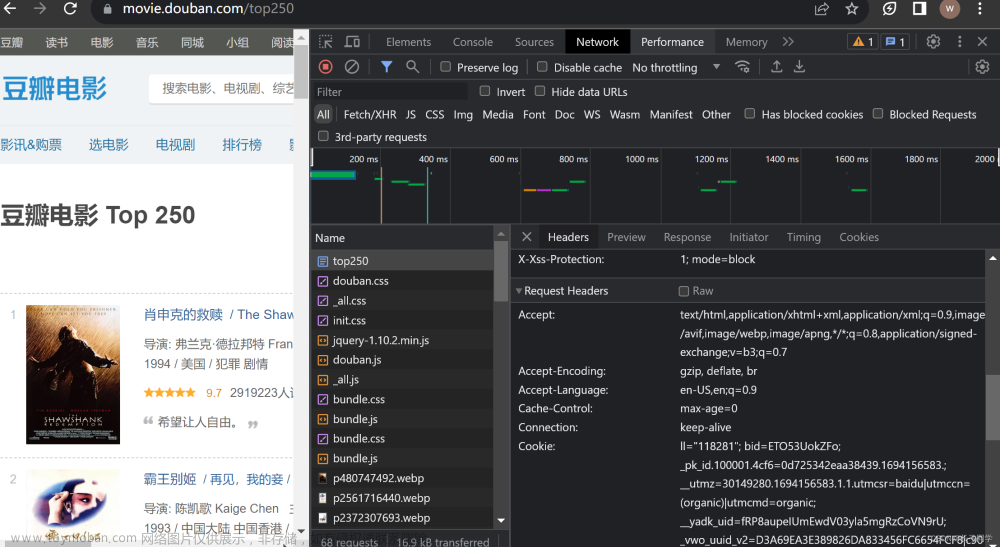

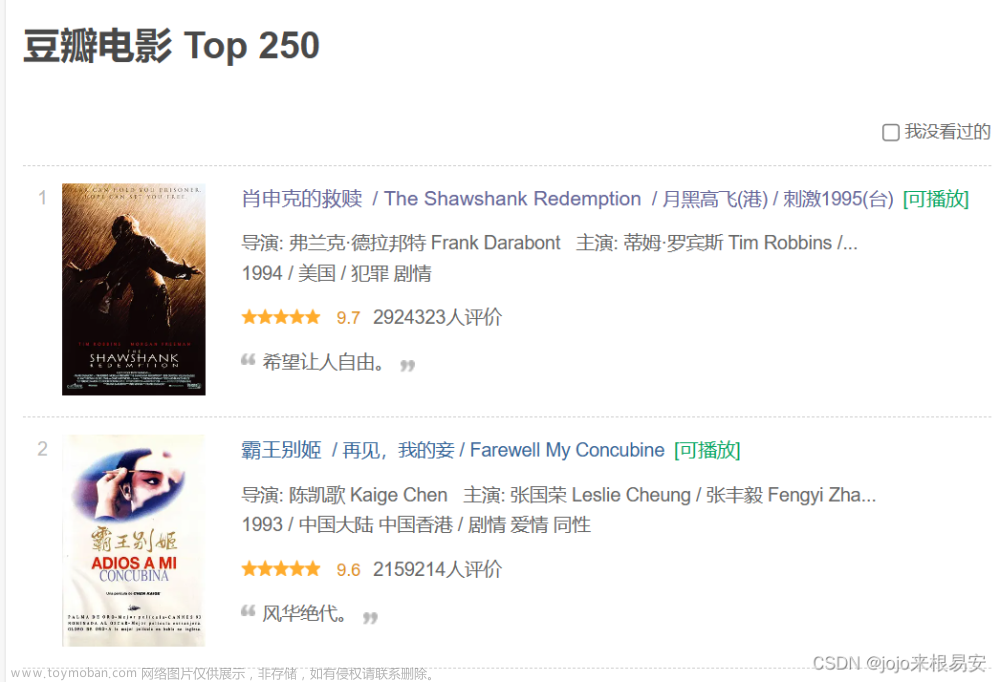

爬虫目标网站:

https://movie.douban.com/top250

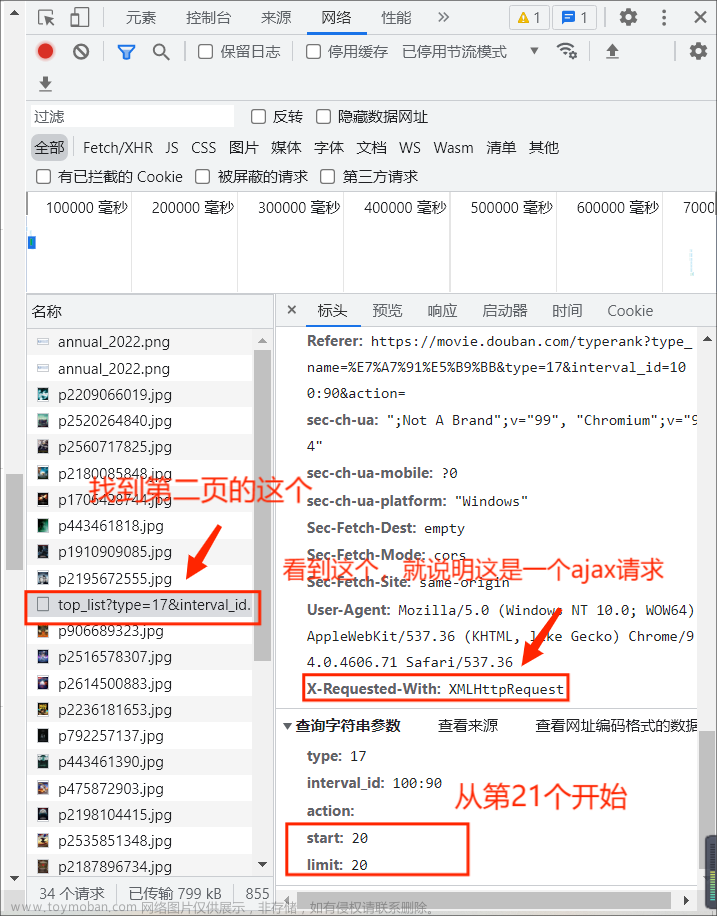

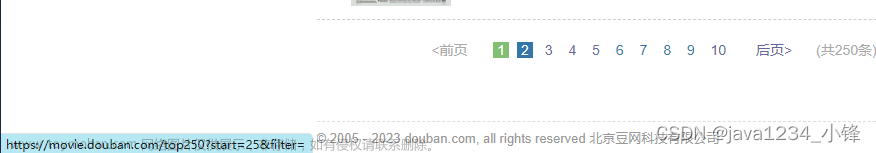

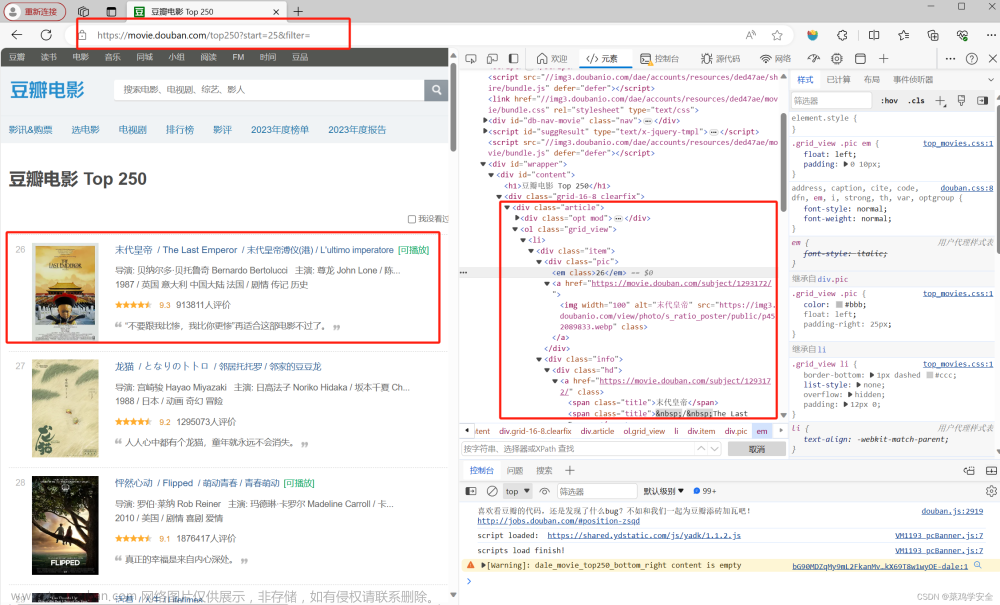

经过分析,一共10页,第二页,第二页,...,第10页的规律是:

分页规律 第N页

https://movie.douban.com/top250?start=25*(N-1)&filter=爬取网页,解析数据,处理数据,我们最终把数据存入Excel。

因为涉及到分页,所以我们要对解析url,解析网页,导出Excel代码,进行封装,方便复用。

解析请求,爬取网页方法:

def crawl_html(url):

"""

解析请求,爬取网页

:param url: 请求地址

:return: 网页源码

"""

response = requests.get(url=url, headers=headers)

return response.text解析网页源码方法:

def parse_html(html):

"""

解析网页源码

:param html: 页面源码

:return: 页面 电影对象信息列表 [ {'':''},{},{} ]

"""

# 实例化soup

soup = BeautifulSoup(html, "lxml")

# 获取所有电影DOM

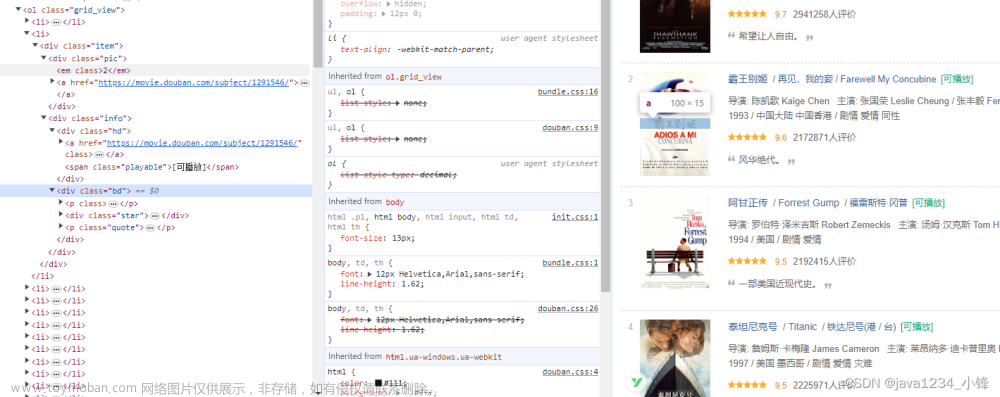

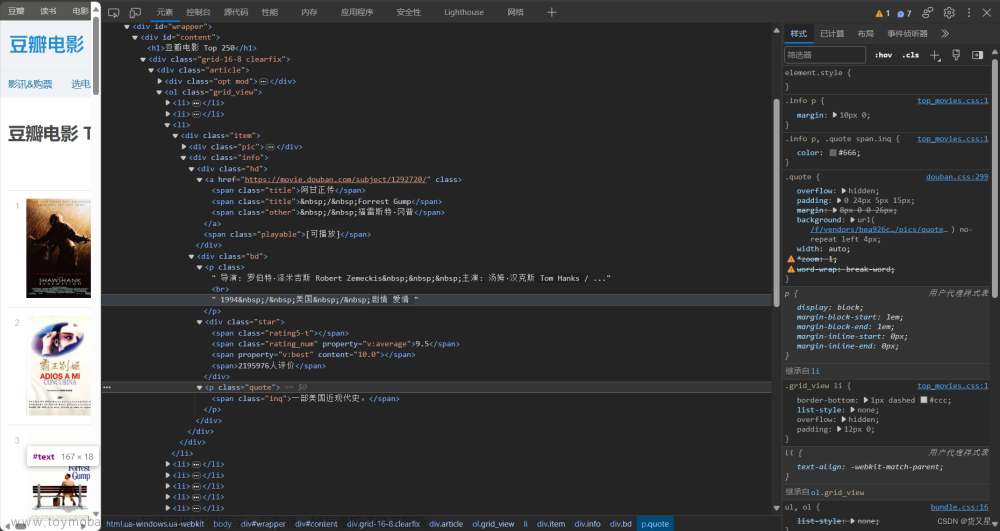

movie_list = soup.select("ol.grid_view li")

# print(movie_list)

# 电影数据对象列表

movie_data_list = []

for movie in movie_list:

try:

rank = movie.select_one("div.pic em").text # 获取排名

title = movie.select_one("div.info span.title").text # 获取电影名称

info = movie.select_one("div.bd p").text.strip() # 获取电影描述信息

rating_num = movie.select_one("div.star span.rating_num").text # 获取评分

comment_count = movie.select("div.star span")[3].text.replace("人评价", "") # 获取评论数

quete_dom = movie.select_one("p.quote span.inq")

quote = ""

if quete_dom:

quote = quete_dom.text

# quote = movie.select_one("p.quote span.inq").text # 获取电影描述

movie_data_list.append({

"rank": rank,

"title": title,

"info": info,

"rating_num": rating_num,

"comment_count": comment_count,

"quote": quote

})

except:

print(movie.select_one("div.pic em").text, "异常", traceback.print_exc())

continue

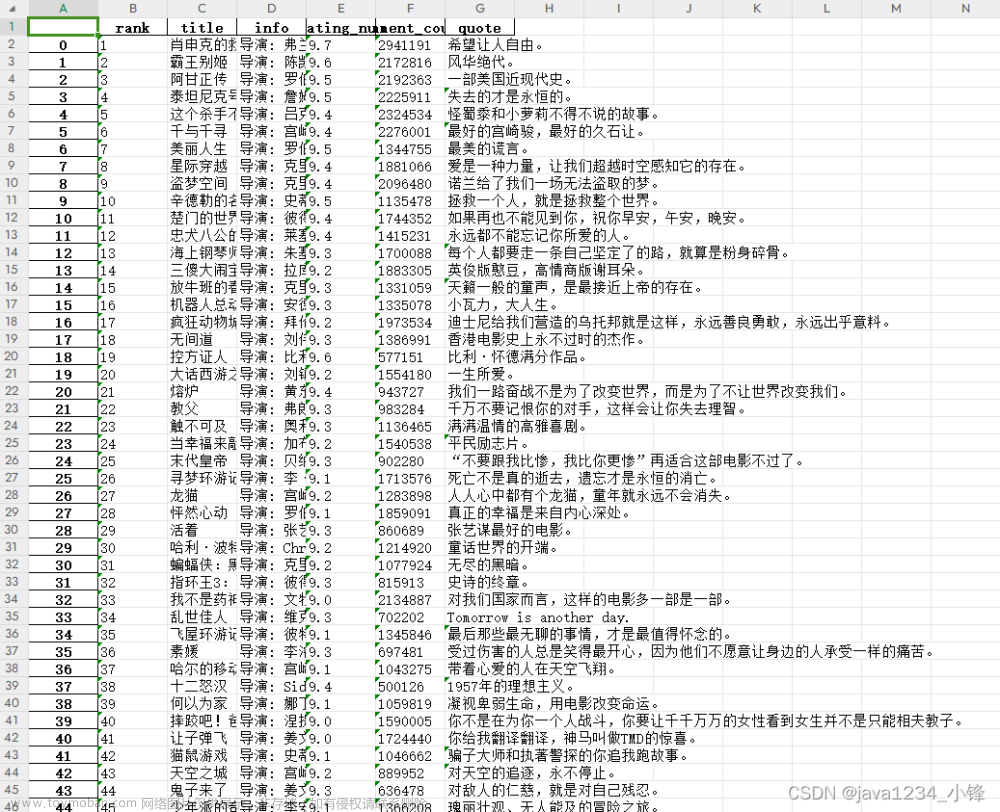

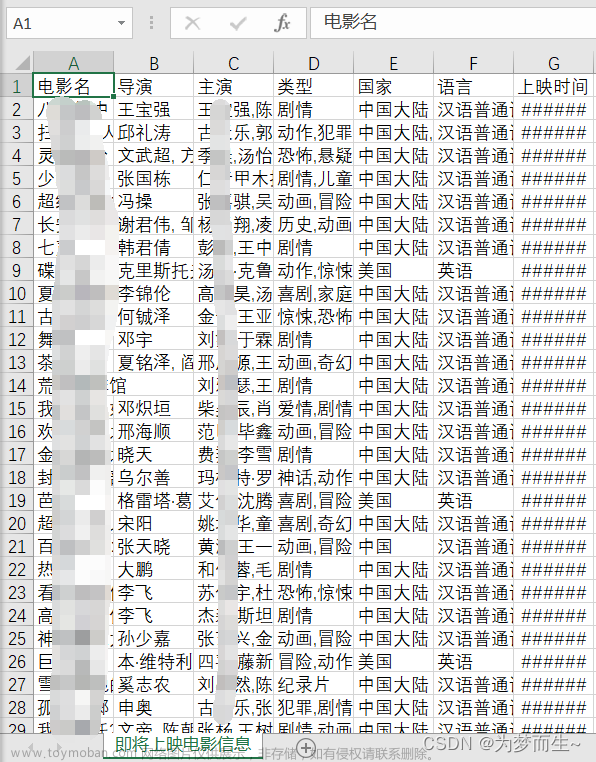

return movie_data_list导出Excel方法:借助pandas库文章来源:https://www.toymoban.com/news/detail-753967.html

def export_excel(datas):

"""

导出数据到Excel

:param datas: 数据

:return:

"""

df = pd.DataFrame(datas)

df.to_excel("豆瓣电影TOP250.xlsx")完整源码参考:具体代码解释,参考帖子顶部的视频教程。文章来源地址https://www.toymoban.com/news/detail-753967.html

"""

豆瓣电影 Top 250 抓取电影信息,存到excel里面

使用requests爬取网页,使用bs4解析数据,使用pandas将数据写入Excel

目标网页:https://movie.douban.com/top250

分页规律 第N页

https://movie.douban.com/top250?start=25*(N-1)&filter=

作者:小锋老师

官网:www.python222.com

"""

import traceback

import requests

from bs4 import BeautifulSoup

import pandas as pd

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/118.0.0.0 Safari/537.36'

}

url = "https://movie.douban.com/top250?start=0&filter="

def crawl_html(url):

"""

解析请求,爬取网页

:param url: 请求地址

:return: 网页源码

"""

response = requests.get(url=url, headers=headers)

return response.text

def parse_html(html):

"""

解析网页源码

:param html: 页面源码

:return: 页面 电影对象信息列表 [ {'':''},{},{} ]

"""

# 实例化soup

soup = BeautifulSoup(html, "lxml")

# 获取所有电影DOM

movie_list = soup.select("ol.grid_view li")

# print(movie_list)

# 电影数据对象列表

movie_data_list = []

for movie in movie_list:

try:

rank = movie.select_one("div.pic em").text # 获取排名

title = movie.select_one("div.info span.title").text # 获取电影名称

info = movie.select_one("div.bd p").text.strip() # 获取电影描述信息

rating_num = movie.select_one("div.star span.rating_num").text # 获取评分

comment_count = movie.select("div.star span")[3].text.replace("人评价", "") # 获取评论数

quete_dom = movie.select_one("p.quote span.inq")

quote = ""

if quete_dom:

quote = quete_dom.text

# quote = movie.select_one("p.quote span.inq").text # 获取电影描述

movie_data_list.append({

"rank": rank,

"title": title,

"info": info,

"rating_num": rating_num,

"comment_count": comment_count,

"quote": quote

})

except:

print(movie.select_one("div.pic em").text, "异常", traceback.print_exc())

continue

return movie_data_list

def export_excel(datas):

"""

导出数据到Excel

:param datas: 数据

:return:

"""

df = pd.DataFrame(datas)

df.to_excel("豆瓣电影TOP250.xlsx")

datas = [] # 所有电影数据

for i in range(1, 11): # 遍历10页

start = 25 * (i - 1)

url = f"https://movie.douban.com/top250?start={start}&filter="

print(url)

movie_data_list = parse_html(crawl_html(url))

datas += movie_data_list

export_excel(datas)

到了这里,关于Python爬虫实战-批量爬取豆瓣电影排行信息的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[Python练习]使用Python爬虫爬取豆瓣top250的电影的页面源码](https://imgs.yssmx.com/Uploads/2024/02/797225-1.png)