클릭 한 번으로 전자상거래 플랫폼 데이터를 캡처하는 것은 일반적으로 웹 페이지에서 정보를 자동으로 추출 할 수있는 네트워크 파충류 기술과 관련됩니다.그러나 모든 형태의 데이터 수집은 해당 웹 사이트의 사용 약관 및 개인 정보 보호 정책 및 현지 법률 및 규정을 준수해야합니다.

다음은 API를 통해 상품 페이지의 상세 데이터를 수집하는 방법을 보여주는 개념적인 단계입니다.

1.대상 전자상거래 플랫폼 선택

타오바오, 징둥, 1688 등 데이터를 잡으려는 전자상거래 플랫폼을 확인하세요.

2. 플랫폼 API 정책 이해

이 플랫폼의 개발자 문서 또는 API 액세스 정책을 검토하여 데이터 캡처 허용 여부를 확인하고 구체적인 기술 요구 사항과 제한을 파악합니다.

3. 개발자 계정 등록

플랫폼에서 API 서비스를 제공하는 경우 일반적으로 API 키(Access Key 또는 API Key)를 얻기 위해 개발자 계정을 등록해야 합니다.

4. 적합한 API 선택

필요에 따라 상품 세부 정보 페이지 데이터를 제공할 수 있는 API 인터페이스를 선택합니다.여기에는 상품 정보, 가격, 재고, 사용자 평가 등이 포함될 수 있다.

5.API 키 요청

플랫폼의 개발자 센터에서 인증 및 액세스 제한에 사용할 API 키를 생성합니다.

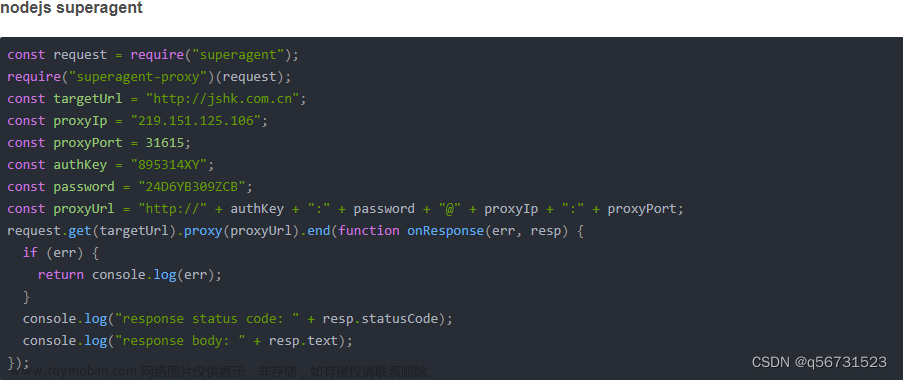

6. 개발 및 테스트

제공된 API 문서를 사용하여 코드를 작성하고 API 인터페이스를 호출하며 모든 것이 제대로 작동하는지 테스트합니다.프로그래밍 언어는 Python, Java, JavaScript 등이 될 수 있습니다.

7. 주파수 제한 및 할당량 준수

API의 주파수 제한과 할당량을 주의하여 과도한 요청으로 인해 차단되지 않도록 하십시오.

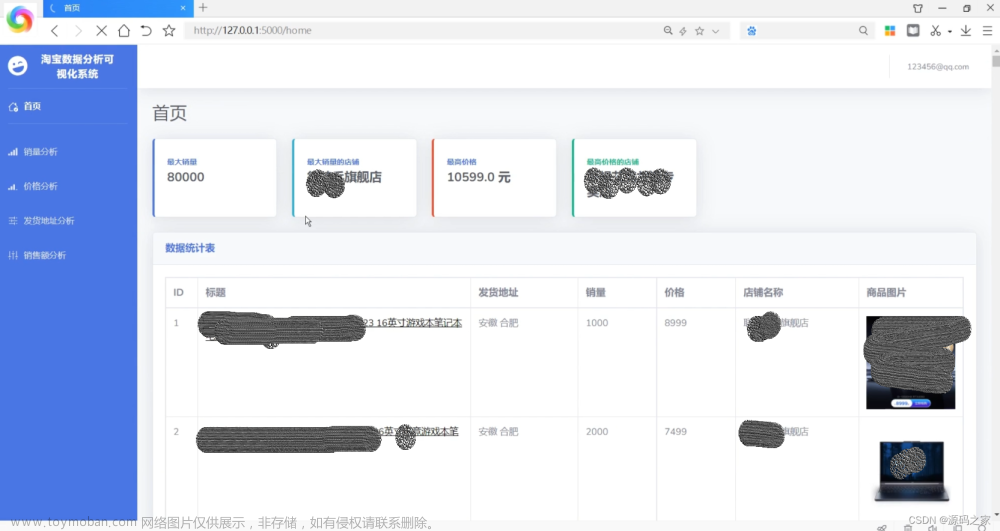

8. 데이터 분석 및 저장

데이터를 가져오면 JSON 또는 XML 응답이 해결되고 필요에 따라 데이터베이스 또는 파일에 저장됩니다.

9. 타이밍 작업 (옵션)

정기적으로 데이터를 업데이트해야 하는 경우 cron job과 같은 타이밍 작업을 설정하여 캡처 프로그램을 자동으로 실행할 수 있습니다.

10. 모니터링 및 유지 관리

데이터 수집 프로세스를 지속적으로 모니터링하여 데이터 품질과 수량이 예상에 부합하는지 확인하고 발생할 수 있는 문제를 디버깅하고 복구합니다.文章来源:https://www.toymoban.com/news/detail-844066.html

결론적으로, 일부 전자상거래 플랫폼은 상품 상세 정보 페이지의 API 인터페이스를 직접 제공하지 않거나 API에 대한 액세스를 엄격히 제한할 수 있습니다.이 경우 타사 데이터 공급업체를 찾거나 더 복잡한 파충류 기술을 사용하고 이 플랫폼의 사용 약관을 엄격히 준수해야 할 수도 있습니다.또한 파충류 방지 기술이 업그레이드됨에 따라 전자상거래 플랫폼은 자동화된 데이터 수집 행위를 막기 위해 다양한 방법을 채택할 수 있기 때문에 이런 프로젝트를 실시할 때 반드시 신중하게 행동해야 한다.文章来源地址https://www.toymoban.com/news/detail-844066.html

到了这里,关于원클릭으로 주류 전자상거래 플랫폼 상품 상세 데이터 수집 및 접속 시연 예제 (한국어판)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!