Elasticsearch 监控和运维

一、概述

Elasticsearch 是一个分布式的开源搜索和分析引擎,用于存储、搜索和分析大量数据。在生产环境中,对 Elasticsearch 进行监控和运维是非常重要的,它可以帮助我们及时发现和解决问题,确保 Elasticsearch 集群的稳定运行。

1. Elasticsearch 监控和运维的意义

Elasticsearch 监控和运维的意义在于:

- 及时发现和解决问题:监控 Elasticsearch 集群可以帮助我们及时发现潜在的问题,如节点故障、索引性能下降等,并采取相应的措施解决问题,以避免对业务产生影响。

- 确保集群的稳定运行:通过监控集群的健康状态、负载情况和性能指标,可以及时调整集群配置,确保集群的稳定运行,提高系统的可用性和性能。

- 提升查询性能:监控查询的响应时间、搜索请求的吞吐量等指标,可以帮助我们优化查询性能,提高用户的搜索体验。

- 规划容量需求:通过监控集群的索引大小、文档数量等指标,可以预测未来的容量需求,做好容量规划,确保集群有足够的资源来处理数据和查询请求。

2. 监控和运维的基本任务和要求

监控和运维 Elasticsearch 需要完成以下基本任务和要求:

- 实时监控集群的健康状态,包括节点的可用性、负载情况、索引的大小和性能等。

- 收集和分析集群的日志,以便及时发现和解决问题。

- 设置警报机制,当集群出现异常情况时及时通知运维人员。

- 进行容量规划,确保集群有足够的资源来处理数据和查询请求。

- 定期备份和恢复数据,以防止数据丢失或损坏。

- 执行性能优化,包括索引的优化、查询的优化等。

- 定期升级 Elasticsearch 版本,以获取新功能和安全性修复。

以下是一个示例的 Java 代码,用于监控 Elasticsearch 集群的健康状态并输出相关信息:

import org.elasticsearch.action.admin.cluster.health.ClusterHealthRequest;

import org.elasticsearch.action.admin.cluster.health.ClusterHealthResponse;

import org.elasticsearch.client.RequestOptions;

import org.elasticsearch.client.RestClient;

import org.elasticsearch.client.RestHighLevelClient;

import org.elasticsearch.cluster.health.ClusterHealthStatus;

import org.elasticsearch.common.unit.TimeValue;

import java.io.IOException;

public class ElasticsearchMonitor {

public static void main(String[] args) {

// 创建 RestHighLevelClient 实例

RestHighLevelClient client = new RestHighLevelClient(

RestClient.builder("localhost:9200"));

// 创建 ClusterHealthRequest 请求

ClusterHealthRequest request = new ClusterHealthRequest();

// 设置超时时间

request.timeout(TimeValue.timeValueSeconds(10));

try {

// 执行请求

ClusterHealthResponse response = client.cluster().health(request, RequestOptions.DEFAULT);

// 获取集群的健康状态

ClusterHealthStatus status = response.getStatus();

// 输出集群的健康状态

System.out.println("集群健康状态: " + status.toString());

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

// 关闭客户端连接

client.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

}

二、监控工具

1. Kibana 监控工具

a. Kibana 的功能与特点

Kibana 是一个基于 Web 的开源分析和可视化平台,用于监控和管理 Elasticsearch 集群。它提供了丰富的图表和仪表盘,可以帮助我们实时监控集群的健康状态、性能指标和查询情况。Kibana 还支持自定义仪表盘和可视化图表,让我们可以根据需求创建定制化的监控和报表。

b. Kibana 的安装与配置

Kibana 的安装和配置步骤如下:

- 下载 Kibana 的压缩包。

- 解压缩压缩包到指定目录。

- 修改配置文件

kibana.yml,设置 Elasticsearch 的地址和端口。 - 启动 Kibana 服务。

以下是一个示例的 Java 代码,用于启动 Kibana 服务:

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.node.Node;

import org.elasticsearch.node.NodeBuilder;

public class KibanaStarter {

public static void main(String[] args) {

// 设置 Elasticsearch 的地址和端口

Settings settings = Settings.builder()

.put("elasticsearch.hosts", "localhost:9200")

.build();

// 创建 Node 实例

Node node = NodeBuilder.nodeBuilder()

.settings(settings)

.node();

// 启动 Kibana 服务

node.start();

}

}

c. Kibana 的使用方法

Kibana 的使用方法如下:

- 打开浏览器,访问 Kibana 的地址。

- 在 Kibana 的首页,选择需要监控的 Elasticsearch 集群。

- 在仪表盘中选择合适的图表和指标,查看集群的健康状态、性能指标和查询情况。

- 根据需求创建自定义仪表盘和可视化图表。

2. Cerebro 监控工具

a. Cerebro 的功能与特点

Cerebro 是一个开源的 Elasticsearch 集群管理工具,提供了直观的界面,用于监控和管理 Elasticsearch 集群。它支持对集群的健康状态、节点信息、索引信息等进行实时监控,还提供了索引和节点的管理功能。

b. Cerebro 的安装与配置

Cerebro 的安装和配置步骤如下:

- 下载 Cerebro 的压缩包。

- 解压缩压缩包到指定目录。

- 修改配置文件

cerebro.conf,设置 Elasticsearch 的地址和端口。 - 启动 Cerebro 服务。

以下是一个示例的 Java 代码,用于启动 Cerebro 服务:

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.node.Node;

import org.elasticsearch.node.NodeBuilder;

public class CerebroStarter {

public static void main(String[] args) {

// 设置 Elasticsearch 的地址和端口

Settings settings = Settings.builder()

.put("elasticsearch.hosts", "localhost:9200")

.build();

// 创建 Node 实例

Node node = NodeBuilder.nodeBuilder()

.settings(settings)

.node();

// 启动 Cerebro 服务

node.start();

}

}

c. Cerebro 的使用方法

Cerebro 的使用方法如下:

- 打开浏览器,访问 Cerebro 的地址。

- 在 Cerebro 的首页,选择需要监控的 Elasticsearch 集群。

- 在集群概览页面,查看集群的健康状态、节点信息和索引信息。

- 使用索引和节点管理功能,对集群进行管理和操作。

3. Kopf 监控工具

a. Kopf 的功能与特点

Kopf 是一个基于 Web 的 Elasticsearch 集群管理工具,提供了直观的界面,用于监控和管理 Elasticsearch 集群。它支持实时监控集群的健康状态、节点信息和索引信息,还提供了索引和节点的管理功能。

b. Kopf 的安装与配置

Kopf 的安装和配置步骤如下:

- 下载 Kopf 的压缩包。

- 解压缩压缩包到指定目录。

- 修改配置文件

kopf_settings.json,设置 Elasticsearch 的地址和端口。 - 启动 Kopf 服务。

以下是一个示例的 Java 代码,用于启动 Kopf 服务:

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.node.Node;

import org.elasticsearch.node.NodeBuilder;

public class KopfStarter {

public static void main(String[] args) {

// 设置 Elasticsearch 的地址和端口

Settings settings = Settings.builder()

.put("elasticsearch.hosts", "localhost:9200")

.build();

// 创建 Node 实例

Node node = NodeBuilder.nodeBuilder()

.settings(settings)

.node();

// 启动 Kopf 服务

node.start();

}

}

c. Kopf 的使用方法

Kopf 的使用方法如下:

- 打开浏览器,访问 Kopf 的地址。

- 在 Kopf 的首页,选择需要监控的 Elasticsearch 集群。

- 在集群概览页面,查看集群的健康状态、节点信息和索引信息。

- 使用索引和节点管理功能,对集群进行管理和操作。

三、Elasticsearch 运维技巧与实践

1. 数据备份和恢复

a. Elasticsearch 数据备份常用方法

Elasticsearch 数据备份的常用方法有以下几种:

- 使用 Elasticsearch 的 Snapshot API 进行备份。可以通过创建一个仓库来存储备份数据,并使用 Snapshot API 将数据备份到该仓库中。

以下是一个示例的 Java 代码,用于创建一个仓库并进行数据备份:

import org.elasticsearch.action.admin.cluster.snapshots.create.CreateSnapshotRequestBuilder;

import org.elasticsearch.action.admin.cluster.snapshots.create.CreateSnapshotResponse;

import org.elasticsearch.client.transport.TransportClient;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.TransportAddress;

import org.elasticsearch.common.unit.TimeValue;

import org.elasticsearch.common.xcontent.XContentBuilder;

import org.elasticsearch.common.xcontent.XContentFactory;

import org.elasticsearch.transport.client.PreBuiltTransportClient;

import java.net.InetAddress;

import java.util.concurrent.ExecutionException;

public class ElasticsearchBackup {

public static void main(String[] args) throws Exception {

// 设置 Elasticsearch 的地址和端口

TransportClient client = new PreBuiltTransportClient(Settings.EMPTY)

.addTransportAddress(new TransportAddress(InetAddress.getByName("localhost"), 9300));

// 创建一个仓库

XContentBuilder repository = XContentFactory.jsonBuilder()

.startObject()

.field("type", "fs")

.field("settings")

.startObject()

.field("location", "/path/to/backup") // 设置备份数据的存储路径

.endObject()

.endObject();

// 创建快照请求

CreateSnapshotRequestBuilder createSnapshotRequestBuilder = client.admin().cluster().prepareCreateSnapshot("my_backup", "my_snapshot")

.setSettings(Settings.builder()

.put("indices", "my_index") // 设置需要备份的索引

.put("ignore_unavailable", true)

.put("include_global_state", false)

.put("wait_for_completion", true)

.put("timeout", TimeValue.timeValueMinutes(10))

)

.setRepository("my_repository")

.setWaitForCompletion(true);

// 执行备份操作

CreateSnapshotResponse createSnapshotResponse = createSnapshotRequestBuilder.get();

// 打印备份结果

System.out.println("Snapshot created: " + createSnapshotResponse.isAcknowledged());

// 关闭连接

client.close();

}

}

- 使用 Elasticsearch 的 Reindex API 进行备份。可以使用 Reindex API 将数据从一个索引复制到另一个索引,从而实现数据备份的目的。

以下是一个示例的 Java 代码,用于使用 Reindex API 进行数据备份:

import org.elasticsearch.action.bulk.BulkRequestBuilder;

import org.elasticsearch.action.bulk.BulkResponse;

import org.elasticsearch.action.search.SearchResponse;

import org.elasticsearch.action.search.SearchType;

import org.elasticsearch.client.Client;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.TransportAddress;

import org.elasticsearch.common.unit.TimeValue;

import org.elasticsearch.common.xcontent.XContentBuilder;

import org.elasticsearch.common.xcontent.XContentFactory;

import org.elasticsearch.index.query.QueryBuilders;

import org.elasticsearch.node.Node;

import org.elasticsearch.node.NodeBuilder;

import org.elasticsearch.search.SearchHit;

import java.net.InetAddress;

import java.util.Map;

public class ElasticsearchBackup {

public static void main(String[] args) throws Exception {

// 创建一个节点

Node node = NodeBuilder.nodeBuilder().settings(Settings.EMPTY).node();

Client client = node.client();

// 创建源索引和目标索引

String sourceIndex = "my_source_index";

String targetIndex = "my_target_index";

// 创建查询条件

XContentBuilder query = XContentFactory.jsonBuilder()

.startObject()

.startObject("query")

.startObject("match_all")

.endObject()

.endObject()

.endObject();

// 执行查询操作

SearchResponse searchResponse = client.prepareSearch(sourceIndex)

.setTypes()

.setSearchType(SearchType.DFS_QUERY_THEN_FETCH)

.setQuery(QueryBuilders.wrapperQuery(query.string()))

.setSize(1000)

.setScroll(TimeValue.timeValueMinutes(1))

.execute()

.actionGet();

// 创建批量请求

BulkRequestBuilder bulkRequest = client.prepareBulk();

// 处理查询结果

while (true) {

for (SearchHit hit : searchResponse.getHits().getHits()) {

Map<String, Object> source = hit.getSourceAsMap();

// 创建索引请求

XContentBuilder indexRequest = XContentFactory.jsonBuilder()

.startObject()

.field("field1", source.get("field1"))

.field("field2", source.get("field2"))

.endObject();

// 添加到批量请求中

bulkRequest.add(client.prepareIndex(targetIndex, hit.getType(), hit.getId())

.setSource(indexRequest));

}

// 执行批量请求

BulkResponse bulkResponse = bulkRequest.execute().actionGet();

// 清空批量请求

bulkRequest.request().requests().clear();

// 检查是否还有数据需要处理

searchResponse = client.prepareSearchScroll(searchResponse.getScrollId())

.setScroll(TimeValue.timeValueMinutes(1))

.execute()

.actionGet();

if (searchResponse.getHits().getHits().length == 0) {

break;

}

}

// 关闭连接

node.close();

}

}

b. Elasticsearch 数据恢复常用方法

Elasticsearch 数据恢复的常用方法有以下几种:

- 使用 Elasticsearch 的 Restore API 进行恢复。可以使用 Restore API 将备份的数据恢复到 Elasticsearch 集群中。

以下是一个示例的 Java 代码,用于使用 Restore API 进行数据恢复:

import org.elasticsearch.action.admin.cluster.snapshots.restore.RestoreSnapshotRequestBuilder;

import org.elasticsearch.action.admin.cluster.snapshots.restore.RestoreSnapshotResponse;

import org.elasticsearch.client.transport.TransportClient;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.TransportAddress;

import org.elasticsearch.common.unit.TimeValue;

import org.elasticsearch.common.xcontent.XContentBuilder;

import org.elasticsearch.common.xcontent.XContentFactory;

import org.elasticsearch.transport.client.PreBuiltTransportClient;

import java.net.InetAddress;

import java.util.concurrent.ExecutionException;

public class ElasticsearchRestore {

public static void main(String[] args) throws Exception {

// 设置 Elasticsearch 的地址和端口

TransportClient client = new PreBuiltTransportClient(Settings.EMPTY)

.addTransportAddress(new TransportAddress(InetAddress.getByName("localhost"), 9300));

// 创建恢复请求

RestoreSnapshotRequestBuilder restoreSnapshotRequestBuilder = client.admin().cluster().prepareRestoreSnapshot("my_backup", "my_snapshot")

.setWaitForCompletion(true);

// 执行恢复操作

RestoreSnapshotResponse restoreSnapshotResponse = restoreSnapshotRequestBuilder.get();

// 打印恢复结果

System.out.println("Snapshot restored: " + restoreSnapshotResponse.isAcknowledged());

// 关闭连接

client.close();

}

}

2. 性能优化与提升

a. 分片的设置与优化

在 Elasticsearch 中,分片是数据的基本单位,合理设置和优化分片可以提升性能。以下是一些分片设置和优化的技巧:

- 合理设置分片数量:分片数量过多会增加集群的负载,分片数量过少会限制集群的扩展能力。一般建议根据数据量和硬件资源来设置分片数量,通常每个节点上的分片数量不要超过20个。

- 避免频繁的分片重分配:分片重分配会占用集群的资源,影响性能。可以通过设置合适的分片副本数和分片路由规则来避免频繁的分片重分配。

- 使用本地磁盘存储分片:将分片存储在本地磁盘上可以提高读写性能,避免网络开销。可以通过设置

path.data属性来指定分片存储的路径。

以下是一个示例的 Java 代码,用于设置和优化分片:

import org.elasticsearch.action.admin.indices.create.CreateIndexRequestBuilder;

import org.elasticsearch.action.admin.indices.create.CreateIndexResponse;

import org.elasticsearch.client.transport.TransportClient;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.TransportAddress;

import org.elasticsearch.common.unit.ByteSizeUnit;

import org.elasticsearch.common.unit.ByteSizeValue;

import org.elasticsearch.common.unit.TimeValue;

import org.elasticsearch.transport.client.PreBuiltTransportClient;

import java.net.InetAddress;

public class ElasticsearchShardOptimization {

public static void main(String[] args) throws Exception {

// 设置 Elasticsearch 的地址和端口

TransportClient client = new PreBuiltTransportClient(Settings.EMPTY)

.addTransportAddress(new TransportAddress(InetAddress.getByName("localhost"), 9300));

// 创建索引请求

CreateIndexRequestBuilder createIndexRequestBuilder = client.admin().indices().prepareCreate("my_index")

.setSettings(Settings.builder()

.put("number_of_shards", 5) // 设置分片数量

.put("number_of_replicas", 1) // 设置分片副本数量

.put("routing.allocation.enable", "all")

.put("path.data", "/path/to/data") // 设置分片存储的路径

.put("indices.store.throttle.max_bytes_per_sec", new ByteSizeValue(50, ByteSizeUnit.MB)) // 设置分片存储的速率

.put("indices.recovery.max_bytes_per_sec", new ByteSizeValue(100, ByteSizeUnit.MB)) // 设置分片恢复的速率

.put("indices.recovery.concurrent_streams", 5) // 设置分片恢复的并发流数量

.put("indices.recovery.compress", true) // 设置分片恢复时是否压缩数据

.put("indices.recovery.max_bytes_per_sec", new ByteSizeValue(100, ByteSizeUnit.MB))) // 设置分片恢复的速率

.setTimeout(TimeValue.timeValueMinutes(1));

// 执行创建索引操作

CreateIndexResponse createIndexResponse = createIndexRequestBuilder.get();

// 打印创建索引结果

System.out.println("Index created: " + createIndexResponse.isAcknowledged());

// 关闭连接

client.close();

}

}

b. 索引的设计与优化

索引的设计和优化对于 Elasticsearch 的性能和查询效率至关重要。以下是一些索引设计和优化的技巧:

- 合理选择字段类型:根据字段的特性选择合适的字段类型,可以减少存储空间的占用和提高查询效率。例如,对于文本类型的字段,可以使用

text类型而不是keyword类型,以节省存储空间。 - 使用合适的分词器:分词器决定了文本如何被分割成词项,影响了搜索和聚合的结果。根据实际需求选择合适的分词器可以提高查询的准确性和效率。

- 禁用不必要的字段:禁用不必要的字段可以减少存储空间的占用和提高查询效率。可以通过设置

enabled属性为false来禁用字段。

以下是一个示例的 Java 代码,用于设计和优化索引:

import org.elasticsearch.action.admin.indices.create.CreateIndexRequestBuilder;

import org.elasticsearch.action.admin.indices.create.CreateIndexResponse;

import org.elasticsearch.client.transport.TransportClient;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.TransportAddress;

import org.elasticsearch.common.unit.ByteSizeUnit;

import org.elasticsearch.common.unit.ByteSizeValue;

import org.elasticsearch.common.unit.TimeValue;

import org.elasticsearch.transport.client.PreBuiltTransportClient;

import java.net.InetAddress;

public class ElasticsearchIndexOptimization {

public static void main(String[] args) throws Exception {

// 设置 Elasticsearch 的地址和端口

TransportClient client = new PreBuiltTransportClient(Settings.EMPTY)

.addTransportAddress(new TransportAddress(InetAddress.getByName("localhost"), 9300));

// 创建索引请求

CreateIndexRequestBuilder createIndexRequestBuilder = client.admin().indices().prepareCreate("my_index")

.setSettings(Settings.builder()

.put("number_of_shards", 5)

.put("number_of_replicas", 1)

.put("analysis.analyzer.my_analyzer.type", "custom") // 设置自定义分词器

.put("analysis.analyzer.my_analyzer.tokenizer", "standard")

.put("analysis.analyzer.my_analyzer.filter", "lowercase")

.put("analysis.analyzer.my_analyzer.stopwords", "_none_")

.put("analysis.analyzer.my_analyzer.max_token_length", 255)

.put("index.mapping.ignore_malformed", true) // 忽略格式错误的字段

.put("index.mapping.total_fields.limit", 10000) // 设置字段数量的限制

.put("index.mapping.nested_fields.limit", 100) // 设置嵌套字段数量的限制

.put("index.mapping.depth.limit", 20) // 设置字段嵌套深度的限制

.put("index.mapping.nested_objects.limit", 10000)) // 设置嵌套对象数量的限制

.setTimeout(TimeValue.timeValueMinutes(1));

// 执行创建索引操作

CreateIndexResponse createIndexResponse = createIndexRequestBuilder.get();

// 打印创建索引结果

System.out.println("Index created: " + createIndexResponse.isAcknowledged());

// 关闭连接

client.close();

}

}

c. 热点数据的处理

热点数据是指访问频率较高的数据,对于热点数据的处理可以提高查询效率和响应速度。以下是一些处理热点数据的技巧:

- 使用缓存:可以使用缓存来存储热点数据,减少对 Elasticsearch 的查询次数。可以使用第三方缓存工具如 Redis 或 Memcached。

- 使用索引别名:可以将热点数据的索引设置为别名,然后将查询请求发送到别名,以便动态切换查询的目标索引。

- 使用近实时搜索:可以通过设置合适的刷新间隔来实现近实时搜索,减少对热点数据的查询延迟。

d. JVM 调优

JVM 调优是提升 Elasticsearch 性能的重要步骤。以下是一些 JVM 调优的技巧:

-

分配合适的堆内存:根据集群的硬件资源和数据量来分配合适的堆内存大小,以避免频繁的垃圾回收和内存溢出错误。

-

调整垃圾回收器参数:可以根据实际情况选择合适的垃圾回收器和调整其参数,以提高垃圾回收的效率和性能。

-

监控和分析内存使用情况:可以使用 Elasticsearch 的监控工具如 Kibana、Cerebro 或 Kopf 来监控和分析内存使用情况,及时发现和解决潜在的内存问题。

-

使用合适的堆外内存:可以将一部分数据存储在堆外内存中,以减轻堆内存的压力。可以通过设置

index.store.type属性为mmapfs或nfs来使用堆外存储。 -

调整线程池大小:可以根据集群的负载和硬件资源来调整线程池的大小,以提高并发处理能力和响应速度。

-

关闭不必要的插件和功能:可以根据实际需求关闭不必要的插件和功能,以减少内存和CPU的占用。

e. 监控和告警

监控和告警是及时发现和解决问题的关键。以下是一些监控和告警的技巧:

- 使用监控工具:可以使用 Elasticsearch 的监控工具如 Kibana、Cerebro 或 Kopf 来监控集群的状态、性能指标和日志信息。

- 设置告警规则:可以根据实际需求设置合适的告警规则,以便在集群出现异常或达到阈值时及时通知管理员。

- 定期备份数据:定期备份数据可以保证数据的安全性和可恢复性,在数据丢失或损坏时能够快速恢复。

3. 数据备份与恢复

数据备份和恢复是保证数据安全和可靠性的重要措施。以下是一些常用的数据备份和恢复方法:

- 使用 Elasticsearch 的 Snapshot API:Elasticsearch 提供了 Snapshot API 来进行数据备份和恢复。可以使用

PUT /_snapshot/{repository}/{snapshot}来创建快照,使用POST /_snapshot/{repository}/{snapshot}/_restore来恢复快照。 - 使用 Elasticsearch 的 Reindex API:Elasticsearch 提供了 Reindex API 来重新索引数据。可以使用

POST _reindex来重新索引数据,可以通过指定源索引和目标索引来实现数据的备份和恢复。 - 使用第三方工具:除了 Elasticsearch 自带的工具,还可以使用一些第三方工具来进行数据备份和恢复,如 Elasticsearch Curator、Elasticsearch Backup for S3 等。

四、Elasticsearch 集群运维

1. 多节点部署

a. 集群的基本概念和组成部分

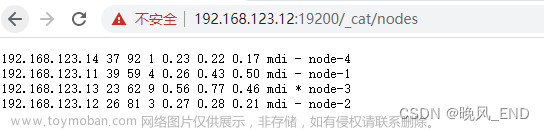

Elasticsearch 集群由多个节点组成,每个节点可以是主节点或数据节点。主节点负责集群管理和协调工作,数据节点负责存储和处理数据。

b. 集群的配置方法

可以通过修改 Elasticsearch 的配置文件来配置集群。配置文件通常位于 Elasticsearch 安装目录的 config 文件夹下,主要包含以下几个重要的配置项:

-

cluster.name:集群的名称,所有节点必须使用相同的集群名称才能加入同一个集群。 -

node.name:节点的名称,用于标识节点在集群中的身份。 -

network.host:节点绑定的网络地址,可以设置为具体的 IP 地址或主机名。 -

discovery.seed_hosts:用于发现其他节点的初始主机列表。 -

cluster.initial_master_nodes:用于指定初始主节点列表。

以下是一个示例的 Java 代码,用于配置 Elasticsearch 集群:

import org.elasticsearch.action.admin.cluster.settings.ClusterUpdateSettingsRequest;

import org.elasticsearch.action.admin.cluster.settings.ClusterUpdateSettingsResponse;

import org.elasticsearch.client.transport.TransportClient;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.TransportAddress;

import org.elasticsearch.transport.client.PreBuiltTransportClient;

import java.net.InetAddress;

public class ElasticsearchClusterConfiguration {

public static void main(String[] args) throws Exception {

// 设置 Elasticsearch 的地址和端口

TransportClient client = new PreBuiltTransportClient(Settings.EMPTY)

.addTransportAddress(new TransportAddress(InetAddress.getByName("localhost"), 9300));

// 创建集群配置请求

ClusterUpdateSettingsRequest clusterUpdateSettingsRequest = new ClusterUpdateSettingsRequest()

.persistentSettings(Settings.builder()

.put("cluster.routing.allocation.enable", "all") // 允许分片分配

.put("cluster.routing.allocation.disk.threshold_enabled", false) // 禁用磁盘阈值

.put("cluster.routing.allocation.cluster_concurrent_rebalance", 2) // 设置并发平衡操作的数量

.put("cluster.routing.allocation.node_concurrent_recoveries", 4) // 设置并发恢复操作的数量

.put("indices.recovery.max_bytes_per_sec", "100mb") // 设置恢复速率

.put("indices.recovery.concurrent_streams", 5) // 设置恢复并发流的数量

.put("indices.recovery.compress", true) // 启用恢复时的压缩

.put("indices.recovery.max_bytes_per_sec", "100mb")) // 设置恢复速率

.transientSettings(Settings.builder()

.put("cluster.routing.allocation.enable", "all")

.put("cluster.routing.allocation.disk.threshold_enabled", false)

.put("cluster.routing.allocation.cluster_concurrent_rebalance", 2)

.put("cluster.routing.allocation.node_concurrent_recoveries", 4)

.put("indices.recovery.max_bytes_per_sec", "100mb")

.put("indices.recovery.concurrent_streams", 5)

.put("indices.recovery.compress", true)

.put("indices.recovery.max_bytes_per_sec", "100mb"));

// 发送集群配置请求

ClusterUpdateSettingsResponse clusterUpdateSettingsResponse = client.admin().cluster()

.updateSettings(clusterUpdateSettingsRequest).actionGet();

// 打印集群配置结果

System.out.println(clusterUpdateSettingsResponse.isAcknowledged());

}

}

c. 集群的入门级调优

对于入门级的集群调优,可以采取以下措施来提升性能和稳定性:

- 增加节点数:通过增加节点数来提高集群的处理能力和容错能力。

- 设置合适的分片和副本数:根据数据量和硬件资源来设置合适的分片和副本数,以平衡负载和提高查询性能。

- 配置 JVM 堆内存:根据集群的硬件资源和数据量来配置合适的 JVM 堆内存大小,以避免频繁的垃圾回收和内存溢出错误。

- 合理使用索引和查询优化:根据实际需求设计合理的索引结构和查询语句,可以使用 Elasticsearch 的查询优化工具如 Explain API 来分析查询性能。

2. 集群安全

a. Elasticsearch 集群的安全问题

Elasticsearch 集群的安全问题主要包括未授权访问、数据泄露和拒绝服务攻击等。这些安全问题可能导致数据泄露、数据损坏或集群不可用。

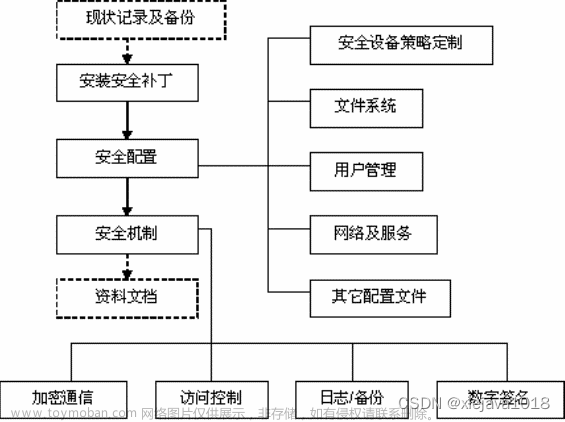

b. 安全配置与措施

为了保护 Elasticsearch 集群的安全,可以采取以下安全配置与措施:

- 使用安全插件:可以安装和配置 Elasticsearch 的安全插件,如 Search Guard、X-Pack Security 等,来加强集群的安全性。

- 启用身份验证和授权:可以配置 Elasticsearch 集群的身份验证和授权机制,如用户名/密码认证、角色权限管理等,以控制用户对集群的访问权限。

- 配置安全组和防火墙:可以通过配置安全组和防火墙来限制集群的访问,只允许特定的 IP 地址或网络访问集群。

- 加密通信:可以配置 Elasticsearch 集群的通信使用 SSL/TLS 加密,以保护数据在传输过程中的安全性。

c. 安全漏洞的预防与修复

为了预防和修复安全漏洞,可以采取以下措施:

- 及时升级 Elasticsearch 版本:及时升级到最新版本可以修复已知的安全漏洞,并获得更好的安全性能和功能。

- 定期进行安全审计:定期对 Elasticsearch 集群进行安全审计,检查是否存在潜在的安全风险,并及时采取措施进行修复。

- 密码和访问控制的管理:定期更新密码,禁用不必要的用户和角色,以及限制访问权限。

五、Elasticsearch 监控和运维中的常见问题和解决方案

1. 常见问题及其发生原因

在 Elasticsearch 监控和运维过程中,可能会遇到以下常见问题:

- 集群健康状态异常:可能是由于节点故障、网络问题或资源不足等原因导致集群健康状态异常。

- 慢查询和性能问题:可能是由于查询复杂、索引设计不合理或硬件资源不足等原因导致慢查询和性能问题。

- 数据丢失或损坏:可能是由于磁盘故障、网络传输错误或索引操作错误等原因导致数据丢失或损坏。

- 内存溢出和垃圾回收问题:可能是由于 JVM 堆内存设置不合理、频繁的垃圾回收或内存泄漏等原因导致内存溢出和垃圾回收问题。

2. 保持 Elasticsearch 的稳定性、高可用性和高性能

为了保持 Elasticsearch 的稳定性、高可用性和高性能,可以采取以下措施:文章来源:https://www.toymoban.com/news/detail-861410.html

- 监控集群健康状态:定期监控集群的健康状态,包括节点的可用性、分片的分配情况和索引的状态等,及时发现并解决问题。

- 配置合适的硬件资源:根据集群的规模和负载情况,配置足够的硬件资源,包括 CPU、内存、磁盘和网络带宽等。

- 优化查询性能:通过合理的索引设计、查询优化和缓存机制等手段,提高查询性能和响应速度。

- 配置合适的分片和副本数:根据数据量和硬件资源,配置合适的分片和副本数,以提高负载均衡和故障恢复能力。

- 定期备份和恢复数据:定期备份 Elasticsearch 的数据,并测试恢复过程,以防止数据丢失和损坏。

- 定期优化索引:定期进行索引优化,包括合并段、压缩索引、优化存储和刷新策略等,以提高索引的性能和存储效率。

3. 应对 Elasticsearch 运维事故

在应对 Elasticsearch 运维事故时,可以采取以下措施:文章来源地址https://www.toymoban.com/news/detail-861410.html

- 故障排查和日志分析:通过查看日志文件和运行时指标,定位故障原因,并采取相应的措施进行修复。

- 数据恢复和重建:在数据丢失或损坏的情况下,可以通过备份数据或重新索引数据来恢复数据。

- 故障转移和故障恢复:在节点故障或网络问题的情况下,可以通过故障转移和故障恢复机制来保证集群的可用性。

- 性能调优和优化:通过监控和调整集群的性能指标,识别性能瓶颈并进行性能调优和优化。

- 定期维护和升级:定期进行维护和升级操作,包括安全补丁的应用、版本升级和索引优化等,以保证集群的稳定性和安全性。

到了这里,关于Elasticsearch 监控和运维的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!