这篇文章主要介绍“Python中如何使用Selenium爬取网页数据”,在日常操作中,相信很多人在Python中如何使用Selenium爬取网页数据问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”Python中如何使用Selenium爬取网页数据”的疑惑有所帮助!接下来,请跟着小编一起来学习吧!

一. 什么是Selenium

网络爬虫是Python编程中一个非常有用的技巧,它可以让您自动获取网页上的数据。

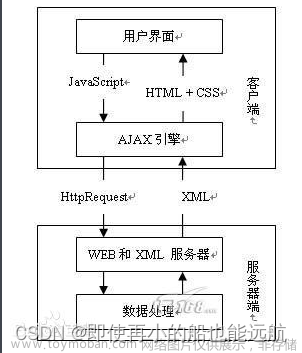

Selenium是一个自动化测试工具,它可以模拟用户在浏览器中的操作,比如点击按钮、填写表单等。与常用的BeautifulSoup、requests等爬虫库不同,Selenium可以处理JavaScript动态加载的内容,因此对于那些需要模拟用户交互才能获取的数据,Selenium是一个非常合适的选择。

二. 安装Selenium

要使用Selenium,首先需要安装它。您可以使用pip命令来安装Selenium库:

pip install selenium

安装完成后,还需要下载一个与Selenium配套使用的浏览器驱动程序。本文以Chrome浏览器为例,您需要下载与您的Chrome浏览器版本对应的ChromeDriver。下载地址:sites.google.com/a/chromium.…

下载并解压缩后,将chromedriver.exe文件放到一个合适的位置,并记住该位置,稍后我们需要在代码中使用。

三. 爬取网页数据

下面是一个简单的示例,我们将使用Selenium爬取一个网页,并输出页面标题。

from selenium import webdriver

# 指定chromedriver.exe的路径

driver_path = r"C:\path\to\chromedriver.exe"

# 创建一个WebDriver实例,指定使用Chrome浏览器

driver = webdriver.Chrome(driver_path)

# 访问目标网站

driver.get("https://www.example.com")

# 获取网页标题

page_title = driver.title

print("Page Title:", page_title)

# 关闭浏览器

driver.quit()

四. 模拟用户交互

Selenium可以模拟用户在浏览器中的各种操作,如点击按钮、填写表单等。以下是一个示例,我们将使用Selenium在网站上进行登录操作:

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

driver_path = r"C:\path\to\chromedriver.exe"

driver = webdriver.Chrome(driver_path)

driver.get("https://www.example.com/login")

# 定位用户名和密码输入框

username_input = driver.find_element_by_name("username")

password_input = driver.find_element_by_name("password")

# 输入用户名和密码

username_input.send_keys("your_username")

password_input.send_keys("your_password")

# 模拟点击登录按钮

login_button = driver.find_element_by_xpath("//button[@type='submit']")

login_button.click()

# 其他操作...

# 关闭浏览器

driver.quit()

通过结合Selenium的各种功能,您可以编写强大的网络爬虫来爬取各种网站上的数据。但请注意,在进行网络爬虫时,务必遵守目标网站的robots.txt规定,并尊重网站的数据抓取政策。另外,过于频繁的爬取可能会给网站带来负担,甚至触发反爬机制,因此建议合理控制爬取速度。

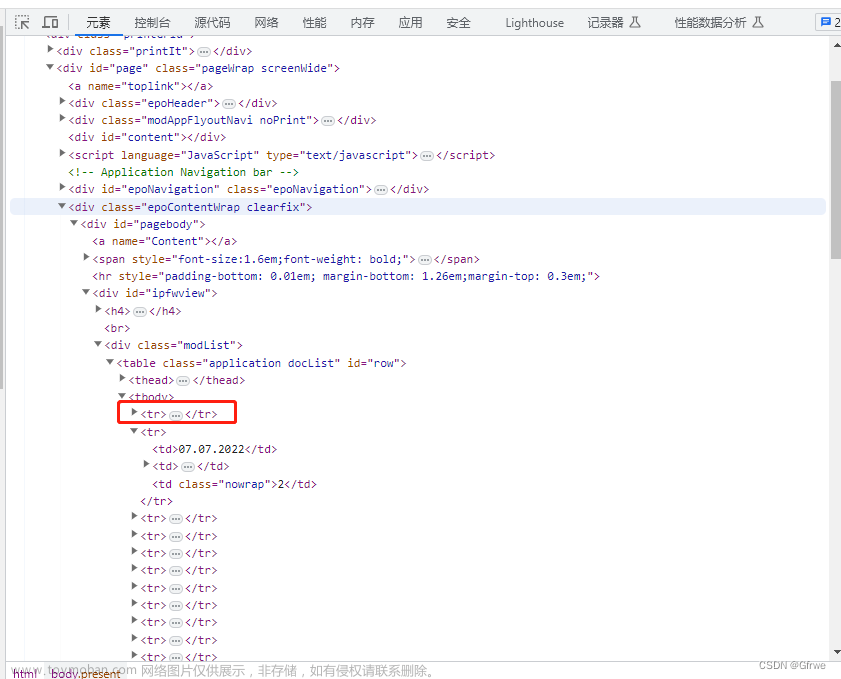

五. 处理动态加载内容

对于一些动态加载内容的网站,我们可以利用Selenium提供的显式等待和隐式等待机制,以确保网页上的元素已经加载完成。

1. 显式等待

显式等待指的是设置一个具体的等待条件,等待某个元素在指定时间内满足条件。

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

driver_path = r"C:\path\to\chromedriver.exe"

driver = webdriver.Chrome(driver_path)

driver.get("https://www.example.com/dynamic-content")

# 等待指定元素出现,最多等待10秒

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "dynamic-element-id"))

)

# 操作该元素...

driver.quit()

2. 隐式等待

隐式等待是设置一个全局的等待时间,如果在这个时间内元素未出现,将引发一个异常。文章来源:https://www.toymoban.com/news/detail-467779.html

from selenium import webdriver

driver_path = r"C:\path\to\chromedriver.exe"

driver = webdriver.Chrome(driver_path)

# 设置隐式等待时间为10秒

driver.implicitly_wait(10)

driver.get("https://www.example.com/dynamic-content")

# 尝试定位元素

element = driver.find_element_by_id("dynamic-element-id")

# 操作该元素...

driver.quit()

到此,关于“Python中如何使用Selenium爬取网页数据”的学习就结束了,希望能够解决大家的疑惑。文章来源地址https://www.toymoban.com/news/detail-467779.html

到了这里,关于华纳云:Python中如何使用Selenium爬取网页数据的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!