1、环境准备

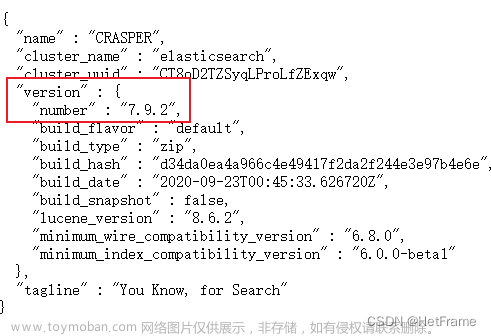

Elasticsearch 要使用 ik,就要先构建 ik 的 jar包,这里要用到 maven 包管理工具,而 maven 需要java 环境,而 Elasticsearch 内置了jdk, 所以可以将JAVA_HOME设置为Elasticsearch 内置的jdk

1)设置JAVA_HOME

vim /etc/profile

# 在profile文件末尾添加

#java environment

export JAVA_HOME=/opt/elasticsearch-7.4.0/jdk

export PATH=$PATH:${JAVA_HOME}/bin

# 保存退出后,重新加载profile

source /etc/profile

2)准备maven安装包

上传 maven 安装包

3)解压maven安装包tar xzf apache-maven-3.1.1-bin.tar.gz

4)设置软连接ln -s apache-maven-3.1.1 maven

5)设置path

打开文件

vim /etc/profile.d/maven.sh

将下面的内容复制到文件,保存

export MAVEN_HOME=/opt/maven

export PATH=${MAVEN_HOME}/bin:${PATH}

设置好Maven的路径之后,需要运行下面的命令使其生效source /etc/profile.d/maven.sh

6)验证maven是否安装成功mvn -v

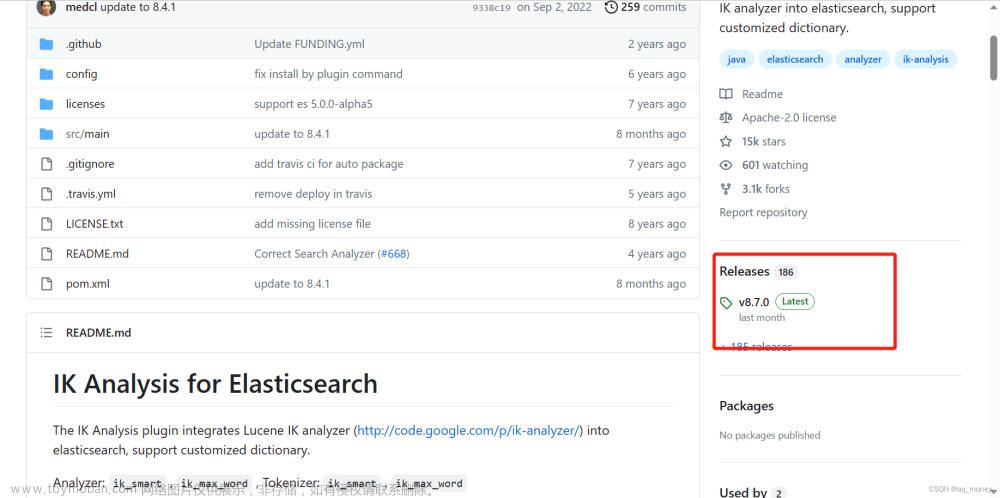

2、安装IK分词器

1)准备 IK

上传安装包

2)解压IK

由于这里是zip包不是gz包,所以我们需要使用unzip命令进行解压,如果本机环境没有安装unzip,请执行:

yum install zip

yum install unzip

解压IKunzip elasticsearch-analysis-ik-7.4.0.zip

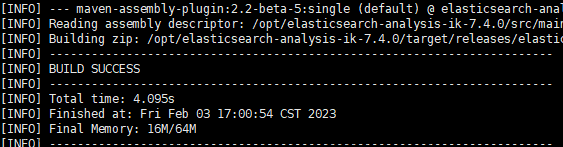

3)编译jar包

# 切换到 elasticsearch-analysis-ik-7.4.0目录

cd elasticsearch-analysis-ik-7.4.0/

#打包

mvn package

执行

mvn package命令时如果出现 打包失败(501码)将maven镜像换成阿里云的:vim /opt/apache-maven-3.1.1/conf/settings.xml

在打开的配置文件中 节点中添加如下:

alimaven

aliyun maven

http://maven.aliyun.com/nexus/content/groups/public/

central

4) jar包移动

package 执行完毕后会在当前目录下生成 target/releases 目录,将其中的 elasticsearch-analysis-ik-7.4.0.zip。

拷贝到 elasticsearch 目录下的新建的目录 plugins/analysis-ik,并解压文章来源:https://www.toymoban.com/news/detail-470009.html

#切换目录

cd /opt/elasticsearch-7.4.0/plugins/

#新建目录

mkdir analysis-ik

cd analysis-ik

#执行拷贝

cp -R /opt/elasticsearch-analysis-ik-7.4.0/target/releases/elasticsearch-analysis-ik-7.4.0.zip /opt/elasticsearch-7.4.0/plugins/analysis-ik

#执行解压

unzip /opt/elasticsearch-7.4.0/plugins/analysis-ik/elasticsearch-analysis-ik-7.4.0.zip

5)拷贝辞典

将 elasticsearch-analysis-ik-7.4.0 目录下的 config 目录中的所有文件 拷贝到 elasticsearch 的 config 目录cp -R /opt/elasticsearch-analysis-ik-7.4.0/config/* /opt/elasticsearch-7.4.0/config

记得一定要重启Elasticsearch!!!文章来源地址https://www.toymoban.com/news/detail-470009.html

到了这里,关于【ElasticSearch 】IK 分词器安装的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!