huggingface 大模型源码是什么

-

【peft】huggingface大模型加载多个LoRA并随时切换

参考Multi Adapter support 要求 peft=0.3.0 在加载第一个适配器时,可以通过 PeftModel.from_pretrained 方法并指定 adapter_name 参数来给它命名。否则,将使用默认的适配器名称 default 。 要加载另一个适配器,请使用 PeftModel 的 load_adapter() 方法,例如: model.load_adapter(peft_model_path, adapter_na

-

通过git clone批量下载huggingface模型和数据集

想要下载huggingface的模型,却发现只能一个个文件下载非常不方便,又或者官方提供的api不好用或者下载不下来,这里提供一个通过git clone一次性下载整个数据集/模型下来的高效方法。 如果不使用代理clone非常慢,可以选择先配置git全局代理。在terminal中执行如下命令: 或在

-

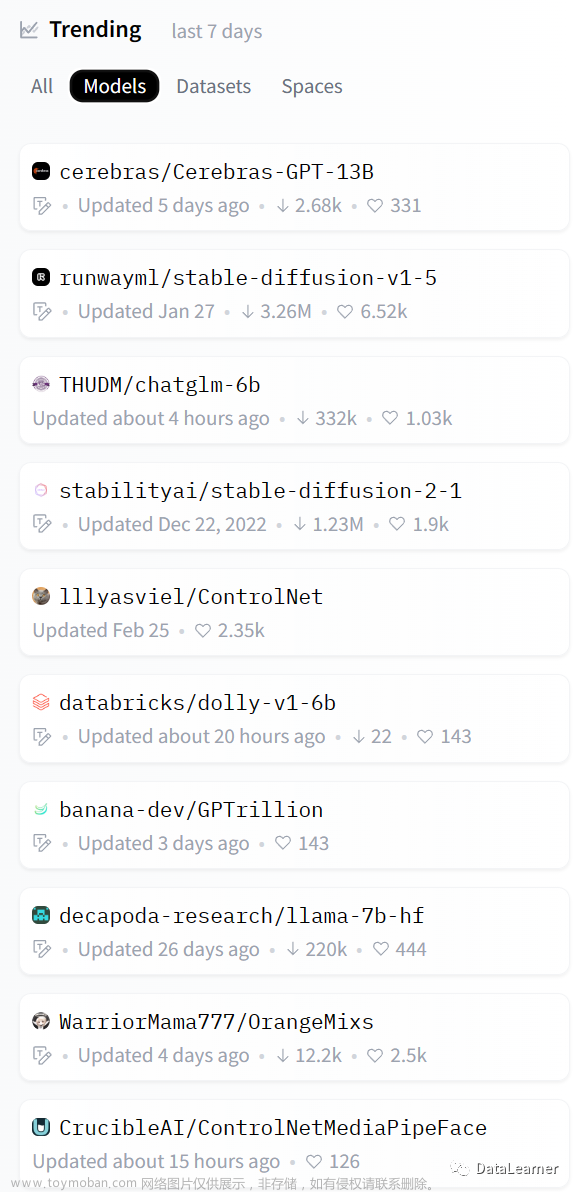

HuggingFace过去七天最流行的AI模型一览——预训练大模型绝对王者

HuggingFace是目前最火热的AI社区,很多人称之为AI模型的GitHub。包括Google、微软等很多知名企业都在上面发布模型。 HuggingFace简介:https://www.datalearner.com/blog/1051636550099750 而HuggingFace上提供的流行的模型也是大家应当关注的内容。本文简单介绍一下2023年4月初的七天(当然包括

-

centOs安装git-lfs并下载huggingface模型

hf模型都是用git-lfs托管的,可以直接git下载的,天才第一步: 1、安装git-lfs 2、直接git clone 3、测试模型opt-1.3b

-

[AI]如何让语言模型LLMs流式输出:HuggingFace Transformers实现

HugginFace Transforms是一个非常方便的库,集成了非常多SOTA的模型,包含:LLAMA, GPT, ChatGLM Moss,等。目前基本上主流的方案都是基于HugginFace Transforms这个框架实现的。以前如果要流式输出需要自己去改模型底层的推理逻辑。 如ChatGLM,自己实现的流式输出如下: hugging face也注意到

-

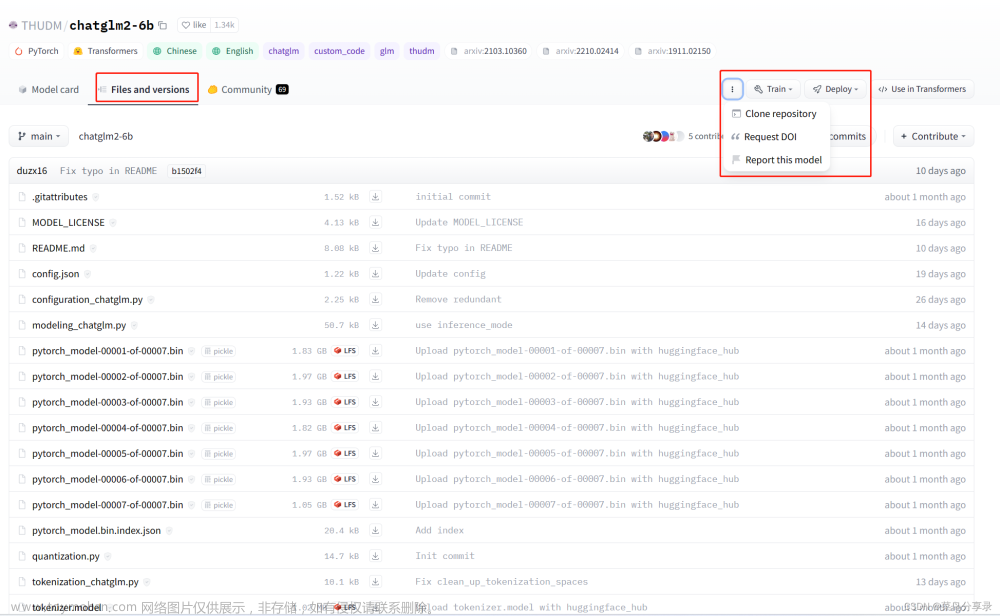

通过clone的方式,下载huggingface中的大模型(git lfs install)

1、如图:可以手动一个个文件下载,但是那样太慢了,此时,可以点击下图圈起来的地方。 2、点击【Clone repository】,在命令行中,输入【git lfs install】(安装了这个,才会下载大文件,不然图中的.bin文件都是不会被下载的) 3、再git clone https://huggingface.co/THUDM/chatglm2-6b,在

-

[linux] huggingface transformers 如何下载模型至本地 & git lfs install 报错

bert-base-uncased at main 但是 git lfs install 的时候报错。 于是查了一下。。。。安装lfs是要这样: You can\\\'t directly use Instead of that, you can use these commands to download and install (you have to download it before installing). 网络不好mac报错:重新安了一下brew install git-lfs。。 如果失败,则。。。可能

-

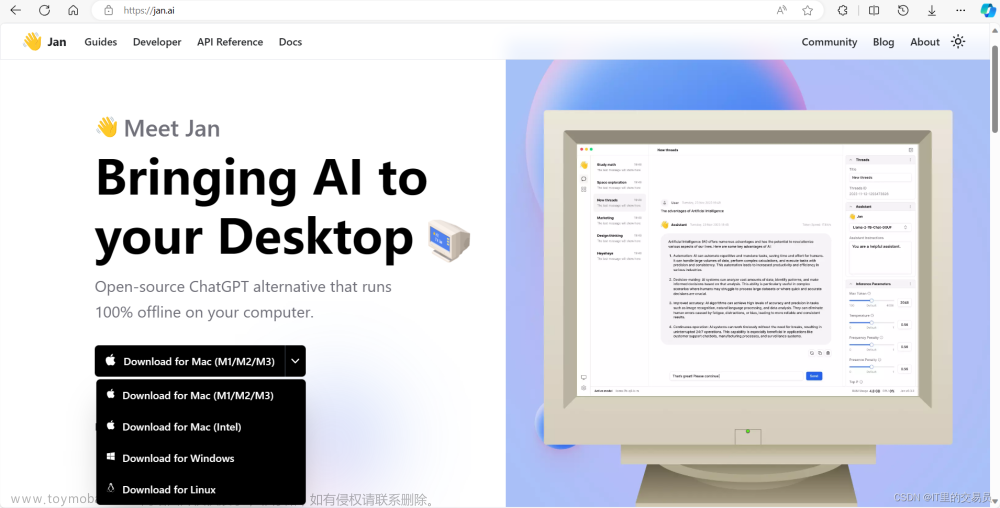

【AI之路】使用Jan.ai在本地部署大模型开启AI对话(含通过huggingface下载大模型,实现大模型自由)

2023年是AIGC元年。以后,每个人多少都会接触到GPT带来的变化。别人都在用,我们也不能落下。ChatGPT咱用不了,可以用国内的各种大模型。另外,我们还可以把大模型放到本地电脑上运行,不信?咱往下看! 使用Jan.ai在本地调用大模型进行对话 下面就让我们的主角登场。

-

Google DeepMind发布Imagen 2文字到图像生成模型;微软在 HuggingFace 上发布了 Phi-2 的模型

🦉 AI新闻 🚀 Google DeepMind发布Imagen 2文字到图像生成模型 摘要 :谷歌的Imagen 2是一种先进的文本到图像技术,可以生成与用户提示紧密对齐的高质量、逼真的图像。它通过使用训练数据的自然分布来生成更逼真的图像,而不是采用预先编程的风格。该技术还改善了图像-标题

-

【Linux】【chatGLM-6B】如何从huggingface上下载chatGLM-6B模型于centos系统

从 https://github.com/git-lfs/git-lfs/releases 这个网址上选择以下框框中的内容进行下载 tar -zxvf git-lfs-linux-amd64-v2.12.1.tar.gz sudo ./install.sh 输入如下代码开始下载: git lfs clone https://huggingface.co/chatglm-6b 直接git clone下载的文件都特别小,不像是完整版的

-

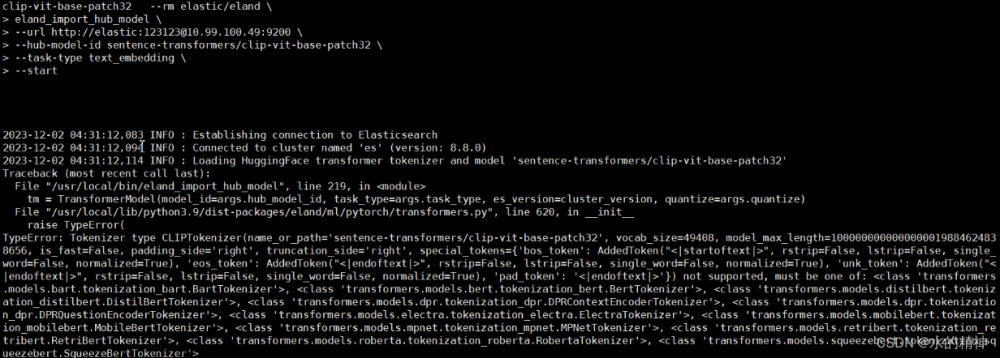

elasticsearch 内网下如何以离线的方式上传任意的huggingFace上的NLP模型(国内避坑指南)

es自2020年的8.x版本以来,就提供了机器学习的能力。我们可以使用es官方提供的工具eland,将hugging face上的NLP模型,上传到es集群中。利用es的机器学习模块,来运维部署管理模型。配合es的管道处理,来更加便捷的处理数据。 但是在国内操作,根据官方文档

-

LLM-LLaMA:手动模型转换与合并【Step 1: 将原版LLaMA模型转换为HF(HuggingFace)格式;Step 2: 合并LoRA权重,生成全量模型权重】

准备工作 运行前确保拉取仓库最新版代码: git pull 确保机器有足够的内存加载完整模型(例如7B模型需要13-15G)以进行合并模型操作。 务必确认基模型和下载的LoRA模型完整性,检查是否与SHA256.md所示的值一致 ,否则无法进行合并操作。原版LLaMA包含: tokenizer.model 、 tokeni

-

huggingface如何使用ssh命令,下载数据集或者模型 比如:git clone git@hf.co:openchat/openchat_8192

今天抽空整理了一下笔记。 #linux服务器中,使用ssh下载huggingface模型或者数据集 1.访问huggingface个人主页(profile)里的settings https://huggingface.co/settings/profile 2.点击左侧:SSH AND GPG keys 先开始准备工作: 准备工作:https://huggingface.co/docs/hub/security-git-ssh#generating-a-new-ssh-keypair 准备

-

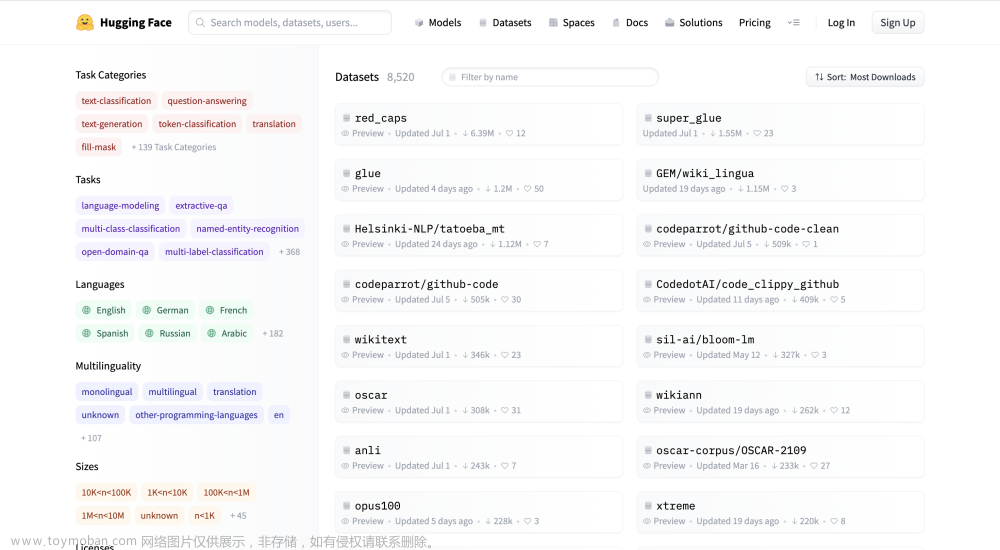

HuggingFace简明教程

视频链接:HuggingFace简明教程,BERT中文模型实战示例.NLP预训练模型,Transformers类库,datasets类库快速入门._哔哩哔哩_bilibili 什么是huggingface?huggingface是一个开源社区,它提供了先进的NLP模型,数据集,以及其他便利的工具。 数据集:Hugging Face – The AI community building the future. 这

-

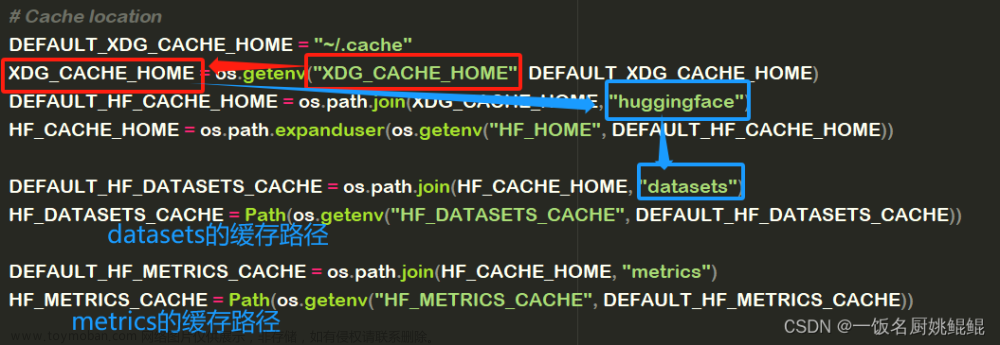

修改huggingface的缓存路径

最近查了一下C盘爆满的原因,发现了huggingface的缓存文件这个罪魁祸首。 每次 远程导入 模型 、 数据集 时,都会启用huggingface的缓存机制,将整个大文件下载至 缓存目录 中,从而保证下一次加载时非常快速。 我们可以发现,默认的缓存目录就是设置在C盘。 下面是更改存放

-

使用HuggingFace进行情感分类

1.安装transformers !pip install transformers 2.调用接口进行情感分析 [{\\\'label\\\': \\\'POSITIVE\\\', \\\'score\\\': 0.9934802055358887}] [{\\\'label\\\': \\\'NEGATIVE\\\', \\\'score\\\': 0.6318379640579224}]

-

调研:huggingface-diffusers

Diffusers是集成state-of-the-art预训练diffusion模型库,用于生成图像、音频甚至3D结构。 Diffusers库注重可用性而非高性能。 Diffusers主要提供三项能力: State-of-the-art diffusion pipelines,低代码推理。 Interchangeable noise schedulers,便于平衡生成速度和质量。 Pretrained models,构建自己的dif

-

huggingface transformers库中LlamaForCausalLM

新手入门笔记。 LlamaForCausalLM 的使用示例,这应该是一段推理代码。 参考: Llama2 https://huggingface.co/docs/transformers/v4.32.1/en/model_doc/llama2#transformers.LlamaForCausalLM

-

LLM-LLaMA:使用Huggingface提供的脚本文件,对原始的LLaMA-13B转换为Huggingface的格式

使用Huggingface提供的脚本文件,对原始的 LLaMA-13B 转换为Huggingface的格式,具体的脚本文件在此处。下面是运行的命令(假设下载的原始文件位于 ./ 下,希望转换后的路径为 ./converted ): convert_llama_weights_to_hf.py

-

Stable Diffusion实现之 Huggingface

Stable Diffusion AI是指将Stable Diffusion模型应用于人工智能领域的相关技术和方法。通常情况下,Stable Diffusion AI主要用于金融、投资等领域,并且广泛应用于期权定价、风险管理等方面。其应用范围也在不断扩大,目前已经被用于自然语言处理、图像处理等领域。 在金融和投资领

![[linux] huggingface transformers 如何下载模型至本地 & git lfs install 报错](https://imgs.yssmx.com/Uploads/2024/02/688167-1.png)